рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Философия

- /

- Взаимная информация и ее свойства. Условная энтропия.

Реферат Курсовая Конспект

Взаимная информация и ее свойства. Условная энтропия.

Взаимная информация и ее свойства. Условная энтропия. - раздел Философия, Дисциплина Теория информации Тема №2: Меры информации Рассмотрим Два Дискретных Источника A И B. Объединим Их События В Пары (A...

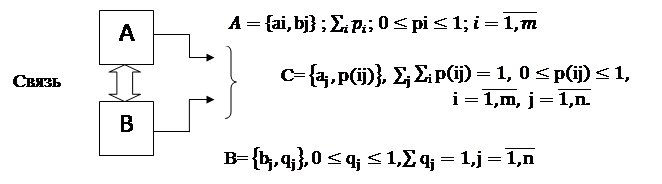

Рассмотрим два дискретных источника A и B. Объединим их события в пары (ai,bj) объединенной вероятностной схемой C=AB. Мы получим простейшую модель связанных источников (рис.1)

Рис. 1 – Модель двух связанных источников

Если два источника считать связанными друг с другом, то следует ожидать, что событие одного источника позволяют делать некоторые предположения о событиях другого. В терминах теории информации это означает, что неопределенность второго источника снижается, т.е. источники обмениваются взаимной информацией.

Для совместных событий известно, что

Или в обозначениях x:

p(ij)=pipij=qjpji

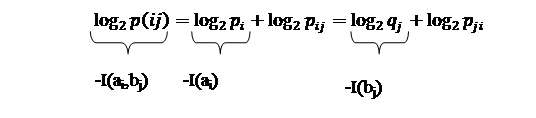

Прологарифмируем данное выражение:

|

Где  - совместная информация объединенной вероятностной схемы C=AB или собственная информация пары событий.

- совместная информация объединенной вероятностной схемы C=AB или собственная информация пары событий.

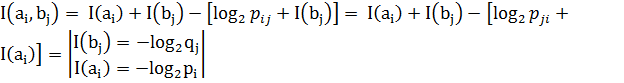

Тогда

Прибавляя и одновременно вычитая  а первой части равенства, а

а первой части равенства, а

=

= .

.

Таким образом, собственная информация  пары событий

пары событий  определяется суммой собственных информаций

определяется суммой собственных информаций  этих событий за вычетом некоторой неотрицательной величины, которая снижает неопределенность, т.е. она сама в свою очередь является информацией. Эту величину называют взаимной информацией пары событий:

этих событий за вычетом некоторой неотрицательной величины, которая снижает неопределенность, т.е. она сама в свою очередь является информацией. Эту величину называют взаимной информацией пары событий:

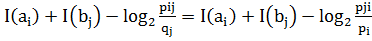

Для объединенной вероятностной схемы C=AB можно записать:

,

,

также случайная величина, тогда математическое ожидание этой случайной величины E будет равно:

также случайная величина, тогда математическое ожидание этой случайной величины E будет равно:

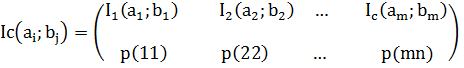

Ic(A;B)=

Ic(A;B) – взаимная информация сообщения C (или объединенной вероятностной схемы)

– Конец работы –

Эта тема принадлежит разделу:

Дисциплина Теория информации Тема №2: Меры информации

Тамбовский государственный технический университет... Кафедра Информационные системы... Дисциплина Теория информации...

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ: Взаимная информация и ее свойства. Условная энтропия.

Что будем делать с полученным материалом:

Если этот материал оказался полезным ля Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Хотите получать на электронную почту самые свежие новости?

Новости и инфо для студентов