рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Философия

- /

- Понятие совместной энтропии.

Реферат Курсовая Конспект

Понятие совместной энтропии.

Понятие совместной энтропии. - раздел Философия, Дисциплина Теория информации Тема №2: Меры информации Для Двух Источников, Образующих Объединенную Вероятностную Схему, Используя П...

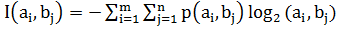

Для двух источников, образующих объединенную вероятностную схему, используя понятие совместной вероятности пары событий p(ai,bj), можно определить среднюю информацию всех пар событий:

H(AB) = E – совместная энтропия двух дискретных источников

– совместная энтропия двух дискретных источников

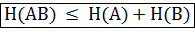

Не сложно доказать, что

H(AB)=H(A)+H(B/A)=H(B)+H(A/B)

Если источники независимы, справедливо:

H(A/B)=H(A), H(B/A)=H(B)., тогда очевидно, что для связанных источников

H(A/B) H(A); H(B/A)

H(A); H(B/A) H(B).

H(B).

Поэтому в общем случае справедливо соотношение:

Сведем все проведенные рассуждения в единую таблицу характеристик пары дискретных источников:

– Конец работы –

Эта тема принадлежит разделу:

Дисциплина Теория информации Тема №2: Меры информации

Тамбовский государственный технический университет... Кафедра Информационные системы... Дисциплина Теория информации...

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ: Понятие совместной энтропии.

Что будем делать с полученным материалом:

Если этот материал оказался полезным ля Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Хотите получать на электронную почту самые свежие новости?

Новости и инфо для студентов