Дискретные источники без памяти и с памятью.

До сих пор мы рассматривали простейший источник информации - так называемый дискретный источник без памяти. Напомним, что такой источник X в каждый фиксированный момент времени выдает некоторый символ из конечного алфавита X=

из конечного алфавита X= с вероятностью

с вероятностью  , выборка символов производится независимо друг от друга.

, выборка символов производится независимо друг от друга.

Для такого источника мы получили информационные меры, в том числе по Шеннону, которые определяется заданной вероятностной схемой сообщения такого источника.

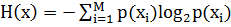

Напомним, что энтропией дискретного источника без памяти является усредненное на алфавите источника количество информации, приходящееся на один символ (одно событие):

, i=

, i= .

.

Кроме того, нами были получены выражения для совместной и условной энтропий пары дискретных источников без памяти, а также выражения для взаимной информации источников.

Кроме рассмотренного, на практике широко используется понятие стационарного дискретного источника с памятью.

Например, если считать, что выходом источника является дискретизированный аналоговый сигнал (например, речевой), то соседние отсчеты такой дискретной последовательности будут как бы взаимосвязанными по времени, т.е. обладать некоторой памятью.

|

А такой источник называют дискретным источником с памятью.

Определение: Дискретный источник с памятью Х можно представить как дискретизированный во времени стохастический (случайный) процесс, реализацией которого является последовательность событий xn, принадлежащих алфавиту источника.

И если совместные вероятности этих последовательностей событий xn не зависят от выбора начальной точки отсчета времени, то дискретный источник с памятью является стационарным.

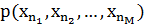

Следовательно, стационарный дискретный источник с памятью математически полностью считается описанным, если известны все совместные вероятности  для любой выборки

для любой выборки  , где

, где  .

.

Определение энтропии стационарного дискретного источника с памятью следует из двух подходов, приводящих к одинаковому решению.

При первом подходе используют понятие совместной энтропии, при втором - условной энтропии.

И это понятно, если учесть, что в энтропии должно быть учтено свойство памяти источника, которое распространяется на несколько последовательных событий. А это означает, что отдельное событие несет дополнительную информацию, если блок предшествующих событий уже известен.

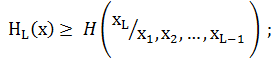

Можно доказать, что:

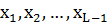

где  - энтропия стационарного дискретного источника с памятью;

- энтропия стационарного дискретного источника с памятью;

– совместная энтропия L последовательных источников;

– совместная энтропия L последовательных источников;

- условная энтропия источника

- условная энтропия источника  при условии, что события предыдущих источников

при условии, что события предыдущих источников  , известны.

, известны.

Для стационарного дискретного источника с памятью известна теорема, сформулированная Шенноном:

Если то имеет место:

то имеет место:

1.

2.  не возрастают с ростом длины блока L.

не возрастают с ростом длины блока L.