Некоторые сведения из теории статистических решений

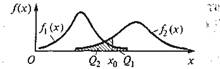

Рассмотрим основные результаты теории статистических решений на следующем примере. Пусть совокупность объектов подразделена на классы Ω1 и Ω2, а для характеристики объектов используется признак х [15]. Известны описания классов — условные плотности распределения вероятностей f1 (х) и f2 (х) значений признака объектов классов Ω1 и Ω2, а также априорные вероятности P(Ω1) и Р(Ω2) появления объектов. В результате эксперимента определено значение признака х00 распознаваемого объекта (рис. 4.1).

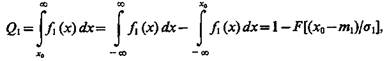

Чтобы определить, к какому классу отнести объект, обозначим х0 некоторое, пока неопределенное значение признака х и условимся о следующем правиле принятия решений: если измеренное значение признака у распознаваемого объекта х0>х0, то объект будем относить к классу Ω2, если х0£х0,— к классу Ω1 Если объект относится к классу Ω1 а его считают объектом класса Ω2, то совершена ошибка — ошибка первого рода, условная вероятность которой

(4.1)

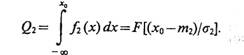

По терминологии теории статистических решений, ошибочно выбрана гипотеза Н2, в то время как справедлива гипотеза Н1. Наоборот, если справедлива гипотеза Н2, а отдано предпочтение гипотезе Нх, то совершена ошибка второго рода, условная вероятность которой

(4.2)

По терминологии теории статистических решений, ошибочно выбрана гипотеза Н1 в то время как справедлива гипотеза Н2.

В некоторых приложениях теории статистических решений вероятность ошибки первого рода называют вероятностью ложной тревоги, а вероятность ошибки второго рода — вероятностью пропуска цели.

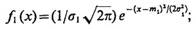

Пусть значения признака х у объекта в каждом классе подчинены нормальным законам распределения с математическими ожиданиями m1 и m2 и среднеквадратичными отклонениями s1 и s2, соответственно:

(4.3)

(4.4)

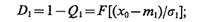

Если в (4.1) подставить (4.3), то условная вероятность ошибки первого рода

(4.5)

где  — функция Лапласа.

— функция Лапласа.

Рис. 4.1

Если в (4.1) подставить (4.4), то условная вероятность ошибки второго рода

(4.6)

Условные вероятности правильных решений при справедливости гипотез Н1 и Н2, соответственно

(4.7)

(4.8)

В теории статистических решений D1 — размер испытаний, a D2 = 1 — Q2 — мощность испытаний.

В (4.5) и (4.6) при интегрировании функций f1(х) и f2(х) в пределах — ¥ — х0 произведена замена (х0-m)/s на t, которая приводит к интегралам вида

Для вычисления этих интегралов, поскольку они не выражаются через элементарные функции, пользуются таблицами специальных функций [16]:

(4.9)

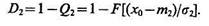

Соображения, которыми следует руководствоваться при выборе значения признака х0 (при разделении пространства признака х на два полупространства: R1 и R2), должны учитывать потери, сопряженные с правильными и ошибочными решениями. Функции потерь, характеризующие потери при совершении ошибок первого и второго рода, а также потери правильных решений, образуют в данном случае платежную матрицу вида

(4.10)

где с11 и с22, с12 и с21 — потери, связанные соответственно с правильными решениями и ошибками первого и второго рода.

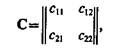

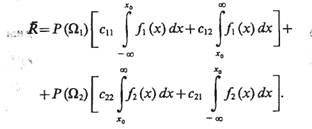

Средний риск при многократном распознавании неизвестных объектов равен сумме потерь, связанных с неправильными и правильными решениями, с учетом вероятностей их появления и априорных вероятностей поступления на вход системы распознавания объектов классов Ω1 и Ω2.

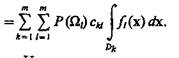

(4.11)

Подставив в (4.11) выражения (4.1) и (4.2), получим

(4.12)

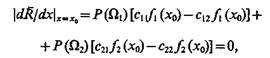

Системы распознавания — системы многократного действия. Поэтому необходимо, чтобы выбор значения х0 был осуществлен с учетом того, что Rã минимален. Для определения значения х0, при котором средний риск минимален, продифференцируем Rã по х и приравняем производную нулю, положив х=х0:

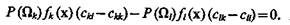

(4.13)

откуда

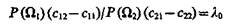

(4.14)

Отношение условных плотностей распределения f2(x)/f1(x) = l(х) называют коэффициентом правдоподобия или отношением правдоподобия. Правая часть (4.14)

(4.15)

определяет собой пороговое (критическое) значение коэффициента правдоподобия.

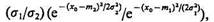

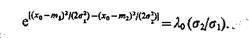

Определим значение х0 при условии, что значения признака х у объектов, относящихся к классам Ω1 и Ω2, подчинены нормальным законам распределения N1 (x, m1 s1) и N2 (x, m2, s2) соответственно. Для этого подставим в (4.14) значения f1(x) и f2(х), определяемые (4.3) и (4.4), т. е.  откуда

откуда

(4.16)

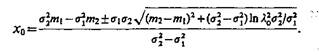

Решая (4.16) относительно х0, получим

(4.17)

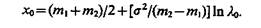

В частном случае, когда s1 = s2 = s, из (4.16) находим

(4.18)

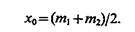

И если c11=с22 = 0, c12 = c21 и P(Ωl) = P(Ω2), то

(4.19)

Значение х0 позволяет оптимальным образом (в смысле минимума среднего риска) разделить признаковое пространство на области R1 и R2. Область R1 состоит из х£х0, для которых l(х) £l0, а область R2 — из х > х0, для которых l(х) > l0. Поэтому решение об отнесении объекта к классу Ω следует принимать, если значение коэффициента правдоподобия меньше его критического значения, а решение об отнесении объекта к классу Ω2 — при противоположной ситуации. В общем случае, когда число классов m > 2, а объекты описываются набором признаков x1, ..., xN или вектором х={х1 ..., хN}, отношение правдоподобия между классами Ωk и Ωl будет xkl=fk(x)/fl(x), k, l=1, ..., m, платежная матрица имеет вид (1.7), а величина Rã=

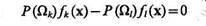

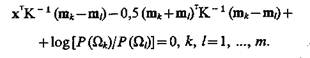

Из условия минимума значения среднего риска уравнение границы в многомерном пространстве признаков между областями Dk и Di, соответствующими классам Ωk и Ωl, будет

(4.20)

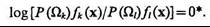

Если полагать сkk=сll=0, a ckl=clk=l, то

(4.21)

или

*3десь и в § 4.6 log=log;.

(4.22)

Пусть fi(х) = ехр[0,5(х-mi)TKi-1(х-mi)]/[(2π)1/2Ki1/2], i=l, .... m,— функция плотности многомерного нормального закона распределения со средним вектором mi, и ковариационной матрицей Кi.

Тогда уравнение границы

*3десь и в § 4.6 log=log;.

(4.23)

Если Kk=Kl=K, то

(4.24)

Уравнение (4.24) — уравнение гиперплоскости, разделяющей с точки зрения минимальных средств потерь наилучшим образом многомерное признаковое пространство на области, соответствующие классам Ωk и Ωl, k, 1=1, ..., m.