Алгоритмы распознавания, основанные на вычислении оценок

Логические алгоритмы распознавания, рассмотренные выше, в ряде случаев не позволяют получить однозначное решение о принадлежности распознаваемого объекта к определенному классу. Ю. И. Журавлевым предложен класс алгоритмов, называемый алгоритмами распознавания, основанными на вычислении оценок (АВО), который дает возможность получить однозначное решение о принадлежности объекта к определенному классу [25, 26].

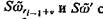

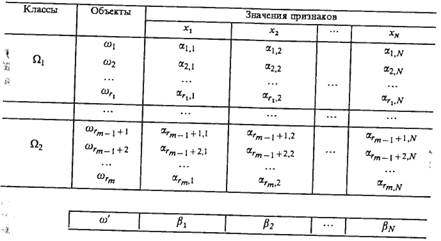

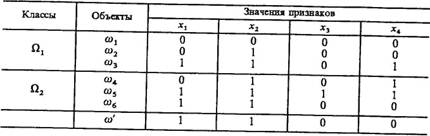

Пусть множество объектов {w} подразделено на классы Ωi, i=1, ..., m, и для описания объектов используются признаки хj, j=1, ..., N. Все объекты описываются одним и тем же набором признаков. Каждый из признаков может принимать значения из различных множеств, например, из следующих: {0, 1}, 0 — признак не выражен, 1 —признак выражен; {0, 1, ´}, ´ —информация о признаке отсутствует; {0, 1, ..., d} —степень выраженности признака имеет различные градации; [а, b] — признак принимает значения из числового отрезка; fi(x1 ..., xN) — условная плотность распределения значений признаков. Априорная информация представляется в виде таблицы, содержащей описания на языке признаков {х1, ..., xN] всех объектов, принадлежащих различным классам (табл. 7.1). Алгоритм распознавания сравнивает описание распознаваемого объекта с описаниями всех объектов, содержащихся в таблице, и принимает решение о том, к какому классу отнести объект. Классификация основана на вычислении степени похожести (оценки) распознаваемого объекта, на объекты, принадлежность которых к классам известна. Эта процедура включает в себя два этапа: сначала подсчитывается оценка для каждого объекта из таблицы, а затем полученные оценки используются для получения суммарных оценок по каждому из классов Ωi.

Опыт решения задач распознавания свидетельствует о том, что часто основная информация заключена не в отдельных признаках, а в их различных сочетаниях. Так как не всегда известно, какие именно сочетания информативны, то в АВО степень похожести объектов вычисляется не последовательным сопоставлением отдельных признаков, а сопоставлением всех возможных (или определенных) сочетаний признаков, входящих в описание объектов.

Рассмотрим полный набор признаков х = {х1, ..., xN} и выделим систему подмножеств множества признаков (систему опорных множеств алгоритма) S1, ..., Sl. В АВО при наличии ограничений на систему опорных множеств обычно рассматриваются либо все подмножества множества признаков фиксированной длины k, k=2,..., N— 1, либо вообще все подмножества множества признаков.

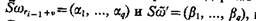

Удалим произвольный поднабор признаков из строк w1 w2,..., wrm, w¢ и обозначим полученные строки Sw1, Sw2,..., Swrm, Sw¢. Правило близости, позволяющее оценить похожесть строки Sw¢, соответствующей распознаваемому объекту w¢, и строки Swri-l+v, соответствующей произвольному объекту исходной таблицы, состоит в следующем (индекс v-гo объекта класса Ωi, представляет собой сумму порядкового номера последнего объекта предшествующего класса Ωi-1 — ri-1 и порядкого номера v рассматриваемого объекта в данном класе Ωi,; естественно, 1£v£ri-ri-1. Пусть «усеченные» строки содержат q первых признаков, т. е.  и заданы пороги e1 ..., eq, d.

и заданы пороги e1 ..., eq, d.

Строки  читаются похожими, если выполняется не менее чем d неравенств вида

читаются похожими, если выполняется не менее чем d неравенств вида

Величины e1 ..., eq входят в качестве параметров в АВО.

Таблица 7.1

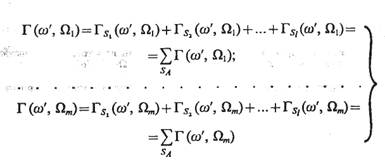

Рассмотрим процедуру вычисления оценок по подмножеству S1. Для остальных подмножеств она полностью аналогична. В табл. 7.1 выделяются столбцы, соответствующие признакам, входящим в S1 остальные столбцы вычеркиваются. Проверяется близость строки S1w¢ со строками S1w1 ..., S1 wr1, принадлежащими объектам класса Ωi. Число строк этого класса, близких по выбранному критерию классифицируемой строки S1w¢, обозначается Гs1 (w¢, Ω1); последняя величина представляет собой оценку строки w¢ для класса Ωi по опорному множеству S1. Аналогичным образом вычисляются оценки для остальных классов: Гs2(w¢, Ω2), ..., Гs2 (w¢, Ωm). Применение подобной процедуры ко всем остальным опорным множествам алгоритма позволяет получить систему оценок Гs2 (w¢, Ω1), ..., Гs2 (w¢, Ωm), ..., Гsl (w¢, Ω1)..., Гsl (w¢, Ωm). Величины

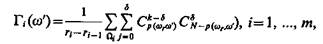

(7.65)

представляют собой оценки строки w¢ для соответствующих классов по системе опорных множеств алгоритма SA. На основании анализа этих величин принимается решение либо об отнесении объекта w¢ к одному из классов Ωi, i= 1,..., m, либо об отказе от его распознавания. Решающее правило может принимать различные формы, в частности распознаваемый объект может быть отнесен к классу, которому соответствует максимальная оценка, либо эта оценка будет превышать оценки всех остальных классов не меньше чем на определенную пороговую величину h1 либо значение отношения соответствующей оценки к сумме оценок для всех остальных классов будет не менее значения порога h2 и т. д. Параметры типа hх и h2 также включаются в АВО.

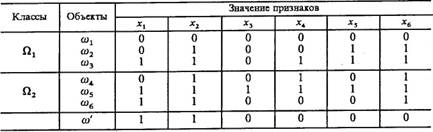

Пример. Заданы следующая таблица обучения и подлежащий распознаванию объект w¢:

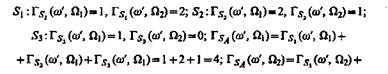

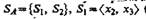

Пусть S1= <x1, x2,> S2 = <x3,x4>, S3 = <x5,x6>; строки будем считать близкими, если они полностью совпадают.

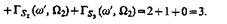

Применение вышеописанной процедуры вычисления оценок позволяет получить следующее:

Согласно решающему правилу, реализующему принцип простого большинства голосов, объект со' относится к классу Ωi так как Г (w¢, Ω1)>Г(w¢, Ω2).

Последовательность реализации процедуры распознавания в соответствии с АВО такова: 1) выделяется система опорных множеств алгоритма, по которым производится анализ распознаваемых объектов; 2) вводится понятие близости на множестве частей описаний объектов; 3) задаются правила: а) позволяющие по вычисленной оценке степени подобия эталонного и распознаваемого объекта вычислить величину, называемую оценкой для пар объектов; б) формирования оценок для каждого из классов по фиксированному опорному множеству на основе оценок для пар объектов; в) формирования суммарной оценки для каждого из классов по всем опорным подмножествам; г) принятия решения, которое на основе оценок для классов обеспечивает отнесение распознаваемого объекта к одному из классов или отказывает ему в классификации.

Способ выбора системы опорных множеств, тип функции близости, правила вычисления оценок и решающие правила определяют АВО, а задание значений соответствующих параметров — конкретный алгоритм. Варьируя способ выбора и параметры, можно добиться определения такого АВО, который обеспечивает наилучшее решение задачи распознавания (например, с точки зрения минимума ошибок и отказов от распознавания).

Организация вычислительной процедуры непосредственно в соответствии с приведенным описанием алгоритма при большой мощности системы опорных множеств требует значительного числа машинных операций. В связи с этим для вычисления оценок, определяющих принадлежность распознаваемого объекта некоторому классу, выведены простые аналитические формулы, заменяющие сложные переборные процедуры.

Остановимся на аналитических формулах, обеспечивающих эффективное вычисление оценок Гi(w¢) при различных способах задания системы опорных множеств АВО:

1. Эффективные формулы при наличии ограничений на систему опорных множеств [25]:

a) SA совпадает с системой всех подмножеств мощности к множества {х1 ..., xN}:

(7.66)

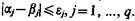

где р (wr, w¢) — число выполненных неравенств вида

б) SA совпадает с системой всех непустых подмножеств множества {х1 ..., xN}:

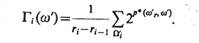

(7.67)

Пример. Проиллюстрируем применение формулы (7.67) на задаче, рассмотренной в предыдущем примере. Для вычисления оценок распознаваемого объекта w¢ по классам Ω1 и Ω2 необходимо определить величины р (w1, w¢),..., р (w6, w¢); как и раньше, будем полагать e1, ..., e6=0. В таком случае имеем: p(w1, w¢) =4; р(w2, w¢) = 3; р(w3, w¢)=3; р(w4, w¢) = 3; р(w5, w¢) = 2; р(w6, w¢) =5. Применение формулы (7.67) позволяет вычислить значения оценок Г1(w¢)=(1/3) [(24-1)+(23-1)+(23-1)]=29/3, Г2(w¢)=1/3[(23-1) + (22-1)+(25-1)]=41/3. Подстановка значений этих оценок в решающее правило, реализующее принцип простого большинства, приводит к отнесению объекта со' к классу П2. Расхождение с результатом предыдущего примера определяется изменением системы опорных множеств алгоритма. Оно лишний раз свидетельствует о том, как необходимо чрезвычайно внимательно относиться к тому, по каким признакам и комбинациям признаков следует сопоставлять объекты при распознавании.

Отметим, что число непустых подмножеств множества, содержащего шесть признаков, равно 26— 1 =63. Таким образом, при отсутствии формулы, элиминирующей перебор, процедуру прямого сравнения распознаваемого объекта, w¢ со строками обучающей таблицы по всем опорным множествам пришлось бы выполнить 6×63 = 378 раз.

2. Эффективные формулы при отсутствии ограничений на систему опорных множеств [26].

Практика распознавания показывает, что в некоторых случаях априори известны поднаборы признаков, которые следует учитывать при сопоставлении распознаваемого объекта с объектами обучающей таблицы. Эти подмножества признаков не всегда совпадают с частными случаями (7.66) и (7.67); они могут иметь различную длину, исключать запрещенные комбинации и т. п. В [26] аналитические формулы получены для случая произвольных опорных множеств.

Расширение области применения АВО основано на введении характеристической булевой функции системы опорных множеств алгоритма fSA и установлении взаимно однозначного соответствия между подмножествами множества признаков и булевыми векторами длины N (вершинами N-мерного единичного куба) [26].

Пример. Заданы таблица обучения и подлежащий распознаванию объект w¢ (W=4):

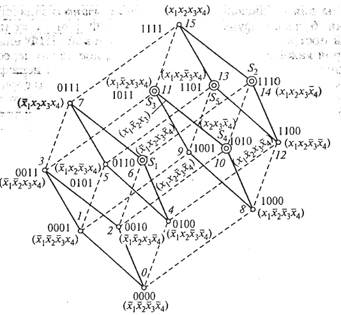

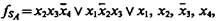

Закодировав вхождение признака в опорное множество через 1, а невхождение — через 0, каждому подмножеству множества признаков <х1, х2, х3, х4> можно сопоставить бинарный вектор, или, что то же самое, вершину единичного четырехмерного куба (рис. 7.3).

На множестве этих векторов можно определить характеристическую булеву функцию, единицы которой будут определять подмножества множества признаков, включенные в систему опорных множеств алгоритма SA.

Пусть  (вершина 6),

(вершина 6),  ,(вершина 14).

,(вершина 14).

В таком случае

В [26] показано, что в тех случаях, когда множество единиц fsA образует в единичном Af-мерном кубе интервал или сумму непересекающихся интервалов, также существуют аналитические формулы для вычисления оценок. Напомним, что подмножество вершин единичного N-мерного куба называется интервалом, если оно соответствует некоторой элементарной конъюнкции. Очевидно, что все грани, ребра и вершины единичного N-мерного куба являются интервалами.

Система опорных множеств организована следующим образом (соответствующий интервал представлен ребром, соединяющим вершины 6 и 14): в нее включены все признаки, входящие в ДНФ характеристической функции без отрицания (х2 и х3), не включены признаки, входящие в ДНФ с отрицанием (х4), а по остальным признакам (х1) происходит полная вариация, т. е. рассматриваются подмножества, как включающие, так и не включающие эти признаки (xl, x2, х3 и х2, х3).

Эффективная аналитическая формула для вычисления оценок в случаях, когда характеристической функции системы опорных множеств соответствует интервал, имеет вид

(7.68)

В (7.68) учитывается вклад только тех строк таблицы обучения («эффективных»), постоянная часть которых (в нашем случае <x2,x3> близка постоянной части w¢; р* (w¢r„ w¢) — число выполненных неравенств вида |aj-bj|£ej,- на варьируемой части (здесь <x1>).

Рис. 7.3

Таким образом, при условии e1 ..., e6=0 и, учитывая, что эффективны в Ω1 строки w1 и w3, в Ω2 — строки w4 и w6, р* (w¢2, w¢)= = 0,р*( w¢3, w¢) = 1, р*( w¢4, w¢)=0, р*( w¢6, w¢)=1, имеем: Г1(w¢)-= (1/3)(20 + 21)=1;Г2=(w¢) = (1/3)(20+21)=1.

Полученный результат означает, что при указанном выборе системы опорных множеств строка w¢ не классифицируется.

Если характеристической функции соответствует сумма непересекающихся интервалов (представляется ортогональной ДНФ), как, например, в случаях SA = {S1, S2, S3, S4, S5}, S1 = <x2, x3> (вершина б), S2 = <x1, x2, x3> (вершина 14), S3 = <x1, x3, x4> (вершина 11), S4=<x1, x3> (вершина 10), S5 = <x1, x2, x4> (вершина 13),  то при вычислении оценок (7.68) применяется к каждому интервалу отдельно и результаты суммируются.

то при вычислении оценок (7.68) применяется к каждому интервалу отдельно и результаты суммируются.

В [26] показано, что сложность формулы вычисления оценок в АВО при произвольной SA пропорциональна сложности ДНФ, представляющей характеристическую функцию системы опорных множеств алгоритма. Это означает, что построение простой формулы для вычисления оценок Гi(w¢) связано с задачей минимизации булевых функций в классе ДНФ [36], а точнее — с задачей построения кратчайшей ортогональной ДНФ или ДНФ, в которой каждый интервал имеет небольшое число пересечений с соседними. В общем случае задача такого синтеза неразрешима и потому следует пользоваться приближенными алгоритмами, обеспечивающими получение «достаточно простых» ортогональных ДНФ или ДНФ с небольшим числом взаимных пересечений интервалов [26].

Таким образом, если для вычисления расстояний rj(aj, bj) существует эффективный алгоритм и число операций при одном таком вычислении не превосходит некоторой величины Q, то число операций при вычислении всех величин Гi(w¢),i=1, ..., m не превосходит 2QNm.

Число операций при распознавании одного объекта в фиксированном алгоритме А пропорционально «площади» таблицы ТN,m с коэффициентом пропорциональности, не превосходящим 2Q.

Сведение задачи построения экстремальных алгоритмов типа АВО к отысканию экстремумов функции многих переменных было обосновано Ю. И. Журавлевым. Для проведения оптимизации могут быть применены методы переборного типа (при небольшом числе параметров), градиентного типа или случайного поиска.

АВО успешно используется для решения задач медицинской и технической диагностики, геологической разведки, идентификации и управления технологическими процессами, оптимизации процесса принятия решений, обработки результатов биологического эксперимента и т. д. Алгоритмы этого класса позволяют решать некоторые задачи проблемы распознавания: выбора словаря признаков на основе оценки их информативности, описания классов на языке признаков, отнесения распознаваемого объекта к одному из классов, автоматической классификации.