Теория информации Шеннона.

Точнее количества информации, исходит из элементарного альтернативного выбора между двумя знаками (битами) 0 и 1. Такой выбор соответствует приёму сообщения, состоящего из одного двоичного знака. Количество информации, содержащееся в таком сообщении, принимается за единицу и называется битом.

Если выбор из множества п знаков, где  то это можно сделать посредством конечного числа следующих друг за другом альтернативных выборов: данное множество из п знаков разбивается на два (непустых) подмножества, каждое из которых точно так же разбивается дальше, пока мы не получим одноэлементные подмножества.

то это можно сделать посредством конечного числа следующих друг за другом альтернативных выборов: данное множество из п знаков разбивается на два (непустых) подмножества, каждое из которых точно так же разбивается дальше, пока мы не получим одноэлементные подмножества.

Часто встречающиеся знаки содержат малое, а редкие знаки — большое количество информации. Надо разбивать исходное множество знаков на равновероятные подмножества, (суммы вероятностей для знаков одного и для знаков другого подмножества были близки друг к другу). Пусть, заданные вероятности позволяют получить точное равенство. Тогда если i-й знак выделяется после ki альтернативных выборов, то вероятность его появления рi =  . Для выбора знака, который встречается с вероятностью рi требуется ki =

. Для выбора знака, который встречается с вероятностью рi требуется ki =  (1/рi) альтернативных выборов. Количество информации, содержащейся в знаке, задаваемое частотой появления такого знака

(1/рi) альтернативных выборов. Количество информации, содержащейся в знаке, задаваемое частотой появления такого знака  (бит).

(бит).

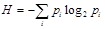

Тогда среднее количество информации, приходящейся на один произвольный знак, равно  (бит).

(бит).

; Н - количество информации на знак (энтропия источника сообщения).

; Н - количество информации на знак (энтропия источника сообщения).

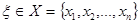

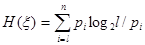

Количество информации  при наблюдении случайной величины

при наблюдении случайной величины

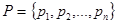

с распределением вероятностей

с распределением вероятностей  задается формулой Шеннона:

задается формулой Шеннона:

Единицей измерения количества информации является бит, который представляет собой количество информации, получаемое при наблюдении случайной величины, имеющей два равновероятных значения.