рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Науковедение

- /

- МЕТОДИЧЕСКИЕ УКАЗАНИЯ К КУРСОВОЙ РАБОТЕ ПО ДИСЦИПЛИНЕ СИСТЕМЫ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА

Реферат Курсовая Конспект

МЕТОДИЧЕСКИЕ УКАЗАНИЯ К КУРСОВОЙ РАБОТЕ ПО ДИСЦИПЛИНЕ СИСТЕМЫ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА

МЕТОДИЧЕСКИЕ УКАЗАНИЯ К КУРСОВОЙ РАБОТЕ ПО ДИСЦИПЛИНЕ СИСТЕМЫ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА - раздел Науковедение, Министерство Образования И Науки Украины Одесский Национальный Полит...

Министерство образования и науки Украины

ОДЕССКИЙ НАЦИОНАЛЬНЫЙ ПОЛИТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ

МЕТОДИЧЕСКИЕ УКАЗАНИЯ

К КУРСОВОЙ РАБОТЕ

ПО ДИСЦИПЛИНЕ

“ СИСТЕМЫ

ИСКУССТВЕННОГО ИНТЕЛЛЕКТА”

для студентов института радиоэлектроники и телекоммуникаций

Уровень подготовки – специалист, магистр

Специальность - ИНФОРМАЦИОННЫЕ ТЕХНОЛОГИИ ПРОЕКТИРОВАНИЯ

Утверждено на заседании

кафедры електронных средств

и информационно-компьютерных

технологий

Протокол № від 2011

Одесса ОНПУ 2011

Методические указания к курсовому проектированию по дисциплине "Системы искусственного интеллекта" для студентов института радио-электроники и телекоммуникаций.Цель курсового проектирования

Целью курсовой работы является закрепление студентами теоретических знаний, полученных в процессе изучения дисциплины, а также приобретение практических навыков в проектировании искусственных нейронных сетей – однослойных нейронных сетей с прямыми связями, двухслойных нейронных сетей, а также линейных ассоциативных сетей.

Задание на курсовую работу

В процессе выполнения курсовой работы студент должен выполнить задание, охватывающее следующие разделы изучаемой дисциплины:

- Однослойные нейронные сети.

- Сети встречного распространения.

- Линейная ассоциативная память.

- Сети Хэмминга

Задание на курсовую работу формулируется следующим образом:

Выполнить проектирование

- однослойной искусственной нейронной сети с прямыми связями

- сети встречного распространения

- линейной ассоциативной памяти

- сети Хэмминга

График выполнения работы

- разработку структуры проектируемой сети; - выбор методов расчета элементов проектируемой сети; - расчет элементов проектируемой сети;Рекомендации по выполнению КР

Начинать работу следует с детального и внимательного изучения задания на КР и его анализа. После анализа задания студенту необходимо изучить настоящие методические указания и необходимые разделы рекомендуемых литературных источников, приведенных в указаниях.

Содержание пояснительной записки

Пояснительная записка к курсовой работе должна содержать

- задание на проектирование; - реферат; - содержание;Теоретическая часть

6.1 Понятие искусственной нейронной сети. Общие сведения

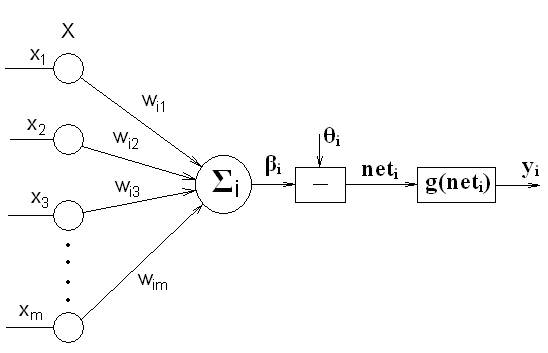

Искусственная нейронная сеть представляет собой совокупность взаимосвя-занных искусственных нейронных элементов, каждый из которых может быть представлен структурной схемой (рис. 1):

Рис. 1

где Х – входной векторный сигнал ИНС;

хj – j – тая компонента входного векторного сигнала ИНС;

wij – вес связи i – того нейронного элемента с j – тым входом ИНС;

Σi – сумматор i - того нейронного элемента;

βi – результирующий сигнал на выходе сумматора i - того нейронного элемента;

θi – некоторый пороговый уровень.

В соответствии с этим рисунком модель формального нейрона может быть описана функцией вида

, (1)

, (1)

где yi(t+1) – реакция i-того нейрона на входное воздействие;

g(•) – функция преобразования;

ui – сетевая функция, определяемая в случае ее линейности выражением

, (2)

, (2)

где WiT={wi1, wi2,… wim} - транспонированный вектор-столбец весовых коэффициентов

Структура нейронной сети отображается направленным графом, в котором вершины - это НЭ, а дуги представляют связи между НЭ. Дуга, направленная от НЭ с номером j к НЭ элементу с номером i, характеризуется весом wij.

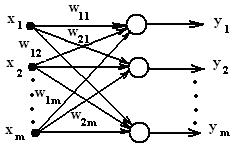

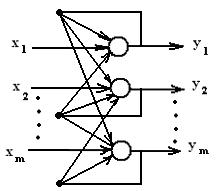

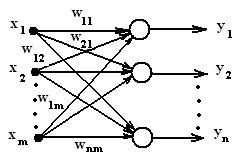

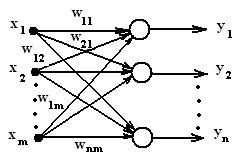

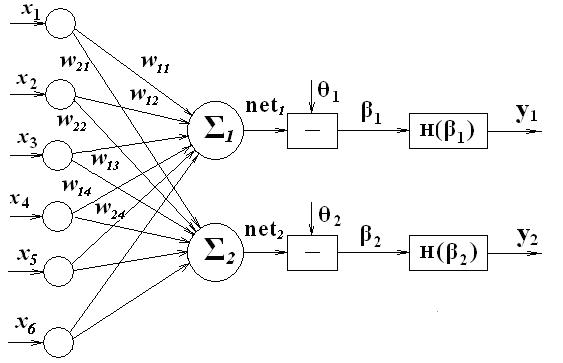

Выделяют следующие основные разновидности структур ИНС: однослойные ИНС с прямыми связями (рис. 2):

Рис. 2

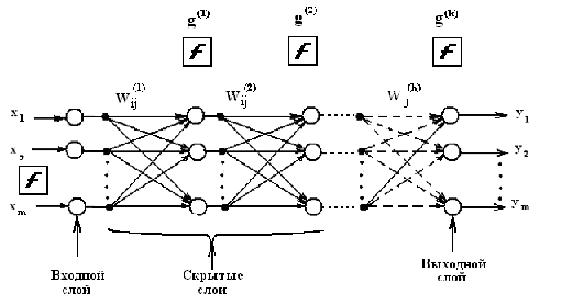

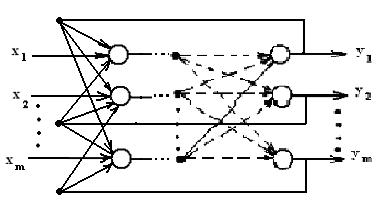

многослойные ИНС с прямыми связями (рис. 3):

Рис. 3

однослойные рекуррентные ИНС (ИНС с обратными связями) (рис. 4):

Рис.4

многослойные рекуррентные ИНС (рис. 5):

Рис. 5

Для решения простых задач распознавания как правило используют однослойные или многослойные сети с прямыми связями.

Связи входов сети с соответствующими НЭ могут быть заданы матрицей весов связей W

, (3)

, (3)

где  - векторы весов НЭ с номерами 1,2, ... n. Если между некоторым входом и НЭ нет связи, то соответствующий вес равен нулю.

- векторы весов НЭ с номерами 1,2, ... n. Если между некоторым входом и НЭ нет связи, то соответствующий вес равен нулю.

В многослойной сети с прямыми связями выходы одного слоя НЭ выступают в роли входов другого слоя НЭ. Внутренние слои многослойной ИНС называют скрытыми слоями. Реакция i-го выходного НЭ многослойной ИНС вычисляется последовательным применением выражения (1). Например, если сеть является двухслойной, то

(4)

(4)

Поведение рекуррентных ИНС сложнее из-за наличия обратных связей.

Таким образом, выполнить проектирование ИНС сводится к выбору ее структуры, определению в общем случае матриц весовых коэффициентов W для каждого слоя ИНС, определению θi, а также функции преобразования.

В качестве функции преобразования в ИНС применяются следующие основные функции:

- ступенчатая функция (функция Хевисайда)

(5)

(5)

- линейная функция с насыщением

(6)

(6)

- знаковая функция

(7)

(7)

- униполярная сигмовидная функция

, (8)

, (8)

- биполярная сигмовидная функция, представляющая собой гиперболический тангенс

(9)

(9)

- гауссова функция

(10)

(10)

где σ, с - постоянные коэффициенты.

В ИНС наиболее часто используется два типа НЭ:

- НЭ с линейной сетевой функцией вида (2) и функцией преобразова-ния вида (5) или (7). Такие НЭ называются линейными пороговыми элемен-тами (ЛПЭ). Сигналы, распространяющиеся в сетях, составленных из ЛПЭ, являются бинарными и принимают значения 0 или 1, либо +1 и -1.

- НЭ с линейной сетевой функцией (2) и функцией преобразования

вида (8) или (9). Такие НЭ называются линейно-непрерывными элементами (ЛНЭ). Сигналы, распространяющие в сетях из ЛНЭ, принимают произволь-ные значения из диапазона [0,1] или [-1,1].

По своей выходной реакции на входной сигнал сети можно разделить на сети, вырабатывающие признак входного воздействия и сети, восстанав-ливающие входное воздействие или ассоциированный с входным воздейст-вием сигнал. Сети, вырабатывающие на своём выходе признак входного сигнала, как правило, имеют столько выходов, а соответственно и нейронов, сколько входных полезных сигналов может присутствовать на их входах.

Вообще говоря, для разделения множества входных образов, например, по двум классам достаточно всего одного выхода. При этом каждый логи-ческий уровень – "1" и "0" – будет обозначать отдельный класс. На двух выходах можно закодировать уже 4 класса и так далее. Однако результаты работы сети, организованной таким образом, не очень надежны. Поэтому для повышения достоверности классификации желательно ввести избыточ-ность путем выделения каждому классу одного нейрона в выходном слое.

Число выходов сетей, предназначенные для восстановления входного сигнала или ассоциированного с ним сигнала соответствует размерности выходного сигнала.

Число входов cети определяется размерностью входного вектора.

Задание 1. Проектирование однослойной искусственной нейронной сети. Общие сведения.

6.2.1.Простой персептрон. Обучение простого персептрона.

НЭ, описываемый функцией

(11)

(11)

где Н(•) - единичная ступенчатая функция Хевисайда, называется простым персептроном.

В качестве функции преобразования персептрона может использоваться также знаковая функция sgn(•). В этом случае входные и выходные сигналы персептрона будут биполярными.

Задача обучения персептрона заключается в поиске такого вектора ве-сов WT= (w1,w2,...,wm) и порогового значения θ, при которых будет обеспе-чиваться совпадение желаемой  и действительной реакции персептрона

и действительной реакции персептрона  на заданный входной вектор

на заданный входной вектор  . Если

. Если

, (12)

, (12)

то выходной сигнал НЭ в силу использования в качестве функции преобразо-вания функции Хевисайда будет равен +1. Это означает, что входной вектор  принадлежит классу, на который настроен НЭ. В ином случае входной вектор не принадлежит этому классу. При этом сетевая функция НЭ

принадлежит классу, на который настроен НЭ. В ином случае входной вектор не принадлежит этому классу. При этом сетевая функция НЭ

играет роль дискриминантной функций, позволяющей установить принад-лежность вектора  определенному классу.

определенному классу.

Идея обучения персептрона состоит в следующем. На вход персептро-на подаются последовательно входные векторы  . Одновременно с этим выходная реакция персептрона

. Одновременно с этим выходная реакция персептрона  сравнивается с желаемой реакцией

сравнивается с желаемой реакцией  . Если указанные реакции совпадают, то никаких действий не предпри-нимают. Если

. Если указанные реакции совпадают, то никаких действий не предпри-нимают. Если  ≠

≠ , то вектор весов персептрона

, то вектор весов персептрона  изменяется на величину

изменяется на величину  . Адаптация весов выполняется с помощью правила

. Адаптация весов выполняется с помощью правила

(13)

(13)

где η - коэффициент обучения, η > 0. Если обозначить ошибку обуче-ния через  , т.е.

, т.е.  =

= -

- , то правило обучения можно перепи-сать в виде

, то правило обучения можно перепи-сать в виде

(14)

(14)

Таким образом, если  =0, то вектор весов не меняется. Если

=0, то вектор весов не меняется. Если  >0, то вектор весов

>0, то вектор весов  меняется в направлении вектора

меняется в направлении вектора  .

.

Для простого персептрона в силу того, что в качестве функции преоб-разования используется функция Хевисайда, значение  может прини-мать только значения +1 (если на входе нейрона присутствует сигнал, на который “настроен” нейрон) или 0 (если сигнал на входе не соответствует сигналу настройки). Очевидно, что и желаемое значение реакции нейрона

может прини-мать только значения +1 (если на входе нейрона присутствует сигнал, на который “настроен” нейрон) или 0 (если сигнал на входе не соответствует сигналу настройки). Очевидно, что и желаемое значение реакции нейрона  будет равно +1, если на входе нейрона присутствует сигнал, на который “настроен” нейрон, и 0 в противном случае. Значение же выходной реакции нейрона будет зависеть от значения и знака аргумента функции преобразо-вания (функции Хевисайда), то есть от значения величины сетевой функции

будет равно +1, если на входе нейрона присутствует сигнал, на который “настроен” нейрон, и 0 в противном случае. Значение же выходной реакции нейрона будет зависеть от значения и знака аргумента функции преобразо-вания (функции Хевисайда), то есть от значения величины сетевой функции  . В соответствии с этим реакция нейрона на входное воздействие будет полностью определяться значением сетевой функ-цией. Поэтому в качестве желаемой реакции можно принять желаемое зна-чение сетевой функции, которое при входном сигнале, на который “настро-ен” нейрон на входной сигнал будет больше или равно 0, то есть

. В соответствии с этим реакция нейрона на входное воздействие будет полностью определяться значением сетевой функ-цией. Поэтому в качестве желаемой реакции можно принять желаемое зна-чение сетевой функции, которое при входном сигнале, на который “настро-ен” нейрон на входной сигнал будет больше или равно 0, то есть

. (15)

. (15)

Если добавить к обеим частям неравенства θ, выражение (15) преобра-зуется к виду

. (16)

. (16)

Полученное выражение показывает, что при данном подходе к опреде-лению значения желаемой реакции её значение должно быть больше θ, то есть  .

.

С учетом этого адаптация весов выполняется с помощью правила

(17)

(17)

где  - вектор изменения весов, Х(μ) – μ-тый вектор входного сигнала.

- вектор изменения весов, Х(μ) – μ-тый вектор входного сигнала.

Если обозначить  , то правило обучения можно переписать в виде

, то правило обучения можно переписать в виде

(18)

(18)

6.2.2. Однослойная ИНС. Обучение искусственной нейронной сети

Распространим правило обучения персептрона на однослойную ИНС с прямыми связями и функцией Хевисайда в качестве функции преобразова-ния. Использование такой сети целесообразно для решения задачи распозна-вания n различных входных векторов. Пусть входной вектор сигнала имеет размерность m, а размерность выходного вектора при данной постановке задачи соответствует числу распознаваемых сигналов – n (рис. 6).

Рис. 6

При этом каждый i-тый нейрон сети соответствует модели, представ-ленной на рис.1.

Так как на вход нейронной сети может поступать любой из распозна-ваемых векторных сигналов, а также и сигналы, не подлежащие распознава-нию, то для любого нейрона необходимо обеспечить такой выбор вектора весов, при котором бы на его выходе появлялся единичный сигнал при появ-лении на его входе сигнала, на который он настроен (“полезный” для данного нейрона сигнал), и нулевой сигнал при появлении на его входе сигнала не соответствующего сигналу настройки (“мешающий” для данного нейрона сигнал). Это приводит к тому, что желаемые реакции каждого из нейронов сети должны быть разными в зависимости от входного сигнала.

В связи с этим задача обучения однослойной сети заключается в поиске таких векторов весов Wi= (wi1,wi2,...,wim) и порогового значения θi, при ко-торых будет обеспечиваться совпадение желаемой  и действительной реакции персептрона

и действительной реакции персептрона  на соответствующий входной вектор

на соответствующий входной вектор  , то есть при наличии на входе сети сигнала, для которого реакция i-того нейро-на должна быть единичной, необходимо выполнение условия

, то есть при наличии на входе сети сигнала, для которого реакция i-того нейро-на должна быть единичной, необходимо выполнение условия

t´iжел пол (μ) =netiжел пол(μ) , (19)

, (19)

в противном случае

t´iжел меш (μ) =netiжел меш(μ) , (20)

, (20)

или по аналогии с предыдущим в первом случае должно выполняться соотношение

t´´iжел пол (μ) =net´iжел пол(μ) , (21)

, (21)

а во втором -

t´´iжел меш (μ) =net´iжел меш(μ) , (22)

, (22)

С учетом этого и выражения (17) пошаговая адаптация весов каждого нейрона выполняется с помощью правила

(23)

(23)

где  - ошибка обучения i-того нейрона, (24)

- ошибка обучения i-того нейрона, (24)

t´´i (μ)= t´´iжел пол (μ) при наличии на входе i-того нейрона полез-ного сигнала и

t´´i (μ)= t´´iжел меш (μ) при поступлении на вход i-того нейрона ме-шающего сигнала,

net´i(μ)=  при наличии на входе i-того нейрона полезного сигнала и

при наличии на входе i-того нейрона полезного сигнала и

net´i(μ)=  при поступлении на вход i-того ней-рона мешающего сигнала,

при поступлении на вход i-того ней-рона мешающего сигнала,

- текущие значения компонентов i-того весового вектора, по-лученные на предыдущем шаге

- текущие значения компонентов i-того весового вектора, по-лученные на предыдущем шаге

6.2.3. Проектирование однослойной искусственной нейронной сети

Ход проектирования однослойной искусственной нейронной сети про-изводится в соответствии со следующими этапами:

1. Проводится анализ задания на проектирование. Выполняется коди-рование (при необходимости) входной информации. Определяется размер-ность входного вектора и необходимое для решения задачи распознавания число нейронов.

2. Разрабатывается структурная схема нейронной сети. Осуществляется закрепление каждого из нейронов за распознаваемым образом.

3. Выбирается правило расчета весовых коэффициентов.

4. Выбирается некоторый i-тый нейрон и образ (сигнал), для распозна-вания которого предназначается этот нейронный элемент. Определяются па-раметры, необходимые для расчета вектора весовых коэффициентов:

- коэффициент обучения выбранного нейрона. При этом необходи-мо учитывать, что большое значение коэффициента обучения может привес-ти к постоянной неустойчивости процесса обучения, а малые значения при-водят к медленной сходимости решения. Поэтому в качестве h обычно вы-бирается число меньше 1, но не очень маленькое, например, 0,6, и оно может постепенно уменьшаться в процессе обучения.

- пороговое значение θi. Для определенности рекомендуется выби-рать значение, равное числу единиц в сигнале, распознаваемом этим нейро-ном.

- величины t´´iжел пол (μ) и t´´iжел меш (μ) как θi +∆ в первом случае и θi -∆ во втором случае. Величину ∆ рекомендуется выбирать мень-ше величины θi, равной, например, 1.

- так как процедура является итерационной и обеспечивает посте-пенное пошаговое приближение к желаемому результату (определению век-тора весовых коэффициентов) для сокращения времени обучения задаются максимально допустимые значения ошибок обучения δmax пол и δmax меш , которые должны быть значительно меньше величины ∆.

5. Осуществляют расчет вектора весовых коэффициентов выбранного нейронного элемента.

Первая итерация

5.2. На вход сети подается сигнал, характеризующий образ, для распоз-навания которого служит выбранный нейронный элемент. 5.3. С учетом заданного начального значения весового вектора для этого сигнала… net´i(μ)= ,Вторая итерация

5.12. Выполняются пункты 5.2 – 5.11. Если по результатам второй ите-рации не достигается выполнения условия непревышения предельно допус-тимых… 6. Выбирается следующий нейронный элемент и сигнал, на который этот элемент… 7. Выполняются п.п. 4 – 12 для обучения выбранного нейронного элемента.Максимально допустимые ошибки обучения δmax пол и δmax меш примем равными 0,1.

5.1. Зададим следующие начальные значения компонент вектора весо-вых коэффициентов: w11=0,3; w12=0,6; w13=0,5; w14=0,8. 5.2. На вход сети подаем первый сигнал, код которого равен 1100.Net´1(1)=0,3•1+0,6•1+0,5•0+0,8•0=0,9

где = t´´1жел пол (1)=2,5. С учетом этого =2,5-0,9=1,6.Net´1(2)=1,26•1+1,56•0+0,5•1+0,8•0=1,76

5.8. Определяем ошибку обучения в соответствии с выражением где = t´´1жел меш (2) = 1,5.Net´1(3)=1,104•1+1,56•0+0,344•0+0,8•1=1,904

5.12. Определяем ошибку обучения в соответствии с выражением где = t´´1жел меш (2) = 1,5.Net´1(1)=0,862•1+1,56•1+0,344•0+0,558•0=2,422

где = t´´1жел пол (1)=2,5. С учетом этого =2,5-2,422=0,078.Net´1(2)=0,862•1+1,56•0+0,344•1+0,558•0=1,206

5.20. Определяем ошибку обучения в соответствии с выражением где = t´´1жел меш (2) = 1,5.Net´1(3)=1,038•1+1,56•0+0,52•0+0,558•1=1,596

5.24. Определяем ошибку обучения в соответствии с выражением где = t´´1жел меш (2) = 1,5.Задание 2. Проектирование сети встречного распространения.

Общие сведения

Возможности сети встречного распространения превосходят возмож-ности однослойных сетей. Во встречном распространении объединены два известных алгоритма: самоорганизующаяся карта Кохонена и звезда Грос-сберга. Их объединение ведет к свойствам, которых нет ни у одного из них в отдельности.

В процессе обучения входные векторы ассоциируются с соответствую-щими выходными векторами. Эти векторы могут быть двоичными, состоя-щими из нулей и единиц, или непрерывными. Когда сеть обучена, приложе-ние входного вектора приводит к требуемому выходному вектору. Обоб-щающая способность сети позволяет получать правильный выход даже при приложении входного вектора, который является неполным или слегка не-верным. Это позволяет использовать данную сеть для распознавания образов, восстановления образов и усиления сигналов.

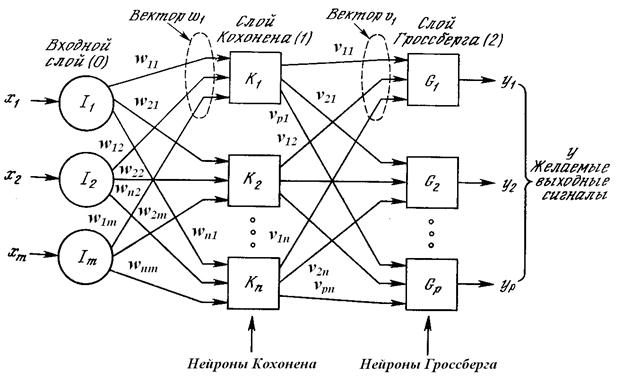

На рис. 8 показана упрощенная версия прямого действия сети встречного распространения.

Рис. 8. Сеть с встречным распространением

Нейроны слоя 0 (показанные кружками) служат лишь точками разветв-ления и не выполняют вычислений. Каждый нейрон слоя 0 соединен с каж-дым нейроном слоя 1 (называемого слоем Кохонена) отдельным весом wmn. Эти веса в целом рассматриваются как матрица весов W. Аналогично, каж-дый нейрон в слое Кохонена (слое 1) соединен с каждым нейроном в слое Гроссберга (слое 2) весом vnp. Эти веса образуют матрицу весов V.

Как и многие другие сети, встречное распространение функционирует в двух режимах: в нормальном режиме, при котором принимается входной вектор Х и выдается выходной вектор Y, и в режиме обучения, при котором подается входной вектор и веса корректируются, чтобы дать требуемый выходной вектор.

НОРМАЛЬНОЕ ФУНКЦИОНИРОВАНИЕ

Слои Кохоненна

Каждый нейрон слоя Кохонена соответствует структурной схеме, при-веденной на рис.1 при выборе в качестве функции преобразования функции Хевисайда. … Ассоциированное с каждым нейроном Кохонена множество весов соеди-няет его с… (25)Слой Гроссберга

, (27) Y = KV, где Y – выходной вектор слоя Гроссберга, К – выходной вектор слоя Кохоне-на, V – матрица весов слоя Гроссберга.ОБУЧЕНИЕ СЛОЯ КОХОНЕНА

Обучение Кохонена является самообучением, протекающим без учи-теля. Поэтому трудно (и не нужно) предсказывать, какой именно нейрон Кохонена будет…Предварительная обработка входных векторов

(28) Это превращает входной вектор в единичный вектор с тем же самым на-правлением,… При обучении слоя Кохонена на вход подается входной вектор и вычис-ляются его скалярные произведения с векторами…Выбор начальных значений весовых векторов

Наиболее желательное решение состоит в том, чтобы распределять весовые векторы в соответствии с плотностью входных векторов, которые должны быть… Одно из решений, известное под названием метода выпуклой комбинации (convex… , (31)ОБУЧЕНИЕ СЛОЯ ГРОССБЕРГА

(33) где kl – выход l-го нейрона Кохонена (только для одного нейрона Кохонена он… Первоначально b берется равным ~0,1 и затем постепенно уменьшается в процессе обучения.При проектировании сети данного типа необходимо выполнить две итерации расчета коэффициентов

1. Проводится анализ задания на проектирование. Выполняется коди-рование (при необходимости) входной информации. Определяется размер-ность входного… 2. Разрабатывается структурная схема нейронной сети. 3. Выбираются начальные значения составляющих вектора весовых коэффициентов слоя Кохонена.Х12 =000110 х22 =101000

Х13 =000011 х23=011000

Y1=1001 y2 =0110

1. В соответствии с исходными данными размерность входного вектора равна 6, а выходного – 4.

2. В соответствии с п.1 сеть должна иметь 6 входов и 4 выхода. Так как распознается 2 группы сигналов, то слой Кохонена должен состоять из двух нейронов. Так как размерность выходного сигнала равна 4, то слой Грос-сберга должен состоять из 4 нейронов. Структурная схема сети приведена на рис. 9.

Рис. 9

3. Начальные значения весовых коэффициентов слоя Кохонена выбираем равными

W1: w11=0,2; w12=0,5; w13=0,4; w14=0,2; w15=0,7; w16= 0,3

W2: w21=0,5; w22 =0,4; w23 =0,2; w24 = 0,3; w25 =0,8; w26=0,6

4. Определяются значение сетевой функции каждого нейрона слоя Кохонена на один из сигналов первой из распознаваемых групп в соответствии с выра-жением:

В качестве такого сигнала выбираем первый сигнал первой группы. Для него

net1=0,2*0+0,5*0+0,4*0+0,2*1+0,7*1+0,3*1=1,2

net2=0,5*0+0,4*0+0,2*0+0,3*1+0,8*1+0,6*1=1,7

5. Выбирается нейрон, значение сетевой функции которого на выбранный сигнал оказывается большей. В данном случае наибольшее значение сетевой функции получилось у второго нейрона слоя Кохонена. Поэтому он выбира-ется в качестве нейрона, настраиваемого на первую группу сигналов.

6. Осуществляется расчет вектора весовых коэффициентов для этого нейрона для выбранной группы входных векторов в соответствии с выражением (30):

,

,

где  - новое значение вектора весовых коэффициентов, определяемое на текущем шаге,

- новое значение вектора весовых коэффициентов, определяемое на текущем шаге,  - старое значение вектора весовых коэффициентов, опре-деленное на предыдущем шаге, Х – вектор входного сигнала, для которого проводится коррекция весовых коэффициентов i – того нейрона.

- старое значение вектора весовых коэффициентов, опре-деленное на предыдущем шаге, Х – вектор входного сигнала, для которого проводится коррекция весовых коэффициентов i – того нейрона.

Для расчета вектора весовых коэффициентов используем две итерации.

6.1. Первая итерация.

Выбирается значение коэффициента a ,равное 0,7.

С учетом этого при корректировке по первому сигналу получаем

При корректировке по второму сигналу

Для третьего сигнала первой группы

6.2. Вторая итерация.

Выбирается значение коэффициента a ,равное 0,4.

С учетом этого при корректировке по первому сигналу получаем

При корректировке по второму сигналу

Для третьего сигнала первой группы

7. Вычисляем значения сетевой функции:

для первой группы сигналов:

net11=0*0,003 + 0*0,002+0*0.001+1*0,444+1*0,999+1*0,7=2,143

net12=0*0,003 + 0*0,002+0*0.001+1*0,444+1*0,999+0*0,7=1,443

net13=0*0,003 + 0*0,002+0*0.001+0*0,444+1*0,999+1*0,7=1,69

для второй группы сигналов

net21=1*0,003 + 1*0,002+1*0.001+0*0,444+0*0,999+0*0,7=0,006

net22=1*0,003 + 0*0,002+1*0.001+0*0,444+0*0,999+0*0,7=0,005

net23=0*0,003 + 1*0,002+1*0.001+0*0,444+0*0,999+0*0,7=0,003

8. Определяем значение пороговой величины из условия:

Этому условию удовлетворяет значение θ =1,0.

9. Аналогично осуществляется обучение первого нейрона слоя Кохо-нена для распознавания второй группы сигналов.

10. Осуществляется проверка правильности реакции слоя Кохонена на группы входных сигналов.

11. После обучения всех нейронов слоя Кохонена осуществляется обу-чение слоя Гроссберга, на выходе которого должны формироваться сигналы, ассоциированные с группами входных сигналов.

Формирование весов слоя Гроссберга осуществляется в соответствии с выражением (33)

де kl – выход l-го нейрона Кохонена (только для одного нейрона Кохонена он отличен от нуля); уj – j-ая компонента вектора желаемых выходов.

Так как выходная последовательность представляет собой бинарный сигнал, то в значения весовых коэффициентов принимаются равными 1 для тех составляющих ассоциированных сигналов, которые равны единице. То есть для первого выхода нейрона Кохонена, связанного со второй группой входных сигналов и ассоциированным с ним сигналом, значения весовых коэффициентов связей выхода этого нейрона с нейронами слоя Гроссберга определятся как

V11=0; v21=1; v31=1; v41=0.

Для второго нейрона слоя Кохонена, связанного со первой группой входных сигналов, весовые коэффициенты примут значения:

V12=1; v22=0; v32=0; v42=1.

V1T = (v11, v12) = (0, 1); V2T = (v21, v22) = (1, 0); V3T = (v31, v32) = (1, 0); V4T = (v41, v42) = (0, 1). Так как на выходе сумматоров нейронов слоя Гроссберга могут быть только 1 или 0, то в качестве пороговых значений…Пример.

Выполнить проектирование линейной ассоциативной памяти для входных сигналов ХT (1)={0,0,1,0} XT (2)={1,0,1,0} и ассоциированных с ними выходных сигналов YT (1)={0,1,0} и YT(2)={0,1,1}. Выполнить про-верку правильности функционирования памяти для указанных пар сигналов и определить реакцию сети на посторонний входной сигнал XT(п)={0,1,1,0}.

1. В результате анализа задания установлено, что размерность входного вектора равна 4, а выходного – 3. Так как размерность выходного сигнала равна 3, то число нейронов ассоциативной памяти равно 3.

2. Структурная схема ассоциативной памяти в соответствии с данными пункта 1 представлена на рис. 11.

Рис. 11

3. В соответствии с выражением (36) определяются весовые коэффици-енты

.

.

Для удобства распишем с указанием конкретных значений индексов значения xj(μ) и yi(μ):

- для первой пары x и y (μ = 1):

x1(1) = 0; x2(1) = 0; x3(1) = 1; x4(1) = 0;

y1(1) = 0; y2(1) = 1; y3(1)=0;

- для второй пары (μ=2):

x1(2) = 1; x2(2) = 0; x3(2) = 1; x4(2) = 0;

Y1(2) = 0; y2(2) = 1; y3(2)=1.

Тогда в соответствии с (36)

В соответствии с этим матрица весов будет равна

,

,

то есть

4. В соответствии с выражением (37) определяются пороговые значе-ния  .

.

5. Проверка правильности работы сети.

5.1. На вход сети подается первый сигнальный вектор

ХT(1)={0,0,1,0}.

5.1.1. Вычисляются значения сетевой функции на данный входной сигнал на выходах всех сумматоров:

(net1=-2, net2=2, net3=0).

5.1.2. Определяются результаты вычитания из значений сетевых функций пороговых сигналов

β1=net1-θ1=-2-1=-3

β2=net2-θ2=2-(-1)=3

β3=net3-θ3=0-1=-1

В векторной форме .

.

5.1.3. Определяются значения реакций функций преобразования Хевисайда на входные воздействия (вектор выходного сигнала)

,

,

то есть на выходе линейной ассоциативной памяти при подаче на вход первого сигнала сформировался ассоциированный с ним первый выходной вектор.

5.2. На вход сети подается второй сигнальный вектор

XT(2)={1,0,1,0}.

5.2.1. Вычисляются значения сетевой функции на данный входной сигнал на выходах всех сумматоров:

(net1=-2, net2=2, net3=2)

5.2.2. Определяются результаты вычитания из значений сетевых функций пороговых сигналов

β1=net1-θ1=-2-1=-3

β2=net2-θ2=2-(-1)=3

β3=net3-θ3=2-1=1

В векторной форме  .

.

5.2.3. Определяются значения реакций функций преобразования Хевисайда на входное воздействие (вектор выходного сигнала)

,

,

то есть на выходе линейной ассоциативной памяти при подаче на вход второго сигнала сформировался ассоциированный с ним второй выходной вектор.

5.3. Проверяется реакция сети на посторонний входной сигнал

XT (п)={0,1,1,0}.

5.3.1. Вычисляются значения сетевой функции на данный входной сигнал на выходах всех сумматоров:

(net1=0, net2=0, net3=0)

5.3.2. Определяются результаты вычитания из значений сетевых функ-ций пороговых сигналов

β1=net1-θ1=0-1=-1

β2=net2-θ2=0-(-1)=1

β3=net3-θ3=0-1=-1

В векторной форме  .

.

5.2.3. Определяются значения реакций функций преобразования Хеви-сайда на входное воздействие (вектор выходного сигнала)

,

,

то есть на выходе линейной ассоциативной памяти при подаче на вход постороннего сигнала сигнала сформировался выходной сигнал, не совпада-ющий ни с одним из заданных выходных ассоциированных сигналов.

6.5. Задание 4. Сеть Хэмминга

Лучшие результаты восстановления можно получить при использо- вании ИНС Хэмминга, входные векторы которой являются бинарными. Структура сети Хэмминга будет аналогична однослойной нейронной сети, приведенной на рис. 12.

Рис. 12

При подаче на вход такой сети искаженного вектора признаков  восстанавливается тот сохраненный вектор-прототип

восстанавливается тот сохраненный вектор-прототип  , кото-рый ближе всего к вектору

, кото-рый ближе всего к вектору в смысле расстояния Хэмминга. (Расстояние Хэмминга HD между двумя бинарными векторами равно количеству несовпадающих битов векторов. Например, расстояние Хэмминга между бинарными векторами

в смысле расстояния Хэмминга. (Расстояние Хэмминга HD между двумя бинарными векторами равно количеству несовпадающих битов векторов. Например, расстояние Хэмминга между бинарными векторами  и

и  равно 1.) Под вектором-прототипом в данном случае понимается неискаженный вектор признаков.

равно 1.) Под вектором-прототипом в данном случае понимается неискаженный вектор признаков.

В отличие от ЛАП, строки матрицы весов связей сети Хэмминга предс-тавляют запомненные векторы-прототипы:

, (39)

, (39)

где  ,

,  , … ,

, … ,  - бинарные значения компонент k-го вектора-прототипа

- бинарные значения компонент k-го вектора-прототипа  . При подаче на вход сети Хэмминга бинарного вектора признаков

. При подаче на вход сети Хэмминга бинарного вектора признаков  вычисляются сетевые функции

вычисляются сетевые функции

. (40)

. (40)

Однако при таком подходе в случае нулевых значений составляющих хотя бы одного из векторов значение сетевой функции будет равно нулю. Этот недостаток у сетей Хэмминга отсутствует, если значения векторов признаков будут представляться не униполярными, а биполярными бинарными последовательностями (то компоненты векторов признаков принимают значения не 0 и 1, а 1 и -1). В этом случае при таком же принципе формирования матрицы весов значение сетевой функции будет принимать нулевое значение только в том случае, когда входной вектор признаков и вектор-прототип полностью не совпадают. В случае же идентичности этих векторов значение сетевой функции принимает значение, равное размерности указанных векторов.

В сети Хэмминга имеется второй слой нейронов, который обеспечивает выбор нейрона-победителя среди НЭ первого слоя. Победителем считается НЭ первого слоя с максимальным значением сетевой функции net (μ) (минимальным значением  . Это обеспечивает формирование на выходе сети индекса вектора-прототипа, ближайшего к вектору входных признаков. Таким образом, сеть Хэмминга в общем случае формирует признак наличия того или иного образа на одном из своих выходов. Если положить, что только на выходе одного нейрона должен появиться сигнал-признак распознаваемого образа, то число нейронов сети Хэмминга должно соответствовать числу этих образов.

. Это обеспечивает формирование на выходе сети индекса вектора-прототипа, ближайшего к вектору входных признаков. Таким образом, сеть Хэмминга в общем случае формирует признак наличия того или иного образа на одном из своих выходов. Если положить, что только на выходе одного нейрона должен появиться сигнал-признак распознаваемого образа, то число нейронов сети Хэмминга должно соответствовать числу этих образов.

Операцию поиска нейрона, имеющего максимальное значение сетевой функции можно по аналогии со структурой сети встречного распространения заменить сравнением сетевой функции с некоторым порогом, значение кото-рого выбирается в некоторой окрестности относительно максимального зна-чения сетевой функции и определяемым допустимым отклонением входного вектора признаков от векторов прототипов и дальнейшем использовании в качестве функции преобразования функции Хевисайда. В этом случае на вы-ходе только одного нейрона появится единичный сигнал, являющийся при-знаком соответствующего вектора-прототипа, наиболее близко расположен-ного ко входному вектору.

Зная индекс вектора прототипа, можно на выходе сети восстановить либо сам вектор-прототип , либо ассоциированный с ним вектор

, либо ассоциированный с ним вектор  . Таким образом, сеть Хэмминга может быть использована при построении как автоассоциативной, так гетероассоциативной памяти.

. Таким образом, сеть Хэмминга может быть использована при построении как автоассоциативной, так гетероассоциативной памяти.

6.4.2. Проектирование сети Хэмминга

Ход проектирования сети Хэмминга производится в соответствии со следующими этапами:

1. Проводится анализ задания на проектирование. Выполняется коди-рование или перекодирование (при необходимости) входной информации (представление составляющих входного вектора признаков и векторов-прототипов биполярной бинарной последовательностью). Определяется размерность входного вектора и выходного вектора. Определяется число нейронов сети.

2. Разрабатывается структурная схема сети Хэмминга.

3. В соответствии с выражением (39) определяется матрица весов W.

4. Определяются пороговые значения  .

.

5. Осуществляется проверка правильности работы сети.

Пример. Выполнить проектирование сети Хэмминга, если в качестве векторов-прототипов используются следующие вектора

ХT(1)={0,0,1,0,1,1} XT(2)={1,0,1,0,0,0}. Сеть должна вырабатывать при-знак наличия на входе сети одного из указанных сигналов или близких к ним сигналов, в качестве которых приняты векторы ХT(11)={0,1,1,0,1,1},

XT (22)={1,0,1,1,0,0}. Проверить работоспособность сети для указанных групп сигналов, а также для постороннего сигнала типа ХT(П)={1,1,1,0,1,1}.

1. В результате анализа задания установлено, что размерность входно-го вектора равна 6, а выходного – 2 – так как сеть должна вырабатывать при-знак присутствия на входе только сигнала одной из групп. Так как размер-ность выходного сигнала равна 2, то число нейронов сети Хэмминга выби-рается равным 2.

Так как векторы-прототипы и близкие к ним сигналы заданы в уни-полярной бинарной форме, выполним их перекодировку в биполярные би-нарные последовательности. В соответствии с этим вектора-прототипы и близкие к ним , а также посторонний сигнал преобразуются к виду:

ХT(1)={-1,-1,1,-1,1,1}, XT(2)={1,-1,1,-1,-1,-1}. Сеть должна вырабатывать признак наличия на входе сети одного из указанных сигналов или близких к ним сигналов, в качестве которых приняты векторы ХT(11)={-1,1,1,-1,1,1},

XT (22)={1,-1,1,1,-1,-1}. Проверить работоспособность сети для указанных групп сигналов, а также для постороннего сигнала типа ХT(П)={1,1,1,-1,1,1}.

2. В соответствии с результатами пункта 1 структурная схема сети Хэмминга представлена на рис. 13.

3. В соответствии с выражением (39) определяется матрица весов W.

4. Определяются пороговые значения  .

.

Для определения пороговых значений вычислим расстояние Хэмминга между векторами-прототипами и близким к ним сигналами, то есть между

ХT(1)={-1,-1,1,-1,1,1} и ХT(11)={-1,1,1,-1,1,1}; XT(2)={1,-1,1,-1,-1,-1} и XT(22)={1,-1,1,1,-1,-1}.

HD[X(1),X(11)] = (0+1+0+0+0+0)=1

HD[X(2),X(22)] = (0+0+0+1+0+0)=1

Так как расстояния Хэмминга между соответствующими парами векторов равны 1, то значения порогов могут быть меньше на величину, равную 2HD=2 относительно максимальных значений сетевой функции, полученных при наличии на входе сети векторов-прототипов:

,

,

то есть net1(1) =6, net2(1)=0

то есть net1(2) =0, net2(21)=6.

Так как максимальные значения сетевых функций, соответствующие векторам прототипам на выходах согласованных с ними нейронов, равны 6, то значения пороговых значений выбираются равными θ1=θ2=4.

5. Проверка правильности работы сети.

5.1. На вход сети подается первый вектор-прототип. Сетевая функция на выходах нейронов соответственно равна net1=6, net2=0

На выходе вычитателей значения βсоответственно равны

β1(1) = 6-4 = 2, β2(1) = 0 – 4 = -4.

На выходе преобразователей Хевисайда y1=H(β1(1))=1, y2=H(β2(1))=0.

Таким образом на выходе первого нейрона вырабатывается признак присутствия на входе первого вектора-прототипа.

5.2. На вход сети подается вектор признаков, близкий первому вектору-прототипу. Сетевая функция на выходах нейронов соответственно равна

,

,

то есть net1=4, net2=-2

На выходе вычитателей значения βсоответственно равны

β1(11) = 4-4 = 0, β2(11) = -2 – 4 = -6.

На выходе преобразователей Хевисайда y1=H(β1(11))=1, y2=H(β2(11))=0.

Таким образом на выходе первого нейрона вырабатывается признак присутствия на входе вектора, близкого первому вектору-прототипу.

5.3. На вход сети подается второй вектор-прототип. Сетевая функция на выходах нейронов соответственно равна net1=0, net2=6

На выходе вычитателей значения βсоответственно равны

β1(2) =0-4 =-4, β2(2) =6 – 4 = 2.

На выходе преобразователей Хевисайда y1=H(β1(2))=0, y2=H(β2(2))=1.

Таким образом на выходе второго нейрона вырабатывается признак присутствия на входе второго вектора-прототипа.

5.4. На вход сети подается вектор признаков, близкий второму вектору-прототипу. Сетевая функция на выходах нейронов соответственно равна

,

,

то есть net1(22)=-2, net2(22)=4

На выходе вычитателей значения βсоответственно равны

β1(22) = -2-4 = -6, β2(22) = 4 – 4 = 0.

На выходе преобразователей Хевисайда y1=H(β1(22))=0, y2=H(β2(22))=1.

Таким образом на выходе второго нейрона вырабатывается признак присутствия на входе вектора, близкого второму вектору-прототипу.

5.5. На вход сети подается посторонний вектор признаков

ХT (П)={1,1,1,-1,1,1}. Сетевая функция на выходах нейронов для этого сигнала равна

,

,

то есть net1(П)=2, net2(П)=0

На выходе вычитателей значения βсоответственно равны

β1(П) = 2-4 = -2, β2(П) = 0 – 4 =-4.

На выходе преобразователей Хевисайда y1=H(β1(П))=0, y2=H(β2(П))=0.

Таким образом сеть Хэмминга не выработала ни на одном из своих выходах признака присутствия сигналов прототипов или близких к ним.

Задание 1

Задание № 2. Разработка сети встречного распространения

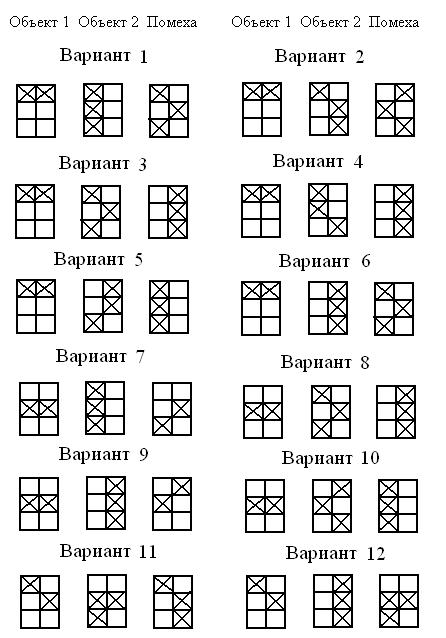

Вариант 1 Вариант 2

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

000011 101000 110000 000110

000010 111000 101000 000011

000011 110000 011000 000101

Выходные сигналы Выходные сигналы

1001 1101 1010 0101

Вариант 3 Вариант 4

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

000110 011000 010010 001100

000110 111000 110010 000110

000011 011000 100001 001000

Выходные сигналы Выходные сигналы

10011 11010 1011 1111

Вариант 5 Вариант 6

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

00111 01001 010010 000010

00011 11000 110000 000110

00101 10100 101001 001010

Выходные сигналы Выходные сигналы

10011 11010 1011 1111

Вариант 7 Вариант 8

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

00111 01001 10010 00111

10011 11000 10011 00010

00101 01100 01001 00101

Выходные сигналы Выходные сигналы

10111 10010 10101 11001

Вариант 9 Вариант 10

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

00111 01001 10010 00111

10011 11100 10011 00100

00101 01100 11001 00101

Выходные сигналы Выходные сигналы

10111 10010 10101 11001

Вариант 11 Вариант 12

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

0010011 1101001 10010 00110

0001111 0110000 10011 01001

0001011 1100100 01001 00101

Выходные сигналы Выходные сигналы

10101 10110 10111 11101

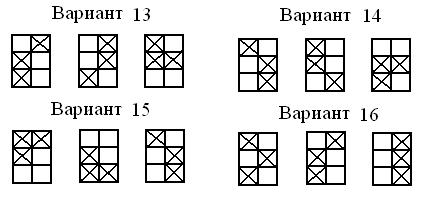

Вариант 13 Вариант 14

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

1110000 0001011 100100 000011

1010010 0000101 100110 000101

0111001 1000101 010010 001001

Выходные сигналы Выходные сигналы

10111 11011 01010 01110

Вариант 15 Вариант 16

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

1110000 0001011 100101 010000

1010010 0100101 100111 101000

0111001 1000101 010011 011000

Выходные сигналы Выходные сигналы

101111 111011 010101 001101

Вариант 17 Вариант 18

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

1100100 0011010 0001011 1100001

1110010 0001011 0001111 1001000

0110000 0001110 0100111 1110000

Выходные сигналы Выходные сигналы

101001 010001 011101 000101

Вариант 19 Вариант 20

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

1111010 0001011 1000011 1011000

1110000 0100011 0000111 0111000

0111000 0100110 0100011 1110010

Выходные сигналы Выходные сигналы

111011 010111 010001 110110

Вариант 21 Вариант 22

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

0011010 1100001 0110011 1001001

0011010 1000101 1010011 0101000

0111000 1000011 0101011 1001010

Выходные сигналы Выходные сигналы

100100 111101 010111 111111

Вариант 23 Вариант 24

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

1100000 0000101 0100011 1001010

1010100 0001111 0110001 0101110

1111000 0001011 0101001 1000110

Выходные сигналы Выходные сигналы

100111 100101 010011 001101

Вариант 25 Вариант 26

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

101110 010101 0111011 1001110

100110 011000 0110001 0101010

100110 101001 1110000 1001110

Выходные сигналы Выходные сигналы

101001 101100 010111 011101

Вариант 27 Вариант 28

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

0111100 1100011 1100011 0011110

0011100 1000011 0110011 0101110

0001110 0100010 1101010 0010110

Выходные сигналы Выходные сигналы

100111 100101 111011 100101

Вариант 29 Вариант 30

Входные сигналы Входные сигналы

1 группа 2 группа 1 группа 2 группа

01110 10001 110011 001110

10111 00011 011011 010110

10110 01001 110010 001010

Выходные сигналы Выходные сигналы

100101 100001 110011 100011

Задание №3 – разработка линейной ассоциативной памяти

Вариант 1 Вариант 2

Сигналы-прототипы Сигналы-прототипы

Х1 = 1 0 1 1 0 Х2 = 1 1 0 0 1 Х1 = 0 1 1 1 0 Х2 = 0 1 0 0 1

Х3 = 0 0 1 1 0 Х3 = 1 0 1 1 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 110 Y2=010 Y3=101 Y1 = 100 Y2=011 Y3=111

Посторонний сигнал Z = 11010 Посторонний сигнал Z = 11110

Вариант 3 Вариант 4

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 0 1 1 1 Х2 = 0 0 0 0 1 Х1 = 1 1 1 1 1 Х2 = 0 0 0 0 1

Х3 = 1 1 1 1 0 Х3 = 0 1 1 1 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 001 Y2=111 Y3=010 Y1 = 001 Y2=110 Y3=100

Посторонний сигнал Z = 10001 Посторонний сигнал Z = 11011

Вариант 5 Вариант 6

Сигналы-прототипы Сигналы-прототипы

Х1 = 1 0 1 0 1 Х2 = 1 0 0 0 1 Х1 = 1 0 0 1 0 Х2 = 0 1 0 0 1

Х3 = 0 1 0 1 0 Х3 = 0 1 1 0 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 011 Y2=001 Y3=110 Y1 = 101 Y2=100 Y3=110

Посторонний сигнал Z = 10111 Посторонний сигнал Z = 01011

Вариант 7 Вариант 8

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 0 1 0 1 Х2 = 1 0 1 0 0 Х1 = 1 1 0 1 1 Х2 = 1 0 0 1 1

Х3 = 0 0 0 1 0 Х3 = 0 1 1 1 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 010 Y2=011 Y3=001 Y1 = 100 Y2=000 Y3=111

Посторонний сигнал Z = 10101 Посторонний сигнал Z = 11110

Вариант 9 Вариант 10

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 1 1 1 1 Х2 = 1 1 1 0 0 Х1 = 1 0 0 1 0 Х2 = 1 1 0 1 1

Х3 = 1 0 0 1 0 Х3 = 0 0 1 1 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 011 Y2=111 Y3=101 Y1 = 110 Y2=100 Y3=001

Посторонний сигнал Z = 11111 Посторонний сигнал Z = 11111

Вариант 11 Вариант 12

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 1 0 0 0 Х2 = 1 0 1 0 0 Х1 = 1 0 0 0 0 Х2 = 1 0 0 1 1

Х3 = 1 1 0 1 0 Х3 = 1 1 0 0 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 000 Y2=111 Y3=010 Y1 = 100 Y2=010 Y3=101

Посторонний сигнал Z = 10000 Посторонний сигнал Z = 11010

Вариант 13 Вариант 14

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 1 0 1 1 Х2 = 1 0 1 1 1 Х1 = 1 0 0 1 1 Х2 = 1 1 0 1 1

Х3 = 1 0 1 1 0 Х3 = 1 0 0 0 1

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 011 Y2=011 Y3=110 Y1 = 101 Y2=110 Y3=100

Посторонний сигнал Z = 10101 Посторонний сигнал Z = 11001

Вариант 15 Вариант 16

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 0 0 0 1 Х2 = 1 0 0 0 0 Х1 = 1 0 0 0 1 Х2 = 0 1 1 1 0

Х3 = 1 0 1 0 0 Х3 = 1 0 1 0 1

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 001 Y2=100 Y3=101 Y1 = 101 Y2=010 Y3=100

Посторонний сигнал Z = 01001 Посторонний сигнал Z = 10011

Вариант 17 Вариант 18

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 0 1 0 1 Х2 = 1 0 1 0 0 Х1 = 1 0 1 0 0 Х2 = 0 0 1 0 0

Х3 = 1 0 1 0 1 Х3 = 1 0 1 0 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 001 Y2=100 Y3=101 Y1 = 101 Y2=001 Y3=110

Посторонний сигнал Z = 10001 Посторонний сигнал Z = 11011

Вариант 19 Вариант 20

Сигналы-прототипы Сигналы-прототипы

Х1 = 1 1 1 0 1 Х2 = 1 0 1 1 0 Х1 = 1 0 0 1 1 Х2 = 0 0 1 1 0

Х3 = 1 1 1 0 0 Х3 = 1 1 1 0 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 111 Y2=101 Y3=001 Y1 = 100 Y2=001 Y3=010

Посторонний сигнал Z = 10100 Посторонний сигнал Z = 11011

Вариант 21 Вариант 22

Сигналы-прототипы Сигналы-прототипы

Х1 = 1 0 0 1 1 Х2 = 1 0 0 0 0 Х1 = 1 1 0 0 0 Х2 = 0 0 0 1 0

Х3 = 1 0 0 1 0 Х3 = 0 0 0 0 1

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 100 Y2=101 Y3=011 Y1 = 110 Y2=001 Y3=001

Посторонний сигнал Z = 10001 Посторонний сигнал Z = 11011

Вариант 23 Вариант 24

Сигналы-прототипы Сигналы-прототипы

Х1 = 1 0 0 0 1 Х2 = 1 0 1 0 0 Х1 = 1 1 0 1 0 Х2 = 0 0 1 1 0

Х3 = 1 0 0 1 1 Х3 = 0 0 1 0 1

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 100 Y2=101 Y3=010 Y1 = 110 Y2=011 Y3=001

Посторонний сигнал Z = 10001 Посторонний сигнал Z = 11011

Вариант 25 Вариант 26

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 0 0 1 0 Х2 = 0 0 0 0 1 Х1 = 0 1 1 1 0 Х2 = 0 1 0 0 1

Х3 = 0 1 1 1 0 Х3 = 1 0 1 1 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 1101 Y2=0101 Y3=1011 Y1 = 1001 Y2=0110 Y3=1110

Посторонний сигнал Z = 11010 Посторонний сигнал Z = 11110

Вариант 27 Вариант 28

Сигналы-прототипы Сигналы-прототипы

Х1 = 0 0 1 1 0 Х2 = 1 0 0 0 1 Х1 = 0 1 0 1 0 Х2 = 1 1 0 0 1

Х3 = 0 1 1 1 0 Х3 = 0 0 1 1 0

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 1001 Y2=0001 Y3=0011 Y1 = 1011 Y2=0111 Y3=1010

Посторонний сигнал Z = 10010 Посторонний сигнал Z = 10011

Вариант 29 Вариант 30

Сигналы-прототипы Сигналы-прототипы

Х1 = 1 1 0 1 0 Х2 = 0 1 0 0 1 Х1 = 0 1 0 0 1 Х2 = 1 1 0 0 1

Х3 = 0 1 0 1 0 Х3 = 1 0 1 1 1

Ассоциированные сигналы Ассоциированные сигналы

Y1 = 1111 Y2=0001 Y3=1001 Y1 = 1011 Y2=0100 Y3=0110

Посторонний сигнал Z = 00110 Посторонний сигнал Z = 01010

Задание № 4. Проектирование сети Хэмминга

Вариант 1 Вариант 2

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

0001110 0001010 1110000 1010000

1011000 0011000 0011100 0011101

0100011 0100010 0001011 0100011

Посторонний сигнал Посторонний сигнал

1011101 1010111

Вариант 3 Вариант 4

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

1101001 1101010 1110001 1010001

1011000 0111000 1001110 0011100

0100111 0100101 0101011 0100101

Посторонний сигнал Посторонний сигнал

1000011 1011111

Вариант 5 Вариант 6

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

1101011 1101010 1001001 1010001

1010100 1010000 0010110 0011110

0100101 0100111 0101011 0100011

Посторонний сигнал Посторонний сигнал

1010011 1111111

Вариант 7 Вариант 8

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

11010111 11010110 10010011 01110001

01101001 01101000 00101110 10101110

00100100 00000100 01010101 01010111

Посторонний сигнал Посторонний сигнал

10111001 00000110

Вариант 9 Вариант 10

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

10000101 10000111 10010010 01101110

01101000 01111000 11101110 10100010

00010010 00000010 01010001 01010111

Посторонний сигнал Посторонний сигнал

10111001 10111011

Вариант 11 Вариант 12

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

10110001 11110001 10010111 00010111

01101010 01101000 11101010 11101011

10000110 11000110 00110001 00110101

Посторонний сигнал Посторонний сигнал

10111101 10111111

Вариант 13 Вариант 14

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

011000011 011000001 111100000 111100001

100110000 000110000 000111000 010111000

000101010 100101010 010010010 010010110

Посторонний сигнал Посторонний сигнал

111110101 100111110

Вариант 15 Вариант 16

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

11100010 11100110 100101110 100101111

10010001 10011001 010010000 011010000

00001110 01001110 001100001 001000001

Посторонний сигнал Посторонний сигнал

11011010 100111110

Вариант 17 Вариант 18

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

11100100 11100101 1001000 1001001

10100010 10110010 0100111 0101110

00111001 00101001 0111000 0111001

Посторонний сигнал Посторонний сигнал

11011010 1001111

Вариант 19 Вариант 20

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

1010000 1010100 00010111 10010111

0100100 0001000 11001000 01001000

0001011 0001111 00101100 01001100

Посторонний сигнал Посторонний сигнал

1101111 01101111

Вариант 21 Вариант 22

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

110101000 110001000 100110010 100110011

001110000 001110001 011000000 011001000

000000111 000001111 010001100 110001100

Посторонний сигнал Посторонний сигнал

110111111 011011101

Вариант 23 Вариант 24

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

001101101 001101111 110110000 110110100

110001000 110011000 101000011 101001011

010000010 010010010 010001101 011000110

Посторонний сигнал Посторонний сигнал

110111111 011011101

Вариант 25 Вариант 26

Входные сигналы Входные сигналы

Сигналы- Синалы с Сигналы- Синалы с

прототипы искажениями прототипы искажениями

110000001 110010001 0100011 1100011

101010110 101011110 0110100 0110101

011100000 011100001 0010001 0011001

Посторонний сигнал Посторонний сигнал

110111111 0110111

– Конец работы –

Используемые теги: методические, указания, курсовой, работе, дисциплине, системы, искусственного, интеллекта0.112

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ: МЕТОДИЧЕСКИЕ УКАЗАНИЯ К КУРСОВОЙ РАБОТЕ ПО ДИСЦИПЛИНЕ СИСТЕМЫ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА

Что будем делать с полученным материалом:

Если этот материал оказался полезным для Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Хотите получать на электронную почту самые свежие новости?

Новости и инфо для студентов