рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Связь

- /

- СИГНАЛЫ и ЛИНЕЙНЫЕ СИСТЕМЫ

Реферат Курсовая Конспект

СИГНАЛЫ и ЛИНЕЙНЫЕ СИСТЕМЫ

СИГНАЛЫ и ЛИНЕЙНЫЕ СИСТЕМЫ - раздел Связь, Сигналы И Линейные Системы ...

СИГНАЛЫ и ЛИНЕЙНЫЕ СИСТЕМЫ

SIGNALS and LINEAR SYSTEMS. INTRODUCTION in the THEORY of SIGNALS and SYSTEMS

Тема 1: ВВЕДЕНИЕ В ТЕОРИЮ СИГНАЛОВ И СИСТЕМ

Одна из основных задач теории в любой области знаний – найти позицию, с которой объект виден в предельной простоте.

Джосайя Уиллард Гиббс. Американский физик, ХIХ в.

Для понимания истин, предельно простых для теоретиков, нормальному инженеру требуется специальная подготовка.

Роберт Тимофеевич Шарло. Уральский геофизик, ХХ в.

Содержание:

1.1. Общие сведения и понятия. Понятие сигнала. Шумы и помехи. Размерность сигналов. Математическое описание сигналов. Математические модели сигналов. Виды моделей. Классификация сигналов.

1.2. Типы сигналов. Аналоговый сигнал. Дискретный сигнал. Цифровой сигнал. Преобразования типа сигналов. Спектральное представление сигналов. Графическое отображение сигналов. Тестовые сигналы.

1.3. Системы преобразования сигналов. Общее понятие систем. Основные системные операции. Линейные системы.

1.4. Информационная емкость сигналов. Понятие информации. Количественная мера информации. Энтропия источника информации. Основные свойства энтропии Энтропия непрерывного источника информации. Информационная емкость сигналов.

Литература.

1.1. Общие сведения и понятия [1,10, 15, 25]

Понятие сигнала. В XVIII веке в теорию математики вошло понятие функции, как определенной зависимости какой-либо величины y от другой величины – независимой переменной х, с математической записью такой зависимости в виде у(х). Довольно скоро математика функций стала базовой основой теории всех естественных и технических наук. Особое значение функциональная математика приобрела в технике связи, где временные функции вида s(t), v(f) и т.п., используемые для передачи информации, стали называть сигналами.

В технических отраслях знаний термин "сигнал" (signal, от латинского signum – знак) очень часто используется в широком смысловом диапазоне, без соблюдения строгой терминологии. Под ним понимают и техническое средство для передачи, обращения и использования информации - электрический, магнитный, оптический сигнал; и физический процесс, представляющий собой материальное воплощение информационного сообщения - изменение какого-либо параметра носителя информации (напряжения, частоты, мощности электромагнитных колебаний, интенсивности светового потока и т.п.) во времени, в пространстве или в зависимости от изменения значений каких-либо других аргументов (независимых переменных); и смысловое содержание определенного физического состояния или процесса, как, например, сигналы светофора, звуковые предупреждающие сигналы и т.п. Все эти понятия объединяет конечное назначение сигналов. Это определенные сведения, сообщения, информация о каких-либо процессах, состояниях или физических величинах объектов материального мира, выраженные в форме, удобной для передачи, обработки, хранения и использования этих сведений.

Термин “сигнал” очень часто отождествляют с понятиями “данные” (data) и “информация” (information). Действительно, эти понятия взаимосвязаны и не существуют одно без другого, но относятся к разным категориям.

Понятие информации имеет много определений, от наиболее широкого (информация есть формализованное отражение реального мира) до практического (сведения и данные, являющиеся объектом хранения, передачи, преобразования, восприятия и управления). В настоящее время мировая наука все больше склоняется к точке зрения, что информация, наряду с материей и энергией, принадлежит к фундаментальным философским категориям естествознания и отнести к одному из свойств объективного мира, хотя и несколько специфичному. Что касается “данных” (от латинского datum – факт), то это совокупность фактов, результатов наблюдений, измерений о каких-либо объектах, явлениях или процессах материального мира, представленных в формализованном виде, количественном или качественном. Это не информация, а только атрибут информации - сырье для получения информации путем соответствующей обработки и интерпретации (истолкования).

Наука и техника интернациональны, и используют, в основном, общепринятые термины, большинство из которых англоязычны. Термин "signal" в мировой практике является общепринятым для характеристики формы представления данных, при которой данные рассматриваются как результат некоторых измерений объекта исследований в виде последовательности значений скалярных величин (аналоговых, числовых, графических и пр.) в зависимости от изменения каких-либо переменных значений (времени, энергии, температуры, пространственных координат, и пр.). С учетом этого, в дальнейшем под термином “сигнал” в узком смысле этого слова будем понимать каким-либо образом упорядоченное отображение в изменении физического состояния какого-либо объекта – материального носителя сигнала, определенных данных о характере изменения в пространстве, во времени или по любой другой переменной физических величин, физических свойств или физического состояния объекта исследований. А так как данные содержат информацию, как об основных целевых параметрах объекта исследований, так и о различных сопутствующих и мешающих факторах измерений, то в широком смысле этого слова можно считать, что сигнал является носителем общей измерительной информации. При этом материальная форма носителей сигналов (механическая, электрическая, магнитная, акустическая, оптическая и любая другая), равно как и форма отображения в каких-либо физических параметрах или процессах носителей, значения не имеет. Информативным параметром сигнала может являться любой параметр носителя сигнала, функционально связанный со значениями информационных данных.

Сигнал, в самом общем смысле, это зависимость одной величины от другой, и с математической точки зрения представляет собой функцию. Наиболее распространенное представление сигналов - в электрической форме в виде зависимости напряжения от времени U(t). Так, например, сигнал изменения напряженности магнитного поля по профилю аэросъемки – это и временная последовательность изменения электрического напряжения на выходе датчика аэромагнитометра, и запись этого напряжения на ленте регистратора, и последовательные значения цифровых отсчетов при обработке лент регистратора и вводе сигнала в ЭВМ.

Рис. 1.1.1. Сигнал.

Рис. 1.1.1. Сигнал.

|

Сигнал - это информационная функция, несущая сообщение о физических свойствах, состоянии или поведении какой-либо физической системы, объекта или среды, а целью обработки сигналов можно считать извлечение определенных информационных сведений, которые отображены в этих сигналах (кратко - полезная или целевая информация) и преобразование этих сведений в форму, удобную для восприятия и дальнейшего использования.

Под "анализом" сигналов (analysis) имеется в виду не только их чисто математические преобразования, но и получение на основе этих преобразований выводов о специфических особенностях соответствующих процессов и объектов. Целями анализа сигналов обычно являются:

- Определение или оценка числовых параметров сигналов (энергия, средняя мощность, среднее квадратическое значение и пр.).

- Разложение сигналов на элементарные составляющие для сравнения свойств различных сигналов.

- Сравнение степени близости, "похожести", "родственности" различных сигналов, в том числе с определенными количественными оценками.

Математический аппарат анализа сигналов весьма обширен, и широко применяется на практике во всех без исключения областях науки и техники.

С понятием сигнала неразрывно связан термин регистрациисигналов, использование которого также широко и неоднозначно, как и самого термина сигнал. В наиболее общем смысле под этим термином можно понимать операцию выделения сигнала и его преобразования в форму, удобную для дальнейшего использования. Так, при получении информации о физических свойствах каких-либо объектов, под регистрацией сигнала понимают процесс измерения физических свойств объекта и перенос результатов измерения на материальный носитель сигнала или непосредственное энергетическое преобразование каких-либо свойств объекта в информационные параметры материального носителя сигнала (как правило - электрического). Но так же широко термин регистрации сигналов используют и для процессов выделения уже сформированных сигналов, несущих определенную информацию, из суммы других сигналов (радиосвязь, телеметрия и пр.), и для процессов фиксирования сигналов на носителях долговременной памяти, и для многих других процессов, связанных с обработкой сигналов.

Применительно к настоящему курсу под термином регистрации будем понимать регистрацию данных (data logging) которые проходят через конкретную систему или точку системы и определенным образом фиксируются на каком-либо материальном носителе или в памяти системы. Что касается процесса получения информации при помощи технических средств, обеспечивающих опытным путем нахождение соотношения измеряемой величины с принятой по определению образцовой единицей этой величины, и представление измеренного соотношения в какой-либо физической или числовой форме информационного сигнала, то для этого процесса будем применять, в основном, термин детектирования.

Шумы и помехи (noise). При детектировании сигналов, несущих целевую для данного вида измерений информацию, в сумме с основным сигналом одновременно регистрируются и мешающие сигналы - шумы и помехи самой различной природы (рис. 1.1.2). К помехам относят также искажения полезных сигналов при влиянии различных дестабилизирующих факторов на процессы измерений, как, например, влияние микрокаверн в стенках скважины на измерения в рентгенорадиометрических методах каротажа, грозовых разрядов на электроразведочные методы измерений и т.п. Выделение полезных составляющих из общей суммы зарегистрированных сигналов или максимальное подавление шумов и помех в информационном сигнале при сохранении его полезных составляющих является одной из основных задач первичной обработки сигналов (результатов наблюдений).

Рис. 1.1.2. Сигнал с помехами.

Рис. 1.1.2. Сигнал с помехами.

|

Типы помех разделяют по источникам их возникновения, по энергетическому спектру, по характеру воздействия на сигнал, по вероятностным характеристикам и другим признакам.

Источники помех бывают внутренние и внешние.

Внутренние шумы могут быть присущи физической природе источников сигналов, как, например, тепловые шумы электронных потоков в электрических цепях или дробовые эффекты в электронных приборах, или возникают в измерительных устройствах и системах передачи и обработки сигналов от влияния различных дестабилизирующих факторов - температуры, повышенной влажности, нестабильности источников питания, влияния механических вибраций на гальванические соединения, и т.п.

Внешние источники шумов бывают искусственного и естественного происхождения. К искусственным источникам помех относятся индустриальные помехи - двигатели, переключатели, генераторы сигналов различной формы и т.д. Естественными источниками помех являются молнии, флюктуации магнитных полей, всплески солнечной энергии, и т.д.

Электрические и магнитные поля различных источников помех вследствие наличия индуктивных, емкостных и резистивных связей создают на различных участках и цепях сигнальных систем паразитные разности потенциалов и токи, накладывающиеся на полезные сигналы.

Помехи подразделяются на флюктуационные, импульсные и периодические. Флюктуационные или шумовые помехи представляют хаотический и беспорядочный во времени процесс в виде нерегулярных случайных всплесков различной амплитуды. Как правило, флюктуационные помехи распределены по нормальному закону с нулевым средним и оказывают существенное влияние только на сигналы низкого уровня.

Импульсные помехи во многом похожи на шумовые помехи и проявляются как в виде отдельных импульсов, так и в виде последовательности импульсов, форма и параметры которых имеют случайный характер. Причинами импульсных помех являются резкие броски тока и напряжения в промышленных установках, транспортных средствах, а также природные электрические явления. Распределение импульсных помех симметричное с произвольной плотностью распределения.

Периодические помехи вызываются периодическими низкочастотными или высокочастотными полями линий электропередач, силовых электроустановок и др. Если основная мощность помех сосредоточена на отдельных участках диапазона частот, например, на частоте напряжения промышленной сети или кратна этой частоте, то такие помехи называют сосредоточенными.

В зависимости от характера воздействия на сигнал помехи разделяют на аддитивные и мультипликативные. Аддитивные (налагающиеся) помехи суммируются с сигналом, не зависят от его значений и формы и не изменяют информативной составляющей самого сигнала. Мультипликативные или деформирующие помехи могут изменять форму информационной части сигнала, иметь зависимость от его значений и от определенных особенностей в сигнале и т.п. При известном характере мультипликативных помех возможна коррекция сигнала на их влияние.

Следует заметить, что деление сигналов на полезные и мешающие (шумовые) является достаточно условным. Источниками мешающих сигналов также являются определенные физические процессы, явления или объекты. При выяснении природы мешающих сигналов они могут переводиться в разряд информационных. Так, например, вариации диаметра скважин является мешающим фактором практически для всех ядерно-физических методов каротажа. Вместе с тем этот же фактор, при соответствующем методическом и аппаратурном обеспечении, может дать возможность бесконтактного определения диаметра скважин в качестве дополнительного информационного параметра.

Размерность сигналов. Простейшими сигналами геофизической практики являются одномерные сигналы, как, например, сейсмические импульсы s(t), измерения каких-либо параметров геофизических полей (электрических, магнитных, и пр.) по профилям на поверхности земли s(x) или по стволу скважины s(h), и т.п. Значения одномерных сигналов зависят только от одной независимой переменной, как, например, на рис. 1.1.1 и 1.1.2.

Рис. 1.1.3. Двумерный сигнал.

Рис. 1.1.3. Двумерный сигнал.

|

В общем случае сигналы являются многомерными функциями пространственных, временных и прочих независимых переменных - сейсмическая волна вдоль линии профиля s(x,t), аномалия гравитационного поля на поверхности наблюдений s(x,y), пространственно - энергетическое распределение потока ионизирующих частиц или квантов от источника излучения s(x,y,z,Е) и т.п. Все большее применение находят также многомерные сигналы, образованные некоторым множеством одномерных сигналов, как, например, комплексные каротажные измерения нескольких физических параметров горных пород по стволу скважины одновременно.

Многомерные сигналы могут иметь различное представление по своим аргументам. Так, полный акустический сигнал сейсмического профиля дискретен по пространству (точкам расположения приемников) и непрерывен по времени.

Многомерный сигнал может рассматриваться, как упорядоченная совокупность одномерных сигналов. С учетом этого при анализе и обработке сигналов многие принципы и практические методы обработки одномерных сигналов, математический аппарат которых развит достаточно глубоко, распространяются и на многомерные сигналы. Физическая природа сигналов для математического аппарата их обработки значения не имеет.

Вместе с тем обработка многомерных сигналов имеет свои особенности, и может существенно отличаться от одномерных сигналов в силу большего числа степеней свободы. Так, при дискретизации многомерных сигналов имеет значение не только частотный спектр сигналов, но и форма растра дискретизации. Пример не очень полезной особенности - многомерные полиномы сигнальных функций, в отличие от одномерных, не разлагаются на простые множители. Что касается порядка размерности многомерных сигналов, то ее увеличение выше двух практически не изменяет принципы и методы анализа данных, и сказывается, в основном, только на степени громоздкости формул и чисто техническом усложнении вычислений.

Учитывая эти факторы, при рассмотрении общей теории анализа, преобразований и обработки сигналов ограничимся, в основном, одно- и двумерными сигнальными функциями, а в качестве универсальных независимых переменных (аргументов функций) будем использовать, как правило, переменную "t" для одномерных сигналов и переменные "x,t" или "x,y" для двумерных сигналов, безотносительно к их физическому содержанию (пространство, время, энергия и пр.).

Математическое описание сигналов. Сигналы могут быть объектами теоретических исследований и практического анализа только в том случае, если указан способ их математического описания - математическая модель сигнала. Математическое описание позволяет абстрагироваться от физической природы сигнала и материальной формы его носителя, проводить классификацию сигналов, выполнять их сравнение, устанавливать степень тождества, моделировать системы обработки сигналов. Как правило, описание сигнала задается функциональной зависимостью определенного информационного параметра сигнала от независимой переменной (аргумента) – s(х), y(t) и т.п. Функции математического описания сигналов могут быть как вещественными, так и комплексными. Выбор математического аппарата описания определяется простотой и удобством его использования при анализе и обработке сигналов.

Отметим двойственность применения описания сигналов функциями типа s(t) и т.п. С одной стороны s(t) – это величина, равная значению функции в момент времени t. С другой стороны мы обозначаем также через s(t) и саму функцию, т.е. то правило, по которому каждому значению t ставится в соответствие определенная величина s. В большинстве аналитических выражений это не вызывает недоразумений и при однозначном соответствии значений сигналов их аналитическим выражениям принимается по умолчанию.

Сделаем также одно замечание по терминологии описания сигналов. В теоретических работах по анализу сигналов конкретные значения величины сигнала (отсчеты значений по аргументу) часто именуют координатами сигнала. В отраслях знаний, связанных с геологией и горным делом, и в геофизической практике в том числе, этот термин используется по своему прямому смысловому назначению – пространственных координат результатов измерений, и является неизменным атрибутом всех геолого-геофизических данных. С учетом последнего фактора условимся применять термин “координата” по своему традиционному смысловому назначению в качестве обобщающего термина для независимых переменных сигнальных функций. При этом под понятием координат значений сигнала будем понимать не только какие-либо пространственные координаты, как это непосредственно имеет место для результатов измерений при геолого-геофизических съемках, но и любые другие аргументы, на числовой оси которых отложены значения или отсчеты сигнала и рассматривается динамика его изменения (пример на рис. 1.1.1).

Математические модели сигналов. Теория анализа и обработки физических данных базируется на математических моделях соответствующих физических полей и физических процессов, на основе которых создаются математические модели сигналов. Математические модели сигналов дают возможность обобщенно, абстрагируясь от физической природы, судить о свойствах сигналов, предсказывать изменения сигналов в изменяющихся условиях, заменять физическое моделирование изучаемых процессов математическим. С помощью математических моделей имеется возможность описывать свойства сигналов, которые являются главными, определяющими в изучаемых процессах, и игнорировать большое число второстепенных признаков. Знание математических моделей сигналов дает возможность классифицировать их по различным признакам, характерным для того или иного типа моделей. Так, сигналы разделяются на неслучайные и случайные в зависимости от возможности точного предсказания их значений в любые моменты времени. Сигнал является неслучайным и называется детерминированным, если математическая модель позволяет осуществлять такое предсказание. Детерминированный сигнал задается, как правило, математической функцией или вычислительным алгоритмом, а математическая модель сигнала может быть представлена в виде

s = F(t,z,w,…; A,B,C,…),

где s – информативный параметр сигнала; t, z, w, … – независимые аргументы (время, пространственная координата, частота и др.); A, B, C… – параметры сигналов.

Модель должна быть, по возможности, проще и минимизирована по количеству независимых аргументов и адекватна изучаемому процессу, что во многом предопределяет результаты измерений. Рассмотрим этот вопрос на примере геофизических данных.

Под геофизическим полем понимают собственное или индуцированное определенным внешним воздействием распределение какой-либо физической величины, создаваемое геологическим объектом или геологической структурой в пространстве, во времени или по любому другому аргументу (независимой переменной). В простейшем случае геофизический сигнал - это изменение какой-либо составляющей геофизического поля, т.е. сечение поля по одному из аргументов. В пределе все геофизическое поле в целом может рассматриваться как первичный многомерный сигнал в прямом физическом отображении, с которого путем измерений могут сниматься формализованные копии определенных составляющих (сечений) сигнала на материальные носители информации.

Геофизическим полям в определенных условиях их регистрации соответствуют определенные математические модели сигналов, т.е. их описание на каком-либо формальном языке. Математическое описание не может быть всеобъемлющим и идеально точным и, по существу, всегда отображает не реальные объекты, а их упрощенные (гомоморфные) модели. Модели могут задаваться таблицами, графиками, функциональными зависимостями, уравнениями состояний и переходов из одного состояния в другое и т.п. Формализованное описание может считаться математической моделью оригинала, если оно позволяет с определенной точностью прогнозировать состояние и поведение изучаемых объектов путем формальных процедур над их описанием.

Неотъемлемой частью любой математической модели сигнала является также область определения сигнала, которая устанавливается интервалом задания независимой переменной. Примеры задания интервала для переменных:

a ≤ x ≤ b, x Î [a,b].

a < y ≤ b, y Î (a,b].

a < z < b, z Î (a,b).

Пространство значений независимой переменной обычно обозначается через индекс R. Так, например, R:=(-¥ ,+¥), x Î R.

Кроме задания области определения сигнала могут быть также заданы виды численных значений переменных (целые, рациональные, вещественные, комплексные).

Математические модели полей и сигналов на первом этапе обработки и анализа результатов наблюдений должны позволять в какой-то мере игнорировать их физическую природу и возвращать ее в модель только на заключительном этапе интерпретации данных.

Виды моделей сигналов. При анализе физических данных используются два основных подхода к созданию математических моделей сигналов.

Первый подход оперирует с детерминированными сигналами, значения которых в любой момент времени или в произвольной точке пространства (а равно и в зависимости от любых других аргументов) являются априорно известными или могут быть достаточно точно определены (вычислены). Такой подход удобен в прямых задачах геофизики (расчеты полей для заданных моделей сред), в задачах активных воздействий на среду при заранее известных параметрах и форме сигнала воздействия (вибрационная сейсморазведка, электромагнитные методы каротажа и пр.), а также при использовании хорошо известных и достоверных геолого-геофизических данных. Для описания неслучайных сигналов используются также квазидетерминированные модели, в которых значения одного или нескольких параметров априорно неизвестны и считаются случайными величинами с малой случайной компонентой, влиянием которой можно пренебречь.

Второй подход предполагает случайный характер сигналов, закон изменения которых во времени (или в пространстве) носит случайный характер и которые принимают конкретные значения с некоторой вероятностью. Модель такого сигнала представляет собой описание статистических характеристик случайного процесса путем задания законов распределения вероятностей, корреляционной функции, спектральной плотности энергии и др.

Случайность может быть обусловлена как собственной физической природой сигналов, что характерно, например, для методов ядерной геофизики, так и вероятностным характером регистрируемых сигналов как по времени или месту их появления, так и по содержанию. С этих позиций случайный сигнал может рассматриваться как отображение случайного по своей природе процесса или физических свойств объекта (процесса), которые определяются случайными параметрами или сложным строением геологической среды, результаты измерений в которой трудно предсказуемы.

Между этими двумя видами сигналов нет резкой границы. Строго говоря, детерминированных процессов и отвечающих им детерминированных сигналов в природе не существует. Даже сигналы, хорошо известные на входе в среду (при внешнем воздействии на нее), по месту их регистрации всегда осложнены случайными помехами, влиянием дестабилизирующих факторов и априорно неизвестными параметрами и строением самой среды. С другой стороны, модель случайного поля часто аппроксимируется методом суперпозиции (сложения) сигналов известной формы. Детерминированные модели могут использоваться и для изучения чисто случайных процессов, если уровень полезного сигнала в этом процессе значительно выше уровня статистических флюктуаций, что имеет место, например, при регистрации ионизирующих излучений от горных пород.

На выбор математической модели поля в том или ином методе геофизики в немалой степени влияет также сложность математического аппарата обработки сигналов и сложившиеся традиции геологической интерпретации результатов наблюдений. Не исключается и изменение модели, как правило, с переводом из вероятностной в детерминированную, в процессе накопления информации об изучаемом явлении или объекте.

Рис. 1.1.4. Классификация сигналов.

Классификация сигналов осуществляется на основании существенных признаков соответствующих математических моделей сигналов.Все сигналы разделяют на две крупных группы: детерминированные и случайные (рис. 1.1.4).

Классификация детерминированных сигналов. Обычно выделяют два класса детерминированных сигналов: периодические и непериодические.

К периодическим относят гармонические и полигармонические сигналы. Для периодических сигналов выполняется общее условие s(t) = s(t + kT), где k = 1, 2, 3, ... - любое целое число, Т - период, являющийся конечным отрезком времени.

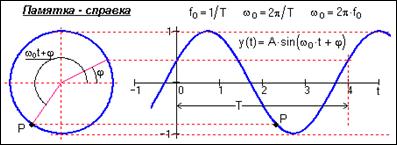

Гармонические сигналы (или синусоидальные), описываются следующими формулами:

Гармонические сигналы (или синусоидальные), описываются следующими формулами:

s(t) = A×sin (2pfоt+f) =

A×sin (wоt+f), (1.1.1)

или:

s(t) = A×cos(wоt+j),

где А, fo, wo, j, f - постоянные величины, которые могут исполнять роль информационных параметров сигнала: А - амплитуда сигнала, fо - циклическая частота в герцах, wо = 2pfо - угловая частота в радианах, j и f- начальные фазовые углы в радианах. Период одного колебания T = 1/fо = 2p/wo. При j = f-p/2 синусные и косинусные функции описывают один и тот же сигнал. Частотный спектр сигнала представлен амплитудным и начальным фазовым значением частоты fо (при t = 0).

Рис. 1.1.5. Гармонический сигнал и спектр его амплитуд.

Полигармонические сигналы составляют наиболее широко распространенную группу периодических сигналов и описываются суммой гармонических колебаний:

s(t) = Ansin (2pfnt+jn), (1.1.2)

Ansin (2pfnt+jn), (1.1.2)

или непосредственно функцией s(t) = y(t ± kTp), k = 1,2,3,..., где Тр - период одного полного колебания сигнала y(t), заданного на одном периоде. Значение fp =1/Tp называют фундаментальной частотой колебаний. Полигармонические сигналы представляют собой сумму определенной постоянной составляющей (fо = 0) и произвольного (в пределе - бесконечного) числа гармонических составляющих с произвольными значениями амплитуд An и фаз jn, и с периодами, кратными периоду фундаментальной частоты fp. Другими словами, на периоде фундаментальной частоты fp, которая равна или кратно меньше минимальной частоты гармоник, укладывается кратное число периодов всех гармоник, что и создает периодичность повторения сигнала. Частотный спектр полигармонических сигналов дискретен, в связи с чем второе распространенное математическое представление сигналов - в виде спектров (рядов Фурье).

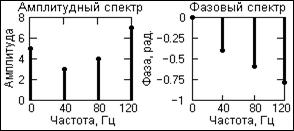

В качестве примера на рис. 1.1.6 приведен отрезок периодической сигнальной функции, которая получена суммированием постоянной составляющей (частота постоянной составляющей равна 0) и трех гармонических колебаний с разными значениями частоты и начальной фазы колебаний. Математическое описание сигнала задается формулой:

s(t) = Ak×cos(2×p×fk×t+jk),

Ak×cos(2×p×fk×t+jk),

где: Ak = {5, 3, 4, 7} - амплитуда гармоник; fk = {0, 40, 80, 120} - частота в герцах; jk = {0, -0.4, -0.6, -0.8} - начальный фазовый угол колебаний в радианах; k = 0,1,2,3. Фундаментальная частота сигнала 40 Гц.

Рис. 1.1.6. Временная модель сигнала. Рис. 1.1.7. Спектр сигнальной функции.

Частотное представление данного сигнала (спектр сигнала) приведено на рис. 1.1.7. Обратим внимание, что частотное представление периодического сигнала s(t), ограниченного по числу гармоник спектра, составляет всего восемь отсчетов и весьма компактно по сравнению с множеством точек непрерывного временного представления.

Периодический сигнал любой произвольной формы может быть представлен в виде суммы гармонических колебаний с частотами, кратными фундаментальной частоте колебаний fр = 1/Тр. Для этого достаточно разложить один период сигнала в ряд Фурье по тригонометрическим функциям синуса и косинуса с шагом по частоте, равным фундаментальной частоте колебаний Df = fp:

s(t) =  (ak cos 2pkDft + bk sin 2pkDft), (1.1.3)

(ak cos 2pkDft + bk sin 2pkDft), (1.1.3)

ao = (1/T) s(t) dt, ak = (2/T)

s(t) dt, ak = (2/T) s(t) cos 2pkDft dt, (1.1.4)

s(t) cos 2pkDft dt, (1.1.4)

bk = (2/T) s(t) sin 2pkDft dt. (1.1.5)

s(t) sin 2pkDft dt. (1.1.5)

Количество членов ряда Фурье K = kmax обычно ограничивается максимальными частотами fmax гармонических составляющих в сигналах так, чтобы fmax < K·fp. Однако для сигналов с разрывами и скачками имеет место fmax ® ¥ , при этом количество членов ряда ограничивается по допустимой погрешности аппроксимации функции s(t).

Одночастотные косинусные и синусные гармоники можно объединить и представить разложение в более компактной форме:

s(t) =  Sk cos (2pkDft-jk), (1.1.3')

Sk cos (2pkDft-jk), (1.1.3')

Sk = , jk = argtg (bk/ak). (1.1.6)

, jk = argtg (bk/ak). (1.1.6)

Рис. 1.1.8. Прямоугольный периодический сигнал (меандр).

Пример представления прямоугольного периодического сигнала (меандра) в виде амплитудного ряда Фурье в частотной области приведен на рис. 1.1.8 (сигнал четный относительно t=0, не имеет синусных гармоник, все значения jk для данной модели сигнала равны нулю).

Информационными параметрами полигармонического сигнала могут быть как определенные особенности формы сигнала (размах от минимума до максимума, экстремальное отклонение от среднего значения, и т.п.), так и параметры определенных гармоник в этом сигнале. Так, например, для прямоугольных импульсов информационными параметрами могут быть период повторения импульсов, длительность импульсов, скважность импульсов (отношение периода к длительности). При анализе сложных периодических сигналов информационными параметрами могут также быть:

- Текущее среднее значение за определенное время, например, за время периода:

(1/Т) s(t) dt.

s(t) dt.

- Постоянная составляющая одного периода:

(1/Т) s(t) dt.

s(t) dt.

- Среднее выпрямленное значение:

(1/Т) |s(t)| dt.

|s(t)| dt.

- Среднее квадратичное значение:

.

.

К непериодическим сигналам относят почти периодические и апериодические или переходные сигналы. Основным инструментом их анализа также является частотное представление.

Рис. 1.1.9. Почти периодический сигнал

и спектр его амплитуд.

Рис. 1.1.9. Почти периодический сигнал

и спектр его амплитуд.

|

Почти периодические сигналы близки по своей форме к полигармоническим. Они также представляют собой сумму двух и более гармонических сигналов (в пределе – до бесконечности), но не с кратными, а с произвольными частотами, отношения которых (хотя бы двух частот минимум) не относятся к рациональным числам, вследствие чего фундаментальный период суммарных колебаний бесконечно велик. Так, например, сумма двух гармоник с частотами 2fo и 3.5fo дает периодический сигнал (2/3.5 – рациональное число) с фундаментальной частотой 0.5fo, на одном периоде которой будут укладываться 4 периода первой гармоники и 7 периодов второй. Но если значение частоты второй гармоники заменить близким значением  fo, то сигнал перейдет в разряд непериодических, поскольку отношение 2/

fo, то сигнал перейдет в разряд непериодических, поскольку отношение 2/ не относится к числу рациональных чисел. Как правило, почти периодические сигналы порождаются физическими процессами, не связанными между собой. Математическое отображение сигналов тождественно полигармоническим сигналам (сумма гармоник), а частотный спектр также дискретен.

не относится к числу рациональных чисел. Как правило, почти периодические сигналы порождаются физическими процессами, не связанными между собой. Математическое отображение сигналов тождественно полигармоническим сигналам (сумма гармоник), а частотный спектр также дискретен.

Апериодические сигналы составляют основную группу непериодических сигналов и задаются произвольными функциями времени. На рис. 1.1.10 показан пример апериодического сигнала, заданного формулой на интервале (0, ¥):

s(t) = exp(-a×t) - exp(-b×t),

где a и b – константы, в данном случае a = 0.15, b = 0.17.

К апериодическим сигналам относятся также импульсные сигналы, которые в радиотехнике и в отраслях, широко ее использующих, часто рассматривают в виде отдельного класса сигналов. Импульсы представляют собой сигналы, как правило, определенной и достаточно простой формы, существующие в пределах конечных временных интервалов. Сигнал, приведенный на рис. 1.1.11, относится к числу импульсных.

Рис. 1.1.10. Апериодический сигнал и модуль спектра. Рис. 1.1.11. Импульсный сигнал и модуль спектра.

Частотный спектр апериодических сигналов непрерывен и может содержать любые гармоники в частотном интервале (0-¥). Для его вычисления используется интегральное преобразование Фурье, которое можно получить переходом в формулах (1.1.3) от суммирования к интегрированию при Df ® 0 и kDf ® f.

s(t) = (a(f) cos 2pft + b(f) sin 2pft) df =

(a(f) cos 2pft + b(f) sin 2pft) df = S(f) cos(2pft-j(f)) df. (1.1.7)

S(f) cos(2pft-j(f)) df. (1.1.7)

a(f) =  s(t) cos 2pft dt, b(f) =

s(t) cos 2pft dt, b(f) =  s(t) sin 2pft dt, (1.1.8)

s(t) sin 2pft dt, (1.1.8)

S(f) = , j(f) = argtg (b(f)/a(f)). (1.1.9)

, j(f) = argtg (b(f)/a(f)). (1.1.9)

Частотные функции a(f), b(f) и S(f) представляют собой не амплитудные значения соответствующих гармоник на определенных частотах, а распределения спектральной плотности амплитуд этих гармоник по частотной шкале. Формулы (1.1.8-1.1.9) обычно называют формулами прямого преобразования Фурье, формулы (1.1.7) – обратного преобразования.

Если нас не интересует поведение сигнала за пределами области его задания, то эта область может восприниматься, как один период периодического сигнала и, соответственно, применяться для его представления разложение в ряды Фурье по (1.1.3-1.1.6).

В классе импульсных сигналов выделяют подкласс радиоимпульсов. Пример радиоимпульса приведен на рис. 1.1.12.

Рис. 1.1.12. Радиоимпульс и модуль его спектра.

Уравнение радиоимпульса имеет вид:

s(t) = u(t) cos(2pfot+jo).

где cos(2pfot+jo) – гармоническое колебание заполнения радиоимпульса, u(t) – огибающая радиоимпульса.

С энергетических позиций сигналы разделяют на два класса: с ограниченной (конечной) энергией и с бесконечной энергией.

Для сигналов с ограниченной энергией (иначе – сигналов с интегрируемым квадратом) должно выполняться соотношение:

|s(t)|2dt < ∞.

|s(t)|2dt < ∞.

Как правило, к этому классу сигналов относятся апериодические и импульсные сигналы, не имеющие разрывов 2-го рода при ограниченном количестве разрывов 1-го рода, и особых точек, уходящих в бесконечность. Любые периодические, полигармонические и почти периодические сигналы, а также сигналы с разрывами и особыми точками 2-го рода, относятся к сигналам с бесконечной энергией. Для их анализа применяются специальные методы.

Иногда в отдельный класс выделяют сигналы конечной длительности, отличные от нуля только на ограниченном интервале аргументов (независимых переменных). Такие сигналы обычно называют финитными.

Классификация случайных сигналов. Случайным сигналом называют функцию времени, значения которой заранее неизвестны, и могут быть предсказаны лишь с некоторой вероятностью. Случайный сигнал отображает случайное физическое явление или физический процесс, причем зарегистрированный в единичном наблюдении сигнал не воспроизводится при повторных наблюдениях и не может быть описан явной математической зависимостью. При регистрации случайного сигнала реализуется только один из возможных вариантов (исходов) случайного процесса, а достаточно полное и точное описание процесса в целом можно произвести только после многократного повторения наблюдений и вычисления определенных статистических характеристик ансамбля реализаций сигнала. В качестве основных статистических характеристик случайных сигналов принимают:

а) закон распределения вероятности нахождения величины сигнала в определенном интервале значений;

б) спектральное распределение мощности сигнала.

Случайные сигналы подразделяют на стационарные и нестационарные. Случайные стационарные сигналы сохраняют свои статистические характеристики в последовательных реализациях случайного процесса. Что касается случайных нестационарных сигналов, то их общепринятой классификации не существует. Как правило, из них выделяют различные группы сигналов по особенностям их нестационарности.

1.2. Типы сигналов [1,10,15]

Выделяют следующие типы сигналов, которым соответствуют определенные формы их математического описания.

Рис. 1.2.1. Аналоговый сигнал.

Рис. 1.2.1. Аналоговый сигнал.

|

Аналоговый сигнал (analog signal) является непрерывной функцией непрерывного аргумента, т.е. определен для любого значения аргументов. Источниками аналоговых сигналов, как правило, являются физические процессы и явления, непрерывные в динамике своего развития во времени, в пространстве или по любой другой независимой переменной, при этом регистрируемый сигнал подобен (“аналогичен”) порождающему его процессу. Пример математической записи сигнала: y(t) = 4.8 exp[-(t-4)2/2.8]. Пример графического отображения данного сигнала приведен на рис. 1.2.1, при этом как сама функция, так и ее аргументы, могут принимать любые значения в пределах некоторых интервалов y1 £ y £ y2, t1 £ t £ t2. Если интервалы значений сигнала или его независимых переменных не ограничиваются, то по умолчанию они принимаются равными от -¥ до +¥. Множество возможных значений сигнала образует континуум - непрерывное пространство, в котором любая сигнальная точка может быть определена с точностью до бесконечности. Примеры сигналов, аналоговых по своей природе - изменение напряженности электрического, магнитного, электромагнитного поля во времени и в пространстве.

Рис. 1.2.2. Дискретный сигнал

Рис. 1.2.2. Дискретный сигнал

|

Дискретный сигнал (discrete signal) по своим значениям также является непрерывной функцией, но определенной только по дискретным значениям аргумента. По множеству своих значений он является конечным (счетным) и описывается дискретной последовательностью отсчетов (samples) y(nDt), где y1 £ y £ y2, Dt - интервал между отсчетами (интервал или шаг дискретизации, sample time), n = 0,1,2,...,N. Величина, обратная шагу дискретизации: f = 1/Dt, называется частотой дискретизации (sampling frequency). Если дискретный сигнал получен дискретизацией (sampling) аналогового сигнала, то он представляет собой последовательность отсчетов, значения которых в точности равны значениям исходного сигнала по координатам nDt.

Пример дискретизации аналогового сигнала, приведенного на рис. 1.2.1, представлен на рис. 1.2.2. При Dt = const (равномерная дискретизация данных) дискретный сигнал можно описывать сокращенным обозначением y(n). В технической литературе в обозначениях дискретизированных функций иногда оставляют прежние индексы аргументов аналоговых функций, заключая последние в квадратные скобки - y[t]. При неравномерной дискретизации сигнала обозначения дискретных последовательностей (в текстовых описаниях) обычно заключаются в фигурные скобки - {s(ti)}, а значения отсчетов приводятся в виде таблиц с указанием значений координат ti. Для числовых последовательностей (равномерных и неравномерных) применяется и следующее числовое описание: s(ti) = {a1,a2, ..., aN}, t = t1,t2, ...,tN. Примеры дискретных геофизических сигналов - результаты вертикального электрического зондирования, профили геохимического опробования и т.п.

Рис. 1.2.3. Цифровой сигнал

Рис. 1.2.3. Цифровой сигнал

|

Цифровой сигнал (digital signal) квантован по своим значениям и дискретен по аргументу. Он описывается квантованной решетчатой функцией yn = Qk[y(nDt)], где Qk - функция квантования с числом уровней квантования k, при этом интервалы квантования могут быть как с равномерным распределением, так и с неравномерным, например - логарифмическим. Задается цифровой сигнал, как правило, в виде дискретного ряда (discrete series) числовых данных - числового массива по последовательным значениям аргумента при Dt = const, но в общем случае сигнал может задаваться и в виде таблицы для произвольных значений аргумента.

По существу, цифровой сигнал по своим значениям (отсчетам) является формализованной разновидностью дискретного сигнала при округлении отсчетов последнего до определенного количества цифр, как это показано на рис 1.2.3. Цифровой сигнал конечен по множеству своих значений. Процесс преобразования бесконечных по значениям аналоговых отсчетов в конечное число цифровых значений называется квантованием по уровню, а возникающие при квантовании ошибки округления отсчетов (отбрасываемые значения) – шумами (noise) или ошибками (error) квантования (quantization).

В дискретных системах и в ЭВМ сигнал всегда представлен с точностью до определенного количества разрядов, а, следовательно, всегда является цифровым. С учетом этих факторов при описании цифровых сигналов функция квантования обычно опускается (подразумевается равномерной по умолчанию), а для описания сигналов используются правила описания дискретных сигналов. Что касается формы обращения цифровых сигналов в системах хранения, передачи и обработки, то, как правило, они представляет собой комбинации коротких одно- или двуполярных импульсов одинаковой амплитуды, которыми в двоичном коде с определенным количеством числовых разрядов кодируются числовые последовательности сигналов (массивов данных).

Рис. 1.2.4. Дискретно-аналоговый сигнал

Рис. 1.2.4. Дискретно-аналоговый сигнал

|

В принципе, квантованными по своим значениям могут быть и аналоговые сигналы, зарегистрированные соответствующей аппаратурой (рис. 1.2.4), которые принято называть дискретно-аналоговыми. Но выделять эти сигналы в отдельный тип не имеет смысла - они остаются аналоговыми кусочно-непрерывными сигналами с шагом квантования, который определяется допустимой погрешностью измерений.

Большинство дискретных и цифровых сигналов, с которыми приходится иметь дело при обработке геофизических данных, являются аналоговыми по своей природе, дискретизированными в силу методических особенностей измерений или технических особенностей регистрации. Но существуют и сигналы, которые изначально относятся к классу цифровых, как, например отсчеты количества гамма-квантов, зарегистрированных по последовательным интервалам времени.

Преобразования типа сигналов. Формы математического отображения сигналов, особенно на этапах их первичной регистрации (детектирования) и в прямых задачах описания геофизических полей и физических процессов, как правило, отражают их физическую природу. Однако последнее не является обязательным и зависит от методики измерений и технических средств детектирования, преобразования, передачи, хранения и обработки сигналов. На разных этапах процессов получения и обработки информации как материальное представление сигналов в устройствах регистрации и обработки, так и формы их математического описания при анализе данных, могут изменяться путем соответствующих операций преобразования типа сигналов.

Операция дискретизации (discretization) осуществляет преобразование аналоговых сигналов (функций), непрерывных по аргументу, в функции мгновенных значений сигналов по дискретному аргументу, как, например s(t) Þ s(nDt), где значения s(nDt) представляют собой отсчеты функции s(t) в моменты времени t = nDt, n = 0,1,2,...N.

Операция восстановления аналогового сигнала из его дискретного представления обратна операции дискретизации и представляет, по существу, интерполяцию данных.

В общем случае, дискретизация сигналов может приводить к определенной потере информации о поведении сигналов в промежутках между отсчетами. Однако существуют условия, определенные теоремой Котельникова-Шеннона, согласно которым аналоговый сигнал с ограниченным частотным спектром может быть без потерь информации преобразован в дискретный сигнал, и затем абсолютно точно восстановлен по значениям своих дискретных отсчетов.

Операция квантования или аналого-цифрового преобразования (АЦП; английский термин Analog-to-Digital Converter, ADC) заключается в преобразовании дискретного сигнала s(nDt) в цифровой сигнал s(n) = sn » s(nDt), n = 0,1,2,..,N, как правило, кодированный в двоичной системе счисления. Процесс преобразования отсчетов сигнала в числа называется квантованием по уровню (quantization), а возникающие при этом потери информации за счет округления – ошибками или шумами квантования (quantization error, quantization noise).

При преобразовании аналогового сигнала непосредственно в цифровой сигнал операции дискретизации и квантования совмещаются.

Операция цифро-аналогового преобразования (ЦАП; Digital-to-Analog Converter, DAC) обратна операции квантования, при этом на выходе регистрируется либо дискретно-аналоговый сигнал s(nDt), который имеет ступенчатую форму (рис. 1.2.4), либо непосредственно аналоговый сигнал s(t), который восстанавливается из s(nDt), например, путем сглаживания.

Так как квантование сигналов всегда выполняется с определенной и неустранимой погрешностью (максимум - до половины интервала квантования), то операции АЦП и ЦАП не являются взаимно обратными с абсолютной точностью.

Спектральное представление сигналов. Кроме привычного динамического представления сигналов и функций в виде зависимости их значений от определенных аргументов (времени, линейной или пространственной координаты и т.п.) при анализе и обработке данных широко используется математическое описание сигналов по аргументам, обратным аргументам динамического представления. Так, например, для времени обратным аргументом является частота. Возможность такого описания определяется тем, что любой сколь угодно сложный по своей форме сигнал, не имеющий разрывов первого рода (бесконечных значений на интервале своего задания), можно представить в виде суммы более простых сигналов, и, в частности, в виде суммы простейших гармонических колебаний, что выполняется при помощи преобразования Фурье. Соответственно, математически разложение сигнала на гармонические составляющие описывается функциями значений амплитуд и начальных фаз колебаний по непрерывному или дискретному аргументу – частоте изменения функций на определенных интервалах аргументов их динамического представления. Совокупность амплитуд гармонических колебаний разложения называют амплитудным спектром сигнала, а совокупность начальных фаз – фазовым спектром. Оба спектра вместе образуют полный частотный спектр сигнала, который по точности математического представления тождественен динамической форме описания сигнала.

Линейные системы преобразования сигналов описываются дифференциальными уравнениями, причем для них верен принцип суперпозиции, согласно которому реакция систем на сложный сигнал, состоящий из суммы простых сигналов, равна сумме реакций от каждого составляющего сигнала в отдельности. Это позволяет при известной реакции системы на гармоническое колебание с определенной частотой определить реакцию системы на любой сложный сигнал, разложив его в ряд гармоник по частотному спектру сигнала.

Широкое использование гармонических функций при анализе сигналов объясняется тем, что они являются достаточно простыми ортогональными функциями и определены при всех значениях t. Кроме того, они являются собственными функциями времени, сохраняющими свою форму при прохождении колебаний через любые линейные системы и системы обработки данных с постоянными параметрами (изменяются только амплитуда и фаза колебаний). Немаловажное значение имеет и то обстоятельство, что для гармонических функций и их комплексного анализа разработан мощный математический аппарат.

Примеры частотного представления сигналов уже приводились выше в разделе классификации сигналов (рис. 1.1.5 – 1.1.12)

Кроме гармонического ряда Фурье применяются и другие типы разложения: по функциям Уолша, Бесселя, Хаара, полиномам Чебышева, Лаггера, Лежандра и др.

Графическое отображение сигналов общеизвестно и особых пояснений не требует. Для одномерных сигналов график – это совокупность пар значений {t, s(t)} в прямоугольной системе координат (рис. 1.2.1 – 1.2.4). При графическом отображении дискретных и цифровых сигналов используется либо способ непосредственных дискретных отрезков соответствующей масштабной длины над осью аргумента, либо способ огибающей (плавной или ломанной) по значениям отсчетов. В силу непрерывности геофизических полей и, как правило, вторичности цифровых данных, получаемых дискретизацией и квантованием аналоговых сигналов, второй способ графического отображения будем считать основным.

Тестовые сигналы (test signal). В качестве тестовых сигналов, которые применяются при моделировании и исследовании систем обработки данных, обычно используются сигналы простейшего типа: гармонические синус-косинусные функции, дельта-функция и функция единичного скачка.

Дельта-функция или функция Дирака. По определению, дельта-функция описывается следующими математическими выражениями (в совокупности):

d(t-t) = 0 при t ¹ t,

d(t-t) dt = 1.

d(t-t) dt = 1.

Функция d(t-t) не является дифференцируемой, и имеет размерность, обратную размерности ее аргумента, что непосредственно следует из безразмерности результата интегрирования. Значение дельта-функции равно нулю везде за исключением точки t, где она представляет собой бесконечно узкий импульс с бесконечно большой амплитудой, при этом площадь импульса равна 1.

Дельта-функция является полезной математической абстракцией. На практике такие функции не могут быть реализованы с абсолютной точностью, так как невозможно реализовать значение, равное бесконечности, в точке t = t на аналоговой временной шкале, т.е. определенной по времени также с бесконечной точностью. Но во всех случаях, когда площадь импульса равна 1, длительность импульса достаточно мала, а за время его действия на входе какой-либо системы сигнал на ее выходе практически не изменяется (реакция системы на импульс во много раз больше длительности самого импульса), входной сигнал можно считать единичной импульсной функцией со свойствами дельта - функции.

При всей своей абстрактности дельта - функция имеет вполне определенный физический смысл. Представим себе импульсный сигнал прямоугольной формы П(t-t) длительностью q, амплитуда которого равна 1/q, а площадь соответственно равна 1. При уменьшении значения длительности q импульс, сокращаясь по длительности, сохраняет свою площадь, равную 1, и возрастает по амплитуде. Предел такой операции при q Þ 0 и носит название дельта - импульса. Этот сигнал d(t-t) сосредоточен в одной координатной точке t = t, конкретное амплитудное значение сигнала не определено, но площадь (интеграл) остается равной 1. Это не мгновенное значение функции в точке t = t, а именно импульс (импульс силы в механике, импульс тока в электротехнике и т.п.) – математическая модель короткого действия, значение которого равно 1.

Дельта-функция обладает фильтрующим свойством. Суть его заключается в том, что если дельта-функция d(t-t) входит под интеграл какой-либо функции в качестве множителя, то результат интегрирования равен значению подынтегральной функции в точке t расположения дельта-импульса, т.е.:

f(t) d(t-t) dt = f(t).

f(t) d(t-t) dt = f(t).

Интегрирование в этом выражении может ограничиваться ближайшими окрестностями точки t.

Функция единичного скачка или функция Хевисайда иногда называется также функцией включения. Полное математическое выражение функции:

При моделировании сигналов и систем значение функции скачка в точке t=0 очень часто принимают равным 1, если это не имеет принципиального значения.

Функция единичного скачка используется также при создании математических моделей сигналов конечной длительности. При умножении любой произвольной функции, в том числе периодической, на прямоугольный импульс, сформированный из двух последовательных функций единичного скачка

s(t) = s(t) - s(t-T),

из нее вырезается участок на интервале 0-Т, и обнуляются значения функции за пределами этого интервала.

Функция Кронекера. Для дискретных и цифровых систем разрешающая способность по аргументу сигнала определяется интервалом его дискретизации Dt. Это позволяет в качестве единичного импульса использовать дискретный интегральный аналог дельта-функции - функцию единичного отсчета d(kDt-nDt), которая равна 1 в координатной точке k = n, и нулю во всех остальных точках. Функция d(kDt-nDt) может быть определена для любых значений Dt = const, но только для целых значений координат k и n, поскольку других номеров отсчетов в дискретных функциях не существует.

Математические выражения d(t-t) и d(kDt-nDt) называют также импульсами Дирака и Кронекера. Однако, применяя такую терминологию, не будем забывать, что это не просто единичные импульсы в координатных точках t и nDt, а импульсные функции, определяющие как значения импульсов в определенных координатных точках, так и нулевые значения по всем остальным координатам, в пределе от -¥ до ¥.

1.3. Системы преобразования сигналов [1,9,14,18]

Сигналы, в любой форме материального представления, содержат определенную полезную информацию. Если при преобразованиях сигналов происходит нарушение заключенной в них информации (частичная утрата, количественное изменение содержания и т.п.), то такие изменения называются искажениями сигнала. Если полезная информация остается постоянной, то такие изменения называются преобразованиями сигнала.

Любые изменения сигналов сопровождаются изменением их спектра, и по характеру этого изменения разделяются на два вида: линейные и нелинейные. К нелинейным относят изменения, при которых в составе спектра сигналов появляются новые гармонические составляющие. При линейных изменениях сигналов изменяются амплитуды и/или начальные фазы гармонических составляющих спектра. И линейные, и нелинейные изменения сигналов могут происходить как с сохранением полезной информации, так и с ее искажением. Это зависит не только от характера изменения спектра сигналов, но и от спектрального состава самой полезной информации.

Общее понятие систем.Преобразование и обработка сигналов осуществляется в системах. Понятия сигнала и системы неразрывны, так как любой сигнал существует в пределах какой-либо системы. Система обработки сигналов может быть реализована как в материальной форме (специальное устройство, измерительный прибор, совокупность физических объектов с определенной структурой взаимодействия и т.п.), так и программно на ЭВМ или любом другом специализированном вычислительном устройстве. Форма реализации системы существенного значения не имеет, и определяет только ее возможности при анализе и обработке сигналов.

Рис. 1.3.1. Графическое представление системы.

Рис. 1.3.1. Графическое представление системы.

|

Безотносительно к назначению система всегда имеет вход, на который подается внешний входной сигнал, в общем случае многомерный, и выход, с которого снимается обработанный выходной сигнал. Если устройство системы и внутренние операции сигнальных преобразований принципиального значения не имеют, то система в целом может восприниматься в формализованной форме “черного ящика”.

Формализованная система представляет собой системный оператор (алгоритм) преобразования входного сигнала s(t) – воздействия или возбуждения, в сигнал на выходе системы y(t) – отклик или выходную реакцию системы. Символическое обозначение операции преобразования (трансформации сигнала): y(t) = T[s(t)].

Системный оператор T - это набор правил преобразования (transformation) сигнала s(t) в сигнал y(t). Так, например, в самом простейшем случае таким правилом может быть таблица перекодировки входных сигналов в выходные. Для общеизвестных операций преобразования сигналов применяются двухсимвольные индексы операторов трансформации, где вторым символом обозначается конкретный вид операции (например, TF- преобразование Фурье).

Входной сигнал системы может представлять собой m - мерный вектор, а выходной сигнал n - мерный вектор, при этом система будет иметь m входов и n выходов. Пример такой системы в геофизике: трехканальный гамма-спектрометр, на три входа решающего блока которого поступают потоки сигналов от калиевого, радиевого и ториевого каналов амплитудного анализатора спектрометра, а на три выхода решающего блока подаются результаты количественной интерпретации входной информации - сигналы количественных содержаний калия, урана и тория, при этом системный оператор реализует алгоритм решения системы трех линейных уравнений с тремя неизвестными.

Для детерминированных входных сигналов соотношение между выходными и входными сигналами всегда однозначно задается системным оператором. В случае реализации на входе системы случайного входного процесса аналогично существует однозначное соответствие процессов на выходе и входе системы, однако при этом одновременно происходит изменение статистических характеристик сигнала (математического ожидания, дисперсии, корреляционной функции и пр.), которое также определяется системным оператором.

Для полного определения системы необходимо задание характера, типа и области допустимых величин входных и выходных сигналов. Как правило, системы выполняются на сигналы одного типа по входу/выходу, и подразделяются на системы непрерывного времени (аналоговые или дискретные сигналы на входе и выходе) и цифровые системы. Совокупность системного оператора Т и областей входных/выходных сигналов образует математическую модель системы.

Линейные и нелинейные системы составляют два основных класса систем обработки сигналов. Термин линейности (linear) означает, что система преобразования сигналов должна иметь произвольную, но в обязательном порядке линейную связь между входным сигналом (возбуждением) и выходным сигналом (откликом) с определенным изменением спектрального состава входного сигнала (усиление или подавление определенных частотных составляющих сигнала). В нелинейных (nonlinear) системах связь между входным и выходным сигналом определяется произвольным нелинейным законом с дополнением частотного состава входного сигнала частотными составляющими, отсутствующими во входном сигнале.

Математически связь между аналоговыми сигналами входа s(t) и выхода y(t) в линейной системе обычно задается линейным дифференциальным уравнением:

am

am =

= bn

bn . (1.3.1)

. (1.3.1)

где am и bn – параметрические коэффициенты системы. Максимальный порядок производной входного сигнала в уравнении (1.3.1) не превышает порядка производной выходного сигнала, т.е. m ≤ n. Значение m называется порядком системы. При нормировке уравнения к ао = 1 получаем неоднородное линейное дифференциальное уравнение для произвольного входного сигнала s(t), решение которого дает выходной сигнал y(t):

y(t) = bn

bn –

– am

am . (1.3.1')

. (1.3.1')

Аналогичная связь выхода с входом в дискретной (цифровой) системе описывается разностными уравнениями:

am y((k-m)Dt) =

am y((k-m)Dt) = bn s((k-n)Dt). (1.3.2)

bn s((k-n)Dt). (1.3.2)

y(kDt) = bn s((k-n)Dt) –

bn s((k-n)Dt) – am y((k-m)Dt). (1.3.2')

am y((k-m)Dt). (1.3.2')

Уравнение (1.3.2') можно рассматривать как алгоритм последовательного вычисления значений y(kDt), k = 0,1,2, …, по значениям входного сигнала s(kDt) при известных значениях коэффициентов am, bn и задании определенных начальных условий s(-kDt), y(-kDt).

Стационарные и нестационарные системы. Система считается стационарной и имеет постоянные параметры, если ее свойства (математический алгоритм оператора преобразования) в пределах заданной точности не зависят от входного и выходного сигналов и не изменяются ни во времени, ни от каких-либо других внешних факторов. Математически это означает задание системы уравнениями типа (1.3.1-2) с постоянными значениями коэффициентов am и bn. В противном случае система является нестационарной и называется параметрической или системой с переменными параметрами. Среди последних большое значение имеют так называемые адаптивные системы обработки данных. В этих системах производится, например, оценивание определенных параметров входных и выходных сигналов, по результатам сравнения которых осуществляется подстройка параметров преобразования (переходной характеристики системы) таким образом, чтобы обеспечить оптимальные по производительности условия обработки сигналов или минимизировать погрешность обработки.

Основные системные операции. К базовым линейным операциям, из которых могут быть сформированы любые линейные операторы преобразования, относятся операции скалярного умножения, сдвига и сложения сигналов:

y(t) = c ´ s(t), y(t) = s(t-Dt), y(t) = a(t)+b(t).

Отметим, что строго корректно операции сложения и умножения являются линейными только для аналоговых и дискретных сигналов. В случае цифровых сигналов они линейны относительно самих цифровых сигналов, но если последние - результат операции АЦП, то сложение и умножение не может считаться линейным абсолютно точно по отношению к исходным сигналам.

Для нелинейных систем выделим важный тип безинерционных операций нелинейной трансформации сигнала, результаты которой зависят только от его входных значений. К ним относятся, например, операции квадратирования и логарифмирования сигнала:

y(t) = [s(t)]2, y(t) = log[s(t)].

Линейные системы.Система считается линейной, если ее реакция на входные сигналы аддитивна (выполняется принцип суперпозиции сигналов) и однородна (выполняется принцип пропорционального подобия).

Принцип аддитивности требует, чтобы реакция системы на сумму входных сигналов была равна сумме реакций на каждый сигнал в отдельности. Так, для двух сигналов должно иметь место:

T[a(t)+b(t)] = T[a(t)]+T[b(t)].

Принцип однородности или пропорционального подобия требует сохранения однозначности масштаба преобразования при любой амплитуде входного сигнала:

T[c ´ s(t)] = c ´ T[s(t)].

Другими словами, отклик линейной системы на взвешенную сумму входных сигналов должен быть равен взвешенной сумме откликов на отдельные входные сигналы независимо от их количества и для любых весовых коэффициентов, в том числе комплексных.

Примеры.

1. Система y(t) = a2t.

y(t1) = a2t1, y(t2) = a2t2, y(ct) = a2ct.

y(t1+t2) = a2(t1+t2) = a2t1+a2t2 = y(t1)+y(t2). Система аддитивна.

cy(t) = ca2t = a2ct = y(сt). Система однородна. Следовательно, система линейна.

2. Система y(t) = a·t2.

y(t1)= at12, y(t2)= at22, y(ct)= a(ct)2= ac2t2.

y(t1+t2)= a(t1+t2)2 ¹ y(t1)+y(t2)= at12+at22. Система не аддитивна.

y(t) = с at2 ¹ y(сt) = ac2t2. Система неоднородна. Следовательно, система нелинейна.

При программной реализации линейных систем на ЭВМ особых затруднений с обеспечением линейности в разумных пределах значений входных и выходных сигналов, как правило, не возникает. При физической (аппаратной) реализации систем обработки данных диапазон входных и/или выходных сигналов, в котором обеспечивается линейность преобразования сигналов, всегда ограничен и должен быть специально оговорен в технической документации или методической инструкции.

Инвариантность систем к сдвигу. Система называется инвариантной к сдвигу, если сдвиг входного сигнала по аргументам (времени, координатам пространства и т.п.) вызывает соответствующий сдвиг выходного сигнала:

y(x,t) = T[s(x,t)], T[s(x-Dx,t-Dt)] = y(x-Dx,t-Dt).

Инвариантность системы к сдвигу является одним из подтверждений постоянства ее параметров.

Линейные системы, инвариантные к сдвигу. Линейность и инвариантность к сдвигу являются независимыми свойствами систем и не определяют друг друга. Так, например, операция квадратирования сигнала инвариантна к сдвигу, но нелинейна.

В теории анализа и обработки данных основное место занимают системы, линейные и инвариантные к сдвигу (ЛИС - системы). Они обладают достаточно широкими практическими возможностями при относительной простоте математического аппарата. В дальнейшем, если это специально не оговаривается, будем иметь в виду именно такие системы.

Преимущество, которое отдается ЛИС - системам в методах обработки информации, базируется на возможности разложения входного сигнала любой, сколь угодно сложной формы, на составляющие простейших форм, отклик системы на которые известен и хорошо изучен, с последующим вычислением выходного сигнала в виде суммы откликов на все составляющие входного сигнала. В качестве простейших форм разложения сигналов используются, как правило, единичные импульсы и гармонические составляющие. Разложение по единичным импульсам применяется при динамическом представлении сигнала в зависимости от реальных физических аргументов (времени, координат и пр.) и использует операцию свертки. Разложение на гармонические составляющие использует спектральное (частотное) представление сигнала и преобразование Фурье.

Рис. 1.3.2 Соединения систем.

Рис. 1.3.2 Соединения систем.

|

Соединения ЛИС - систем.При последовательном (каскадном) соединении систем выходной сигнал одной системы служит входным сигналом для второй и т.д. в зависимости от количества составляющих систем каскада. По отношению к общей системной операции преобразования порядок соединения входящих в нее систем значения не имеет. Так, для двух последовательно соединенных систем на рис. 1.3.2:

y(t) = T2[T1[s(t)]] = T1[T2[s(t)]].

При параллельном соединении входной сигнал поступает одновременно на входы всех составляющих систем, а выходные сигналы систем суммируются:

y(t) = T1[s(t)] + T2[s(t)] + ... + TN[s(t)].

Образуемые в результате соединений системы в целом также являются ЛИС - системами, если линейны и инвариантны к сдвигу системы, в них входящие.

Обобщенная схема системы цифровой обработки сигналов на рис. 1.3.3 приведена в качестве примера.

Рис. 1.3.3. Структурная схема системы дифференцирования сигналов.

1.4. информационная емкость сигналов [10,12,28]

Объем информации, находящейся в обращении и необходимой для функционирования и развития современного общества, нарастает примерно пропорционально квадрату развития производительных сил. В передовых по научно-техническому развитию странах мира доля рабочей силы, занятой вопросами сбора, обработки и обеспечения информацией, превышает долю рабочей силы в сфере материального производства. Применение методов и средств автоматизации на всех этапах обращения информации, эффективная организация ее хранения, обработки и обмена, приобретают все большее значение в качестве основного условия успешного функционирования экономики стран.

Понятие информации.В настоящее время нет общепринятого и однозначного понимания термина "Информация". Спектр бытующих понятий весьма широк, от общего философского - информация есть отражение реального мира, до узко практического - информация есть сведения, являющиеся объектом хранения, передачи и преобразования. Расхождения существуют и по вопросу места информации в материальном мире. Это свойство индивидуальных объектов или результат их взаимодействия? Присуща ли информация всем видам материи или лишь определенным образом организованной материи?

В информатике под информацией понимается, как правило, совокупность сведений смыслового содержания, которые можно собирать, обрабатывать, передавать и т.п. Причем именно сведений в изначальном смысле латинского слова informatio, а не данных или сигналов, которые являются носителями этих сведений. В таком понимании процессы извлечения сведений из данных и их интерпретации неразрывно связаны с разумом, а конечным результатом обработки и восприятия информации с помощью разума является раскрытие неопределенности знаний о каком-либо объекте, явлении или процессе. Но при таком подходе размывается само понятие разума.

С одной стороны, существование любого живого существа поддерживается до тех пор, пока действуют его органы чувств (датчики), преобразующие физические воздействия окружающего мира в определенным образом организованные сигналы, которые в материальной форме отображают данные об этих воздействиях. Данные собираются и интерпретируются определенной системой, из общей суммы данных извлекаются определенные сведения, степень неопределенности сведений об окружающей обстановке снижается, и ... лиса распутывает заячий след. Живое существо существует до тех пор, пока способно воспринимать и обрабатывать внешние и внутренние воздействия. Нет сомнений и в том, что в коллективных сообществах его члены не только способны собирать и обрабатывать информацию, но и передавать ее другим членам сообщества, как, например, в пчелиной семье точный путь до продуктивного цветочного массива. Информационный танец пчелы в этом отношении по компактности содержания ничем не уступает телеграфному сообщению. Естественно, в принятой у пчел символьной форме.

С другой стороны, если информация неразрывно связана с разумом, то в этом случае нельзя отказать в разуме и электронной вычислительной машине, обыгрывающей в шахматы чемпиона мира, а равно и любым устройствам технической кибернетики любого уровня, так как все они имеют определенные системы сбора, передачи, накопления, хранения и обработки информации той или иной степени сложности, и на основе этой информации способны формировать сигналы обратной связи для управления определенными процессами.

В технических отраслях знаний, где вопросы соотношения информации с разумом не стоят на первом месте, преобладает понимание информации в виде отображения такого всеобщего свойства материи, как разнообразие, как характеристики внутренней организованности материальных систем, процессов или явлений по множеству состояний, которые для них возможны. В такой трактовке информация существует независимо от того, воспринимается она каким-либо "разумом" или нет, и является одним из свойств материальных объектов. "Информация есть информация, а не материя и не энергия" (Норберт Винер). Это свойство в какой-то мере имеет потенциальный характер. Информация может проявлять себя только при взаимодействии объектов или процессов, может возникать (создаваться) и исчезать (уничтожаться).

Но и в такой трактовке возникает очень много вопросов, на которые трудно дать однозначные ответы. Насекомое третичного периода, неизвестное в настоящее время ученым, прилипло к капле смолы хвойного дерева. Новый слой смолы закрыл насекомое. Дерево упало и его занесло песком. Смола превратилась в янтарь. Янтарь в потенциале содержит полную информацию о насекомом, потому как в нем десятки тысяч фрагментов ДНК - информация, достаточная для восстановления ДНК и воспроизводства насекомого, если не в настоящее время, то в ближайшем будущем. Но когда она возникла? В момент появления насекомого с его ДНК? В момент прилипания к смоле? В момент окаменения? Можно ли говорить о появлении информации, если еще не существовал субъект, способный извлечь и использовать эту информацию? Наконец, янтарь с насекомым найден и попал на глаза палеонтолога. Определен новый вид насекомого. Появилась первая частичная информация? Так может быть информация появляется только при активном и целенаправленном воздействии на объект исследований? А если янтарь оказался непрозрачным, и его переплавили? Исчезла ли информация? И можно ли считать, что она вообще была?

Ответы на эти и подобные им вопросы тяготеют к двум полюсам, а по существу, к двум диаметрально противоположным философским позициям.

Сторонники первой позиции считают, что информация присуща только определенным образом организованным объектам или процессам, и понимают под информацией только то, что может восприниматься, обрабатываться, осмысливаться и использоваться, т.е. является продуктом целенаправленного процесса сбора, организации, систематизации и использования сведений о материальных объектах и процессах.

Противоположная позиция, это понятие информации как свойства объектов и процессов воспринимать и перерабатывать внутреннее состояние и внешнее воздействие окружающей среды, сохранять его результаты и передавать их другим объектам. С этой позиции все материальные объекты и процессы являются источниками, носителями и потребителями информации, на основе которой и идет развитие реального мира. По существу, это соответствует принятию материальности информации и информационной основы мироздания.

При неопределенности самого понятия информации можно достаточно обоснованно считать, что информация проявляется, хранится и передается от одного объекта к другому в материально - энергетической форме в виде сигналов. Сигналом, как материальным носителем информации, может быть любой физический процесс (электрический, магнитный, оптический, акустический и пр.), определенные параметры которого (амплитуда, частота, энергия, интенсивность и др.) однозначно отображают информационные данные (сообщения).

Количественная мера информации.Теория любого явления начинается с появления количественных взаимоотношений между объектами исследований, т.е. при установлении принципов измеряемости каких-либо свойств объектов. Единицу количественной меры информации - БИТ (сокращение binary digit - двоичная цифра), впервые предложил Р. Хартли в 1928 году. 1 бит - это информация о двух возможных равновероятных состояниях объекта, неопределенность выбора из двух равновероятных событий. Математически это отображается состоянием 1 или 0 одного разряда двоичной системы счисления. Количество информации Н (в битах), необходимое и достаточное для полного снятия неопределенности состояния объекта, который имеет N равновозможных состояний, измеряется как логарифм по основанию 2 из числа возможных состояний:

H = log 2 N. (1.4.1)

Соответственно, двоичный числовой информационный код одного из N возможных состояний объекта занимает Н двоичных разрядов.

Пример. Необходимо поднять груз на определенный этаж 16 -ти этажного здания (нумерация этажей 0-15, N = 16). Сколько бит информации полностью определяют задание?

H = log2 N = log2 16 = 4.

Следовательно, 4 бита информации должны быть необходимы и достаточны для полного снятия неопределенности выбора. В этом можно убедиться применением логики исчисления с последовательным делением пополам интервалов состояний. Например, для 9-го этажа:

1. Выше 7-го этажа? Да = 1. 2. Выше 11-го этажа? Нет = 0.

3. Выше 9-го этажа? Нет = 0. 4. Выше 8-го этажа? Да = 1.

Итог: этаж номер 9 или 1001 в двоичном исчислении, четыре двоичных разряда.

Если в приведенном примере на этажах имеется по 4 квартиры с нумерацией на каждом этаже 0-3 (М=4), то при адресации груза в квартиру потребуется еще 2 бита информации. Такой же результат получим, если вместо независимой нумерации этажей и квартир на этажах (два источника неопределенности) мы будем иметь только сквозную нумерацию квартир (один обобщенный источник):

H = log 2 N + log 2 M = log 2 16 + log 2 4 = 6 º log 2 (N ´ M) = log 2 64 = 6,

т.е. количество информации отвечает требованию аддитивности: неопределенность объединенного источника равна сумме неопределенностей исходных источников, что соответствует интуитивному требованию к информации: она должна быть однозначной, а ее количество должно быть одним и тем же независимо от способа задания.

Основание логарифма не имеет принципиального значения и определяет только масштаб или единицу неопределенности. Так, если за единицу неопределенности принять три равновероятных состояния, то для определения, например, одной фальшивой золотой монеты (более легкой) из 27 внешне неотличимых монет потребуется только H = log 3 27 = 3, т.е. три взвешивания на равноплечных весах. Логику исчисления взвешиваний предлагается определить самостоятельно.

Двоичная мера информации получила общее признание в связи с простотой реализации информационной техники на элементах с двумя устойчивыми состояниями. В десятичном исчислении единицей информации является один десятичный разряд - ДИТ.

Энтропия источника информации.Степень неопределенности состояния объекта (или так называемого источника информации) зависит не только от числа его возможных состояний, но и от вероятности этих состояний. При неравновероятных состояниях свобода выбора для источника ограничивается. Так, если из двух возможных состояний вероятность одного из них равна 0.999, то вероятность другого состояния соответственно равна 1-0.999 = 0.001 и при взаимодействии с таким источником результат практически предрешен.

В общем случае, в соответствии с теорией вероятностей, источник информации однозначно и полно характеризуется ансамблем состояний U = {u1, u2,..., uN} с вероятностями состояний соответственно {р(u1), р(u2),..., р(uN)} при условии, что сумма вероятностей всех состояний равна 1. Мера количества информации, как неопределенности выбора дискретным источником состояния из ансамбля U, предложена К. Шенноном в 1946 году и получила название энтропии дискретного источника информации или энтропии конечного ансамбля:

H(U) = - pn log2 pn. (1.4.2)

pn log2 pn. (1.4.2)

Выражение Шеннона совпадает с выражением Больцмана для энтропии физических систем при оценке степени разнообразия их состояний. Мера энтропии Шеннона является обобщением меры Хартли на случай ансамблей с неравновероятными состояниями, в чем нетрудно убедиться, если в выражении (1.4.2) значение pn заменить значением p=1/N для ансамбля равновероятных состояний. Энтропия конечного ансамбля H(U) характеризует неопределенность, приходящуюся в среднем на одно состояние ансамбля.