Взаимная информация и ее свойства. Условная энтропия.

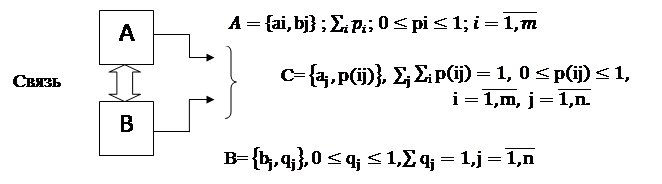

Рассмотрим два дискретных источника A и B. Объединим их события в пары (ai,bj) объединенной вероятностной схемой C=AB. Мы получим простейшую модель связанных источников (рис.1)

Рис. 1 – Модель двух связанных источников

Если два источника считать связанными друг с другом, то следует ожидать, что событие одного источника позволяют делать некоторые предположения о событиях другого. В терминах теории информации это означает, что неопределенность второго источника снижается, т.е. источники обмениваются взаимной информацией.

Для совместных событий известно, что

Или в обозначениях x:

p(ij)=pipij=qjpji

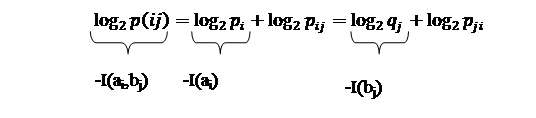

Прологарифмируем данное выражение:

|

Где  - совместная информация объединенной вероятностной схемы C=AB или собственная информация пары событий.

- совместная информация объединенной вероятностной схемы C=AB или собственная информация пары событий.

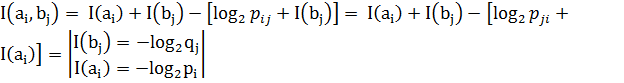

Тогда

Прибавляя и одновременно вычитая  а первой части равенства, а

а первой части равенства, а

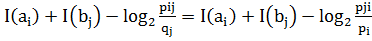

=

= .

.

Таким образом, собственная информация  пары событий

пары событий  определяется суммой собственных информаций

определяется суммой собственных информаций  этих событий за вычетом некоторой неотрицательной величины, которая снижает неопределенность, т.е. она сама в свою очередь является информацией. Эту величину называют взаимной информацией пары событий:

этих событий за вычетом некоторой неотрицательной величины, которая снижает неопределенность, т.е. она сама в свою очередь является информацией. Эту величину называют взаимной информацией пары событий:

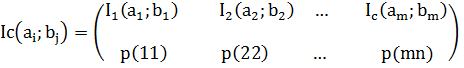

Для объединенной вероятностной схемы C=AB можно записать:

,

,

также случайная величина, тогда математическое ожидание этой случайной величины E будет равно:

также случайная величина, тогда математическое ожидание этой случайной величины E будет равно:

Ic(A;B)=

Ic(A;B) – взаимная информация сообщения C (или объединенной вероятностной схемы)