рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Философия

- /

- Дисциплина Теория информации Тема №2: Меры информации

Реферат Курсовая Конспект

Дисциплина Теория информации Тема №2: Меры информации

Дисциплина Теория информации Тема №2: Меры информации - раздел Философия, Министерство Образования И Науки Рф Тамбовский Государственный Техни...

Министерство образования и науки РФ

Тамбовский государственный технический университет

Кафедра Информационные системы

Дисциплина Теория информации

Тема №2: Меры информации

Лекции №№2;3

специальность 230201 «Информационные системы и технологии»

3 курс

Преподаватель: проф. Дидрих Валерий Евгеньевич

Тамбов 2010

Тема №2: Меры информации

Классификация мер информации.

В зависимости от направлений исследований теории информации различают её меры, а именно:

- структурные;

- синтаксические (стратегические характеристики сообщений, источников и каналов);

- семантические (содержание информации);

- прагматические (практическая ценность информации, ее полезность)

Последние два направления теории и соответствующие меры нас будут интересовать в меньшей степени, поэтому ограничимся лишь общим представлением:

Прагматическая мера информации определяет полезность (ценность) для достижения пользователем поставленных целей. Примеры:

- емкость памяти;

- производительность ПК;

- скорость передачи данных;

- стоимость вычислительного процесса и др.

Семантическая мера основывается на понятии содержательности информации, единицей измерения которой является тезаурус (совокупность сведений, которыми располагает пользователь или система).

Структурная мера информации определяется подходом к оценке особенностей структуры сообщений. Среди структурных мер различают:

- геометрическую;

- комбинаторную;

- аддитивную меру Хартли.

Геометрической мерой определяется потенциальное (максимально возможное) количество информации в заданной структуре сообщения. Это количество информации называют информационной емкостью исследуемой части ИС.

Информационным элементом в геометрической мере является квант как неделимая часть информации.

Информационная емкость может быть представлена числом, показывающим, какое количество квантов содержится в полном массиве информации.

Пусть информация отражается полным комплексом XTN. Если дискретные отсчеты осуществляются по осям X, T и N соответственно через интервалы ∆X, ∆T и ∆N, то непрерывные координаты распадаются на элементы (кванты), количество которых составляет:

,

,  ,

,  ;

;

Тогда количество информации в полном комплексе XTN в геометрической мере в квантах:

M=mX∙mT∙mN

К комбинаторной мере целесообразно прибегать тогда, когда требуется оценить возможности передачи информации при помощи различных комбинаций информационных элементов.

Количество информации в комбинаторной мере вычисляется как количество комбинаций элементов. Образование комбинаций в структуре информационных элементов есть одна из форм кодирования информации.

С помощью комбинаторных мер оценке подвергается комбинаторное свойство потенциального структурного разнообразия информационных комплексов.

Комбинирование элементов в информационных комплексах базируется на основных понятиях комбинаторики:

- сочетания (комбинации различаются только составом элементов);

, где сочетания из h элементов по l без повторений

, где сочетания из h элементов по l без повторений

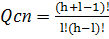

, с повторениями

, с повторениями

- перестановки (комбинации различаются только порядком элементов);

, где h – число элементов (без повторений);

, где h – число элементов (без повторений);

Qпп= , где α, β, γ – количество повторений некоторых элементов комбинации

, где α, β, γ – количество повторений некоторых элементов комбинации

- размещение (комбинации различаются как составом, так и порядком элементов);

, где размещение из h по l элементов без повторений

, где размещение из h по l элементов без повторений

, с повторениями

, с повторениями

Комбинаторная мера информации – это число возможных комбинаций элементов информационного комплекса.

В отличие от геометрической меры, комбинаторная – это не просто подсчет квантов, а определение количества возможных или действительно осуществимых комбинаций элементов.

При этом количество информации при таком же количестве элементов многократно увеличивается.

Например, в случае сочетаний из 10 элементов по 0,1,2, …,9 получится следующее количество информации:

Перестановка тех же элементов дает:

Размещение из 10 элементов по 10 элементов дает

В прикладной теории информации для описания (представления) структуры информационного комплекса пользуются понятиями:

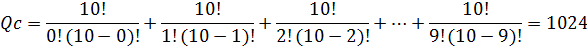

- Глубина h – это количество различных элементов (знаков), содержащихся в алфавите кодирования одного разряда. Полный алфавит занимает одно числовое гнездо, глубина которого h.

|

- Длина кода l – это количество числовых гнезд, т.е. количество повторений алфавита, необходимых и достаточных для представления чисел нужной величины (сообщений). Длина числа соответствует разрядности степени счисления и кодирования.

Наиболее часто используется h= 2; 8; 10; 16; … (двоичная, восьмеричная, шестнадцатеричная системы счисления)

l= 16; 32; 64; …. (16-ти, 32-х, 64-х разрядные коды (слова)).

В общем случае информационная емкость, т.е. количество информации такого информационного комплекса, определяется числом размещений из h по l с повторениями и равна:

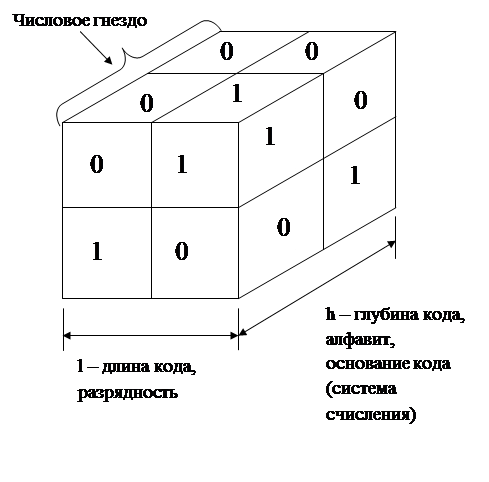

Для практического удобства использования этой меры информации Хартли ввел аддитивную логарифмическую меру, позволяющую вычислить количество информации в двоичных единицах – битах.

Мера информации по Хартли:

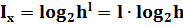

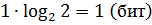

Отсюда, если число ограничить 1 разрядом (l=1) и принять двоичную систему счисления (h=2), т.е. использовать двоичный алфавит (1,0), то потенциально возможное количество информации равно 1 биту:

Т.е. один разряд двоичного числа (кода) несет информацию (точнее может нести), равную 1 биту. Это количество информации, заключенной в одном событии, которое может произойти или не произойти.

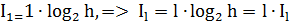

Аддитивность меры Хартли заключается в том, что она позволяет производить суммирование количества информации отдельных элементов информационного комплекса (по разрядам длины l кода).

Из формулы Хартли:

Синтаксическая мера информации определяется, как правило, вероятностными характеристиками элементами сообщения. Поэтому ее чаще называют статистической мерой.

Направление статистической теории информации дает оценки информационных систем в конкретных применениях, например при передаче по системе связи информации с определенными статистическими характеристиками.

В качестве меры информации используют понятие энтропии, как меры неопределенности, учитывающей вероятность появления данного события, а, следовательно, информативность тех или иных сообщений.

Повседневный опыт подсказывает, что часто происходящие события, так же как и их вероятности, дают нам мало информации. Возьмем, например, сообщение «собака укусила человека». Это привычное известие не привлекло бы к себе никакого внимания, в то время как сообщение «человек укусил собаку» все газеты напечатали бы крупным шрифтом.

Из этого можно сделать вывод: частые ожидаемые события несут мало информации и, наоборот, редкие, т.е. неожиданные события, обладают высоким информационным содержанием. Следовательно, информация и вероятность события находятся в обратно пропорциональной зависимости:

Энтропия вероятностной схемы. Основные свойства энтропии. Аксиомы Хинчина и Фадеева.

X =, с вероятностью P()= Выборка символов производятся независимо друг от друга.Аксиомы Хинчина

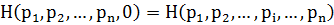

1. H(p1,…,pn) – ненулевая непрерывная по переменным p1,…,pn при условиях 0≤pi≤1, p1+…+,pn=1

2. H(p1,…,pn) – симметрична по переменным p1,…,pn

3.

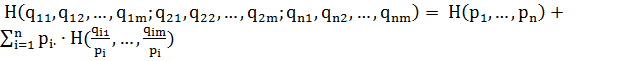

4. ,

,

где  ,

,

5.  , т.е. при равновероятных событиях:

, т.е. при равновероятных событиях:

Аксиомы Фадеева

1.’ – непрерывна при условиях:

– непрерывна при условиях:  и положительна хотя в одной точке.

и положительна хотя в одной точке.

2.’ - симметрична по p1,…,pn

- симметрична по p1,…,pn

3’. При

где

где  .

.

Это позволит в дальнейшем характеризовать производительность источника информации, оценивать возможности сжатия информации, получить формулу для вычисления пропускной способности дискретного канала связи.

Взаимная информация и ее свойства. Условная энтропия.

Свойства взаимной информации.

2. Взаимная информация симметрична относительно пары вероятностных схем A и B. I(А;B)=I(B;A) 3. Если сообщение A и B независимы (несовместны), то I(А;B)=0.Понятие совместной энтропии.

H(AB) = E– совместная энтропия двух дискретных источников Не сложно доказать, что H(AB)=H(A)+H(B/A)=H(B)+H(A/B)Характеристики пары источников дискретных сообщений

Замечание: Взаимная информация не имеет аналога в теории вероятности. Это совершенно новое понятие теории информации, играющее центральную роль в…– Конец работы –

Используемые теги: дисциплина, Теория, информации, Тема, меры, информации0.094

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ: Дисциплина Теория информации Тема №2: Меры информации

Что будем делать с полученным материалом:

Если этот материал оказался полезным для Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Хотите получать на электронную почту самые свежие новости?

Новости и инфо для студентов