Свойства взаимной информации.

1. Взаимная информация - величина положительная.

2. Взаимная информация симметрична относительно пары вероятностных схем A и B.

I(А;B)=I(B;A)

3. Если сообщение A и B независимы (несовместны), то I(А;B)=0.

Если сообщения A и B полностью зависимы, а именно совпадают (сообщения A и B содержат одну и ту же информацию), то

I(А;B)=I(A)+I(B)

Примеры, поясняющие это свойство:

1) Если A и B – сообщения, публикуемые различными источниками (газетами), то для получения возможно большей суммарной (совместной) информации взаимная (т.е. одинаковая в данном случае) информация, должна быть минимальной.

2) Если A и B – сообщения на входе и выходе канала связи с помехами, то для получения взаимно большей информации её получателем необходимо, чтобы взаимная информация была наибольшей.

В то же время для описания воздействия помех в канале связи на полезное сообщение используется понятие условной информации и условной энтропии.

Для определения условной информации и условной энтропии в заданной объединенной вероятностной схеме вернемся к соотношению:

=

= =

=

Таким образом, совместная информация пары событий

пары событий  информаций складывается из собственной информации каждого события

информаций складывается из собственной информации каждого события  или

или  и некоторой информации, добавляемой вторым событием при условии, что произошло первое, т.е.

и некоторой информации, добавляемой вторым событием при условии, что произошло первое, т.е.  I

I . Поэтому информацию

. Поэтому информацию I

I называют условной информацией пары случайных событий.

называют условной информацией пары случайных событий.

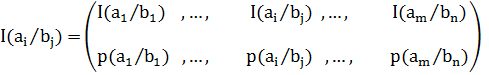

Если аналогично тому, как мы это делали ранее, составить вероятностную схему для условной вероятности пары событий как для случайной величины:

,

,

тогда математическое ожидание E, которое и является энтропией этой случайной величины  будет равно:

будет равно:

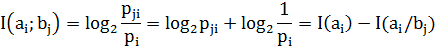

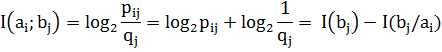

Найдем соотношение между условной энтропией объединенной вероятностной схемы и ее взаимной информации.

По определению взаимная информация пары событий равна

Аналогично:

Рассматривая взаимную информацию как случайную величину и, усредняя её (определяя математическое ожидание E) по объединенной вероятностной схеме, получим:

I(А;B) = E H(A) - H(A/B) = H(B) - H(B/A).

H(A) - H(A/B) = H(B) - H(B/A).