Понятие совместной энтропии.

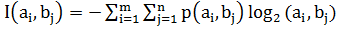

Для двух источников, образующих объединенную вероятностную схему, используя понятие совместной вероятности пары событий p(ai,bj), можно определить среднюю информацию всех пар событий:

H(AB) = E – совместная энтропия двух дискретных источников

– совместная энтропия двух дискретных источников

Не сложно доказать, что

H(AB)=H(A)+H(B/A)=H(B)+H(A/B)

Если источники независимы, справедливо:

H(A/B)=H(A), H(B/A)=H(B)., тогда очевидно, что для связанных источников

H(A/B) H(A); H(B/A)

H(A); H(B/A) H(B).

H(B).

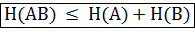

Поэтому в общем случае справедливо соотношение:

Сведем все проведенные рассуждения в единую таблицу характеристик пары дискретных источников: