Передача информации от дискретного источника.

Выясним, насколько будет изменяться неопределенность относительно состояния источника сообщения при получении адресатом элемента сообщения с выхода канала связи. Алфавиты передаваемых и принимаемых элементов сообщения считаем идентичными.

Вследствие воздействия помех полученный элемент сообщения в общем случае отличается от переданного. Подчеркнем это различие. Обозначив принимаемые элементы сообщения другими буквами: w1, ..., wi, ..., wn-

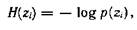

Априорная неопределенность (неопределенность до получения элемента сообщения) относительно состояния источника не является полной. Предполагается, что адресату известен алфавит элементов сообщения, а из прошлого опыта он знает вероятности их появления. Считая, что состояния источника реализуются независимо, априорная частная неопределенность появления элемента сообщения zi,

где p(zi) — априорная вероятность появления элемента сообщения zi.

Предполагаются также известными некоторые сведения относительно помехи в канале связи. Обычно считают, что между элементами сообщения и помехой статистические связи отсутствуют, искажения отдельных элементов сообщения являются событиями независимыми и адресату известна совокупность условных вероятностей p(zi/wj) (1£ i£ N, 1£ j£ N) того, что вместо элемента сообщения zi будет принят элемент сообщения wj.

При получении конкретного элемента сообщения wj адресату становится известным значение условной вероятности p(zi/wj), называемой апостериорной (послеопытной) вероятностью реализации источником элемента сообщения zi. Это позволяет найти апостериорную частную неопределенность, остающуюся у адресата относительно выдачи источников элемента сообщения zi после получения конкретного элемента сообщения wj.

H(zi/wj)=-log p(zi/wj)

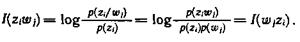

Поскольку получение информации мы связываем с уменьшением неопределенности, естественно определить частное количество информации I(zi), получаемое при приеме элемента сообщения wj относительно некоторого реализованного источником элемента сообщения zi как разность частных неопределенностей, имевшихся у адресата до и после получения элемента сообщения (априорной и апостериорной):

I(zi) = H(zi) – H(zi/wj) =

Анализ формулы позволяет сделать следующие заключения:

1) частное количество информации растет с уменьшением априорной и увеличением апостериорной вероятностей реализации элемента сообщения источником, что находится в полном соответствии с нашими интуитивными представлениями;

2) частное количество информации об элементе сообщения zi может быть не только положительным, но и отрицательным, а также нулем, что зависит от соотношения априорной p(zi) и апостериорной p(zi/wj) вероятностей. Если вероятность того, что источником был реализован элемент сообщения zi,- увеличилась после приема элемента сообщения wj т. е. p(zi/wj) > p(zi), то полученное частное количество информации положительно. Если эта вероятность не изменилась, т. е. p(zi/wj) = p(zi), то имевшая место неопределенность тоже не изменилась и частное количество информации равно нулю.

Наконец, случай p(zi/wj) < p(zi) соответствует увеличению неопределенности относительно реализации zi после получения элемента сообщения wj, и, следовательно, частное количество информации отрицательно;

3) в случае отсутствия помехи апостериорная вероятность p(zi/wj) = 1. При этом частное количество информации численно совпадает с частной априорной неопределенностью реализации данного элемента сообщения zi:

I(zi) =H(zi)=-log p(zi)

Это максимальное частное количество информации, которое можно получить об элементе сообщения zi;

4) частное количество информации относительно реализации источником элемента сообщения zi, содержащееся в принятом элементе сообщения wj, равно частному количеству информации относительно wj, содержащемуся в элементе сообщения zi

Хотя имеют место случаи, где важно оценить частное количество информации I(zi wj), для задач анализа и оптимизации функционирования информационных систем более рациональны усредненные характеристики, отражающие статистические свойства источника информации и канала связи.

Найдем среднее количество информации, содержащееся в любом принятом элементе сообщения относительно переданного (реализованного) источником. До получения конкретного элемента сообщения средняя неопределенность, имеющаяся у адресата, относительно реализации источником любого элемента сообщения равна энтропии источника. Ее называют априорной энтропией источника.

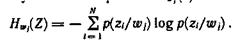

Средняя неопределенность относительно любого состояния источника, остающаяся у адресата после получения конкретного элемента сообщения wj, характеризуется частной условной энтропией Hwj(z):

Это случайная величина, зависящая от того, какой конкретно элемент сообщения принят.

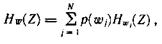

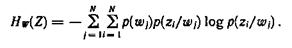

Средняя неопределенность по всему ансамблю принимаемых элементов сообщений равна условной энтропии источника Hw(Z):

или

Эту условную энтропию называют апостериорной энтропией источника информации.

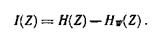

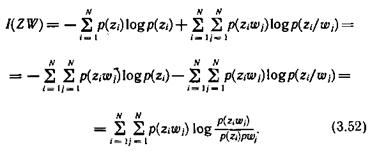

Таким образом, при наличии помех среднее количество информации, содержащееся в каждом принятом элементе сообщения, относительно любого переданного равно разности априорной и апостериорной энтропии источника:

Представив априорную и апостериорную энтропии соответственно выражениями (3.6) и (3.50) и проведя несложные преобразования, получим формулу для количества информации непосредственно через вероятности:

Если частный характер количества информации специально не оговаривается, мы всегда имеем дело с количеством информации, приходящимся в среднем на один элемент сообщения. Поэтому указание об усреднении опускается.