Количественное измерены информации

Информацию можно измерить количественно, подсчитать. Для этого абстрагируются от смысла сообщения. Шеннон дал формальное определение количества информации на основе вероятностного подхода и указал критерий, позволяющий сравнивать количество информации, доставляемое разными сигналами.

Смысл заключается в том, что между сигналом и событием существует однозначная связь. Совокупность сигналов является изоморфным отображением некоторых сторон реального события. Связь сигнала с событием воспринимается как смысловое содержание сигнала или сообщения, сущность которого состоит в том, что благодаря ему получатель побуждается к выбору определенного поведения. Всякое сообщение может рассматриваться как сведения об определенном событии х, в момент t. Это событие содержит данные о том, в каком из множества возможных состояний находилась система S в момент времени t. Процесс связи предполагает наличие множества возможностей. У.Р. Эшби приводит следующий пример.

Заключенного должна навестить жена. Сторож знает, что она хочет сообщить мужу, пойман ли его сообщник. Ей не разрешено делать никаких сообщений. Но сторож подозревает, что они договорились о каком-то условном знаке. Вот она просит послать мужу чашку кофе. Как сторож может добиться, чтобы сообщение не было передано? Он будет рассуждать так: может быть, она условилась передать ему сладкий иди несладкий кофе, тогда я могу помешать, добавив в кофе сахару и сказав об этом заключенному. Может быть, она условилась послать или не послать ему ложку, тогда я помешаю, изъяв ложку и сказав ему, что передача ложек воспрещена. Она может послать ему не кофе, а чай, но все знают, что в это время выдается только кофе. Как видно, сторож интуитивно стремится пресечь всякую возможность связи. Для этого он сводит все возможности к одной – только с сахаром, только без ложки, только кофе. Если все возможности сведены к одной, связь прерывается, и посылаемый напиток лишен возможности передать информацию. Из этого примера видно, что передача и хранение информации существенно связаны с наличием некоторого множества возможностей.

Кроме того, информация, передаваемая отдельным сообщением зависит от того множества, из которого оно выбрано. Например, два солдата находятся в плену - один в стране А, другой в стране В. Им разрешили послать женам телеграммы с содержанием «Я здоров». Однако известно, что в стране А пленным разрешается выбирать следующие сообщения: я здоров, я слегка болен, я серьезно болен. В стране В разрешается сообщать только: я здоров, означающее - я жив. Обе женщины получили одинаковую фразу, но они будут понимать, что полученная ими информация не является тождественной. Из этого примера видно, что передаваемая информация не является внутренним свойством индивидуального сообщения. Она зависит от того множества, из которого выбрана.

Сообщения могут быть непрерывные и дискретные. Непрерывные сообщения получают бесконечно малые приращения и совокупность последовательных символов не только не конечна, но и не поддается исчислению. Обычно в практике применяются

дискретные сообщения, под которыми понимается конечная последовательность символов, взятых из некоторого набора символов, называемого алфавитом. Каждый отдельный символ называется буквой алфавита.

Конечная последовательность символов, взятых из некоторого алфавита, называется словом. Использование дискретных сообщений позволяет передавать данные о состоянии, выбранном из сколь угодно большого числа возможных состоянии, посредством использования немногих различных символов из алфавита. Число этих символов называется основанием кода. Количество различных символов, из которых составляются слова, зависит от основания кода. Общепринятая арабская цифровая система придает специальное значение числу 10. Однако десятичная система счисления оправдывается только привычкой. В ряде европейских и азиатских стран, а также в России до начала XX века в какой-то мере использовали представление чисел в двоичной системе. Оказывается, что любое сколь угодно сложное сообщение, можно успешно передавать при помощи последовательности, построенной из двух различных символов. Во всем мире принято два символа: 0 и 7, которым соответствуют 0 — отсутствие сигнала, 1 - наличие сигнала. Если система может находиться в одном из N различных состояний, множество которых x1 ,x2...,xN известно получателю сообщения, то для передачи сведений о состоянии системы достаточно указать номер i (i=1, 2 ,..., N) состояния, в котором она находится. Этот номер представляет собой слово в алфавите, буквами которого являются цифры. Американская телефонная компания Белла воспользовалась этим и построила вычислительную машину, в основу которой положено двоичное счисление. Вместо того; чтобы записывать число в виде суммы стольких-то единиц, стольких-то десятков, стольких-то сотен, с таким же правом можно представлять целое число в виде суммы единиц, двоек, четверок, восьмерок и т.д.

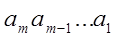

При этом всякое число i может быть записано в таком виде:

где каждое а может принимать только два значения: 0 или 1. Эта запись означает: . Если число в десятичной записи составляет i=35, то в двоичной записи оно имеет следующий вид: i=100011. Если это число записать снова в десятичной системе счисления, то получим:

. Если число в десятичной записи составляет i=35, то в двоичной записи оно имеет следующий вид: i=100011. Если это число записать снова в десятичной системе счисления, то получим:

35 =1*32 +0*16 +0*8 +0*4 +1*2+1.

Запись чисел от 1 до 15 в двоичной системе счисления имеет следующий вид: 1, 10, 11, 100, 101, 110, 111, 1000, 1001, 1010, 1011, 1100, 1101, 1110, 1111, а число 27 передается последовательностью символов 11011. Из приведенных примеров видно, что сообщение о любом событии может быть записано в виде слова в двухбуквенном алфавите. Различных двоичных последовательностей длины m имеется 2m, так как каждый символ может принимать два значения независимо от других. С помощью двоичной последовательности длины m можно передать сообщение о событии, выбранном из N возможных событий, где N=2m, или иначе:

m = log2 N .

Если передавать то же сообщение не двоичным кодом, а десятичным, то потребовалась бы последовательность длины  =log10 N . При этом m'~m. Из этого видно, что m отличается от m' постоянным множителем, независящим от N. Выбор коэффициента пропорциональности сводится к выбору основания логарифмов и одновременно означает выбор единицы количества информации. Обычно берутся логарифмы по основанию 2. В этом случае за единицу принимается количество информации, которое заключается в одном двоичном разряде, т.е. выборе одного из двух возможных сообщений. Такая единица информации называется битом. Слово “bit” является сокращенным от английского слова “binary digit”, что означает Двоичный разряд. Двоичную единицу, или бит можно представить себе как неизвестный заранее ответ «да» или «нет» на вопрос, ответ на который мы никак не можем предсказать и поэтому вынуждены считать оба ответа равновероятными. Поэтому в немецкой литературе эту двоичную единицу называют «да - нет» (ja Nein-Emheit). Если событие имеет два равновероятных исхода, то это означает, что вероятность каждого исхода равна 1/2. Сообщение о том, что родился мальчик или девочка несет информацию равную 1- (0.5 мальчик + 0.5 девочка). Кроме представления чисел с помощью двоичных индикаторов (устройство, которое в любой момент времени может быть только в одном из двух возможных состояний: 1 либо 0), каждую десятичную цифру можно представить с помощью четырех двоичных цифр, которое называется двоично-кодированным десятичным представлением. Такое представление требует не меньше битов, чем обычное двоичное.

=log10 N . При этом m'~m. Из этого видно, что m отличается от m' постоянным множителем, независящим от N. Выбор коэффициента пропорциональности сводится к выбору основания логарифмов и одновременно означает выбор единицы количества информации. Обычно берутся логарифмы по основанию 2. В этом случае за единицу принимается количество информации, которое заключается в одном двоичном разряде, т.е. выборе одного из двух возможных сообщений. Такая единица информации называется битом. Слово “bit” является сокращенным от английского слова “binary digit”, что означает Двоичный разряд. Двоичную единицу, или бит можно представить себе как неизвестный заранее ответ «да» или «нет» на вопрос, ответ на который мы никак не можем предсказать и поэтому вынуждены считать оба ответа равновероятными. Поэтому в немецкой литературе эту двоичную единицу называют «да - нет» (ja Nein-Emheit). Если событие имеет два равновероятных исхода, то это означает, что вероятность каждого исхода равна 1/2. Сообщение о том, что родился мальчик или девочка несет информацию равную 1- (0.5 мальчик + 0.5 девочка). Кроме представления чисел с помощью двоичных индикаторов (устройство, которое в любой момент времени может быть только в одном из двух возможных состояний: 1 либо 0), каждую десятичную цифру можно представить с помощью четырех двоичных цифр, которое называется двоично-кодированным десятичным представлением. Такое представление требует не меньше битов, чем обычное двоичное.

Минимальная единица информации, которую обрабатывают ЭВМ, называется байтом. Эта единица заключает в себе один символ. Символы существуют трех типов: цифры - 0, 1, 2, ... , 9, буквы Аа, ВЬ, ..., Zz. Специальные символы -,*,=, +; пробелы и др. Всего имеем 256 различных символов. Символ представляется двумя десятичными цифрами, которые в современных ЭВМ помещаются в один байт. Байт состоит из девяти битов. Восемь битов для представления информации и один бит - для проверки на четность. Восемь битов могут представлять восемь двоичных цифр или две десятичные цифры в двоично-кодированном десятичном представлении, например, число 31 представляется как 00110001, где 0011 представляет цифру 3, а 0001 - цифру 1. Бит проверки на четность добавляется к каждому байту таким образом, чтобы полное число составляющих его единиц было всегда нечетным. Нечетность служит проверкой на точность. Когда байт пересылается внутри ЭВМ, производится проверка, представляет ли он правильный код. Если он окажется четным числом единиц, то машинный контроль сообщает об ошибке. В теоретических исследованиях при определении количества информации удобно пользоваться не двоичными, а натуральными логарифмами. Соответствующая единица информации называется натуральной единицей, сокращенно «Нит» или «Нат». Если при определении количества информации пользуются десятичными логарифмами, единичную информацию получают, выделив сообщение из 10 равновероятных сообщений. Соответствующая единица информации называется децитом (decimal — digit — десятичный символ).

Количество информации в расчете на единицу времени называется скоростью передачи информации и исчисляется, например, в бит/сек.

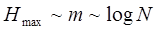

Каким бы ни было основание кода, длина последовательности, необходимой для передачи некоторого сообщения, пропорциональна логарифму числа возможных сообщении. Если статистические связи между символами отсутствуют, то максимальное количество информации (Hmax) которое содержится в сообщении, пропорционально длине:

Эта мера максимального количества информации, которое может содержать в сообщении, предложена к 1928 г. американским ученым Л. Хартли. Мера максимального количества информации облачает двумя важнейшими свойствами: она монотонно возрастает с возрастанием N и является аддитивной. Свойство аддитивности означает следующее: сообщение а выбирается из N1 возможных сообщений, независимое от а сообщение b выбирается из N2 возможных сообщений. Информация, которая содержится в сложном сообщении, состоящем из сообщения а и сообщения b, зависит от числа возможных сложных сообщений, их N = N1 *N2. Отсюда:

Очевидно, что в сложном сообщении содержится сумма информации, которую несут отдельные сообщения, что согласуется с интуитивными представлениями.

Величина Nmax указывает верхнюю границу количества информации, которое может содержаться в сообщении. Однако действительное количество информации зависит не только от числа возможных сообщений, но и от их вероятностей. Заслуга К. Шеннона состоит в том, что он указал на существование неопределенности относительно того, какое именно конкретное сообщение из множества сообщений отправителя будет выбрано для передачи. Это связывает информацию с теорией вероятностей. Оценка количества информации основывается на законах теории вероятностей. Сообщение имеет ценность, оно несет информацию только тогда, когда мы узнаем из него об исходе события, имеющего случайный характер, когда оно в какой-то мере неожиданно. При этом ценность информации в основном определяется степенью неожиданности сообщения.

Оказалось, что состояние неопределенности выбора обладает измеримой количественной оценкой, называемой энтропией источника сообщений (Н). Вероятность можно описать как частоту появления «Ио данного исхода в длинной серии однотипных испытаний.