Неопределенность

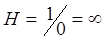

Понятия возможности, случайности, вероятности находятся в определенном отношении с понятием неопределенности. Неопределенность существует объективно. Она всегда имеет место тогда, когда производится выбор из некоторой совокупности элементов одного элемента. Степень неопределенности выбора характеризуется отношением числа выбранных элементов к общему числу элементов совокупности (множества). Если множество состоит из одного элемента, то степень неопределенности равна нулю. Вероятность выбора в этом случае равна 1. Множество из двух элементов имеет вероятность выбора, равную p=1/2. Степень неопределенности здесь будет равна 2. Вообще увеличение числа элементов в множестве ведет к росту степени неопределенности и к уменьшению вероятности выбора одного элемента. Бесконечное число элементов в множестве соответствует бесконечной неопределенности и нулевой вероятности. Из этого видно, что степень неопределенности и степень вероятности связаны друг с другом. Зная вероятность, можно определить степень неопределенности. Если мы должны угадать одно из 20 чисел, то, исходя из соображений равно возможности, вероятность угадать задуманное число будет составлять 1/20, а степень неопределенности равна 20. Однако при этом простой зависимости Н =1/p не получается (здесь Н - степень неопределенности и р - вероятность выбора элемента). При p = 0 степень неопределенности равна бесконечности:

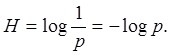

Если же р = 1, то Н =1/1=1, что является неверным, так как при р=1 степень неопределенности должна быть равна 0, ибо в множестве один элемент выбирать не из чего. В связи с этим зависимость между неопределенностью Н и вероятностью р измеряется логарифмом величины 1/p:

(4.1)

(4.1)

При этом можно брать логарифмы по любому основанию, но принято брать логарифмы по основанию два.

Изучением степени неопределенности и связи ее с вероятностью занимается статистическая теория информации. Формула H= log21/p является логарифмической мерой количества информации. В теории информации рассматриваются любые события, в результате которых уменьшается, уничтожается, исчезает неопределенность.

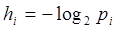

Для оценки количества информации, связанной с появлением одного сообщения, пользуются формулой:

(4.2)

(4.2)

где pi - вероятность появления события Si.

Такую оценку индивидуального количества информации называют индивидуальной энтропией. Индивидуальная энтропия события тем больше, чем меньше вероятность его появления. Однако статистическую теорию информации не интересует индивидуальное количество информации. Существенной для характеристики любого опыта являются не информации n1, n2 ..., nN, связанные с отдельными исходами опыта, а средняя информация, которая определяется следующим образом.

Пусть для некоторого события х известно, что количество различных исходов равно N, а вероятности их равны соответственно p1, p2, …,pN, причем p1+p2+…+pN=1.

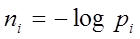

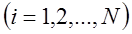

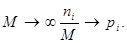

В результате достаточно большого числа испытаний (их число равно М) получено, что первый исход наступил m1 раз, второй – m2 раз,..., N-й - mN раз (m1+m2+…+mN=M). Известно, что в результате единичного наступления i-го исхода опыта получаем индивидуальное количество информации:

Поскольку первый исход наступил т, раз, то полученное при этом суммарное количество информации равно n1m1, где n1 - индивидуальное количество информации, полученное в результате одного наступления первого исхода опыта. Аналогично получаем суммарное количество информации, полученное при наступлении второго исхода опыта и т.д. Общее количество информации, полученное в результате M испытаний, равно

n1m1+n2m2+…+nNmN

а среднее количество информации, полученное в одном испытании, равно

При

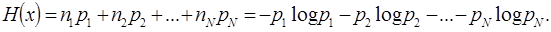

Отсюда получаем среднее количество информации, характеризующее событие x:

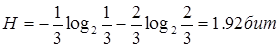

Предположим, что опыт состоит в извлечении одного шара из ящика, в котором находится один черный и два белых шара. Исходя из классического подхода, вероятность выбора черного шара равна 1/3, а вероятность выбора белого шара равна 2/3. Среднее значение неопределенности получается, если вероятность отдельного исхода умножается на его неопределенность, и эти произведения складываются:

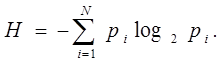

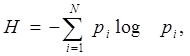

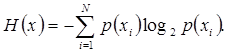

В общем виде формула степени неопределенности (количества информации в битах) имеет следующий вид:

(4.3)

(4.3)

Эта формула предложена в 1948 г. К. Шенноном. Ее называют еще формулой абсолютной негэнтропии. Она аналогична формуле энтропии, только имеет отрицательный знак.

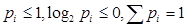

Знак минус в правой части приведенного уравнения использован для того, чтобы сделать величину Н положительной (поскольку  ). Понятие энтропии ввел немецкий физик-теоретик Р. Клаузиус в 1865 г. Термин происходит от греческого слова - entrope - «замкнуть внутри». Он обозначает меру деградации какой-либо системы. В 1872 г. австрийский физик Л. Больцман связал энтропию с вероятностью состояния. Изменения энергии в изолированной системе описываются вторым законом термодинамики, который был сформулирован следующим образом: теплота не может сама собою перейти от более холодного тела к более теплому. Cyть этого закона состоит в том, что способность изолированных систем совершать работу уменьшается, так как происходит рассеивание энергии. Формула энтропии определяет степень беспорядка, хаотичности молекул газа в сосуде. Естественным поведением любой системы является увеличение энтропии. Если энтропия имеет тенденцию к возрастанию, то система теряет информацию и деградирует. Чтобы система не деградировала, необходимо внести в нес дополнительную информацию (негэнтропию). Отсюда энтропия есть мера дезорганизацию а информация есть мера организованности. Всякий раз, когда в результате наблюдения система получает какую-либо информацию, энтропия этой системы уменьшается, а энтропия источника информации увеличивается.

). Понятие энтропии ввел немецкий физик-теоретик Р. Клаузиус в 1865 г. Термин происходит от греческого слова - entrope - «замкнуть внутри». Он обозначает меру деградации какой-либо системы. В 1872 г. австрийский физик Л. Больцман связал энтропию с вероятностью состояния. Изменения энергии в изолированной системе описываются вторым законом термодинамики, который был сформулирован следующим образом: теплота не может сама собою перейти от более холодного тела к более теплому. Cyть этого закона состоит в том, что способность изолированных систем совершать работу уменьшается, так как происходит рассеивание энергии. Формула энтропии определяет степень беспорядка, хаотичности молекул газа в сосуде. Естественным поведением любой системы является увеличение энтропии. Если энтропия имеет тенденцию к возрастанию, то система теряет информацию и деградирует. Чтобы система не деградировала, необходимо внести в нес дополнительную информацию (негэнтропию). Отсюда энтропия есть мера дезорганизацию а информация есть мера организованности. Всякий раз, когда в результате наблюдения система получает какую-либо информацию, энтропия этой системы уменьшается, а энтропия источника информации увеличивается.

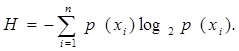

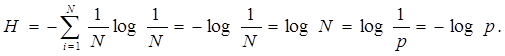

По приведенной формуле определяется среднее количество информация в сообщениях при неравновероятных исходах опыта. Легко заметить, что при равновероятности исходов формула

превращается в формулы:

и

и

поскольку сумма всех p всегда равна 1 и каждое pi = р.

Запишем формулу Шеннона в виде:

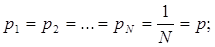

Пусть все исходы равновероятны, тогда:

подставив эти значения в формулу, получим:

Из формулы степени неопределенности видно, что среднее количество информации в битах в дискретном сообщении о простом событии определяется как отрицательная сумма вероятностей всех возможных событий, умноженных на их логарифмы по основанию 2. Количество информации выше среднего приходится на события, вероятность которых ниже. Более высокую информационную емкость имеют редкие события. Формулой подтверждается также более низкая неопределенность систем с более высокой вероятностью событий. Поскольку вероятность одних событий повышается за счет снижения

вероятности других (так как сумма всех вероятностей равна 1), энтропия становится тем ниже, чем менее вероятны события, а максимума она достигает при равновероятности всех событий.

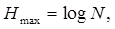

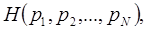

Покажем что Hmax, получаемое при равновероятных исходах события, является верхней границей значений H. Для этого найдем максимальное значение функции

используя множитель Лагранжа

Найти max

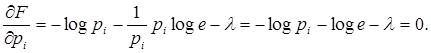

Приравняем нулю частные производные функции по pi.

Отсюда  и легко видеть, что все

и легко видеть, что все  , следовательно,

, следовательно,

H = Hmax. Если же событие является достоверным (при этом pi =1а остальные pi=0,  ), то

), то

H = -0*log0 - 0*log0 +…-1*log1+…-0*log0.

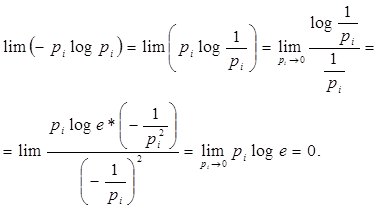

Легко показать, что выражение 0*log0 = 0*( )=0. Раскроем неопределенность, используя правило Лопиталя:

)=0. Раскроем неопределенность, используя правило Лопиталя:

Тогда получим Н=0 для достоверного события.

Следовательно, среднее количество информации находится в пределах

Теперь можно сформулировать определение условной вероятности. Если случайная величина х принимает значения x1,x2, ..., хN, а случайная величина y принимает значения y1, y2, ..., уM, то условной вероятностью называется вероятность того, что х примет значение хi, если известно, что у приняло значение yi.

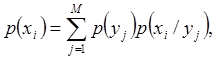

Безусловная вероятность p(xi) равна условной вероятности, усредненной по всем возможным значeниям y:

(4.4)

(4.4)

где p(yj) - вероятность j-го значения величины y, величина р(уj) p(xi/yj) - есть вероятность того, что у примет значение yj, а х - значение хi,. Она называется совместной вероятностью события (xi ,yj) и обозначается p(xi,yj).

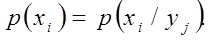

Очевидно, если события х и у независимы, то

(4.5)

(4.5)

Неопределенность события х определяется по формуле:

(4.6)

(4.6)

Если события х и у зависимы, и событие у приняло значение yj, то неопределенность события х становится равной:

(4.7)

(4.7)

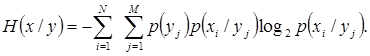

Так как событие у может принимать значение y1, у2,..., уM с вероятностями p(y1), р(у2),…, р(yM), средняя неопределенность события х при любых возможных исходах события у равна:

(4.8)

(4.8)