Это условная негэнтропия случайной величины х при задании случайной величины у. Она всегда не больше безусловной

,

,

причем равенство имеет место только в том случае, когда знание величины у не меняет вероятностей значений величины х, т.е.

,

,

каким бы ни было значение yj. Это условие означает, что неопределенность события х не возрастает от того, что событие у становится известно.

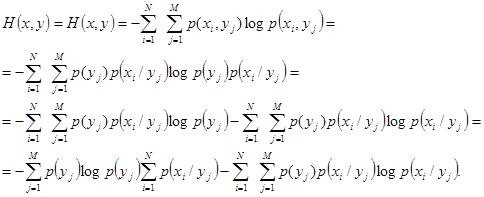

Для двух случайных событий х и у энтропия совместного события равна:

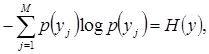

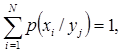

В полученном выражении

а второе слагаемое есть не что иное, как

H(x/y).

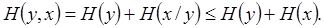

Следовательно,

(4.9)

(4.9)

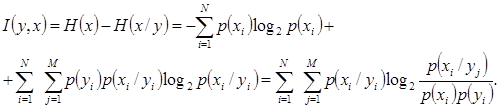

Равенство достигается тогда, когда события х и у независимы В качестве меры количества информации в случайной величине у о случайной величине х принимается величина, на которую уменьшается в среднем неопределенность величины х, если нам становится известным значение величины у:

Эта формула выражает количество информации в случайной величине у о случайной величине х, как разность между безусловной и условной негэнтропией.

По формуле условной негэнтропии строится вся современная статистическая теория информации. Переход от абсолютной негэнтропии к условной приобретает фундаментальное решающее значение. Формула условной негэнтропии выражает количество информации относительно заданной системы отсчета, системы координат. Иначе говоря, она характеризует количество информации, содержащееся в одном объекте относительно другого объекта.

Классическая теория информации дает полезный аппарат, но он не универсален и множество ситуаций не укладываются в информационную модель Шеннона. Далеко не всегда можно заранее установить перечень возможных состояний системы и вычислить их вероятности. Кроме того, основным недостатком этой теории является то, что, занимаясь только формальной стороной сообщений, она оставляет в стороне их ценность и важность. Например, система радиолокационных станций ведет наблюдение за воздушным пространством с целью обнаружения самолета противника. Система S, за которой ведется наблюдение, может быть в одном из двух состояний: x1 - пpoтивник есть, х2 - противника нет. Выяснение фактического состояния системы принесло бы в рамках классической теории информации 1 бит, однако первое сообщение гораздо важнее, что оценить невозможно с помощью вероятностного подхода.

Статистическая теория информации оперирует лишь вероятностями исходов рассматриваемых опытов и полностью игнорирует содержание этих исходов. Поэтому эта теория не может быть признана пригодной во всех случаях. Понятие информации в ней трактуется весьма односторонне.

Следовательно, уничтожение неопределенности, т.е. получение информации, может происходить не только в результате вероятностного процесса, но и в других формах. Понятие неопределенности оказывается шире понятия вероятности. Неопределенность - понятие, отражающее отсутствие однозначности выбора элементов множества. Если этот выбор имеет случайный характер, то мы имеем дело со статистической теорией информации. Если же этот выбор не случаен, то необходим невероятностный подход к определению информации. Существуют следующие невероятностные подходы к определению информации: динамический, топологический, алгоритмический. Мы не будем рассматривать эти невероятностные подходы к определению количества информации, отметим только, что каждый из этих методов обнаруживает нечто общее со статистическим подходом. Оно состоит в том, что эти методы изучают переход от неопределенности к определенности. Но все же эти методы отличаются от статистического подхода. Один из невероятностных подходов к определению количества информации принадлежит советскому ученому А.Н. Колмогорову. По аналогии с вероятностным определением количества информации как функции связи двух систем, он вводит определение алгоритмического количества информации.

Количество информации, содержащееся в сообщении, можно связывать не только с мерой неопределенности системы, но и с ее структурной сложностью и точностью измерений. Такой подход предлагается к оценке научной информации, возникающей в результате анализа процесса наблюдений и эксперимента.

Количество различных признаков, характеризующих данный предмет, т.е. его размерность или число степеней свободы, является мерой структурной информации. Ясно, что цветное изображение содержит в себе больше информации по сравнению с черно-белым изображением того же объекта. Единица структурной информации - логон - означает, что к имеющемуся представлению можно добавить одну новую различимую группу или категорию.

Количество метрической информации связано с разрешающей способностью измерений. Например, эксперимент, результат которого обладает погрешностью, равной 1%, дает больше информации, чем эксперимент, характеризующийся погрешностью в 10%.

Единицей измерения метрической информации является метрон. В случае числового параметра эта единица служит мерой точности, с которой этот параметр определен.

Статистический и нестатистический подходы в теории информации касаются только количества информации, но информация имеет еще и качественный аспект. Объединение элементов в множество всегда предполагает наличие у них некоторого свойства, признака, благодаря чему они образуют данное множество, а не иное. Следовательно, каждый элемент множества обладает определенным качественным отличием от элемента другого множества. Кроме того, внутри множества различие элементов друг от друга носит тоже качественный характер. Поиск качественного аспекта информации как раз и состоит в учете природы элементов, объединяемых в множества, в учете качественного многообразия материи.

До сих пор информация рассматривалась как снятая, устраняемая неопределенность. Именно то, что устраняет, уменьшает любую неопределенность и есть информация. Однако информацию можно рассматривать не только как снятую неопределенность, а несколько тире. Например, в биологии информация - это прежде всего совокупность реальных сигналов, отображающих качественное или количественное различие между какими-либо явлениями, предметами, процессами, структурами, свойствами. Такой более широкий подход к определению понятия информации сделал У. Росс Эшби. Он считает, что понятие информации неотделимо от понятия разнообразия. Природа информации заключается в разнообразии, а количество информации выражает количество разнообразия. Одно и то же сообщение при разных обстоятельствах может содержать различное количество информации. Это зависит от разнообразия, которое наблюдается в системе.

Слово «разнообразие» означает число различных элементов в множестве. Так, например, множество с, b, с, а, с, с, а, b, с, b, b, а, если не принимать во внимание порядок расположения элементов, содержит 12 элементов, и только три из них различные: а, b, с. Такое множество имеет разнообразие в три элемента.

Множество с разнообразием и множество с вероятностями имеют эквивалентные свойства. Так, множество, у которого все элементы различны, имеет максимальное количество разнообразия. Чем больше в системе разнообразия, тем больше неопределенность в поведении такой системы. Уменьшение разнообразия уменьшает неопределенность системы. Вероятность выбрать наугад данный элемент из множества с максимальным разнообразием равна единице, деленной на количество всех элементов множества  . Нетрудно видеть, что это аналогично статистической совокупности с равномерным распределением вероятностей. Количество информации в этом случае имеет максимальное значение. Множество, у которого все элементы одинаковы, содержит минимальное количество разнообразия - всего в один элемент. Аналогией такого множества является статистическая совокупность с таким распределением вероятностей, когда одна из них равна единице, а остальные нулю. Количество информации в такой совокупности равно нулю. В множестве информация появляется только тогда, когда один элемент отличается от другого. Подобно вероятности разнообразие может измеряться как число различных элементов и как логарифм этого числа, например, по основанию два. Между минимальным и максимальным количеством разнообразия в множестве существует ряд промежуточных состояний, которые появляются в результате ограничения разнообразия. Понятие ограничения разнообразия является очень важным. Оно представляет собой отношение между двумя множествами. Это отношение возникает, когда разнообразие, существующее при одних условиях, меньше, чем разнообразие, существующее при других условиях.

. Нетрудно видеть, что это аналогично статистической совокупности с равномерным распределением вероятностей. Количество информации в этом случае имеет максимальное значение. Множество, у которого все элементы одинаковы, содержит минимальное количество разнообразия - всего в один элемент. Аналогией такого множества является статистическая совокупность с таким распределением вероятностей, когда одна из них равна единице, а остальные нулю. Количество информации в такой совокупности равно нулю. В множестве информация появляется только тогда, когда один элемент отличается от другого. Подобно вероятности разнообразие может измеряться как число различных элементов и как логарифм этого числа, например, по основанию два. Между минимальным и максимальным количеством разнообразия в множестве существует ряд промежуточных состояний, которые появляются в результате ограничения разнообразия. Понятие ограничения разнообразия является очень важным. Оно представляет собой отношение между двумя множествами. Это отношение возникает, когда разнообразие, существующее при одних условиях, меньше, чем разнообразие, существующее при других условиях.

Ограничения разнообразия весьма обычны в окружающем нас мире. Любой закон природы подразумевает наличие некоторого инварианта, поэтому всякий закон природы есть ограничение разнообразия.

Окружающий мир чрезвычайно богат ограничениями разнообразия. Без ограничений разнообразия мир был бы полностью хаотичным. Ограничение разнообразия соответствует уменьшению количества информации, поэтому ограничение разнообразия равносильно установившемуся в статистической теории понятию избыточности. Избыточность тем больше, чем больше ограничение разнообразия. Если же элементы в множестве одинаковы, то избыточность равна единице. Если в ящике все шары оказываются одинакового цвета то их избыточность по цвету равна единице, если же все шары будут разного цвета, то избыточность равна нулю. Наличие у информации качества вызывает необходимость в классификации видов информации. Различают элементарную информацию, т.е. информацию в неживой природе, биологическую, логическую, человеческую, или социальную. Для социальной информации характерно выделение двух аспектов: семантического, связанного с содержанием сообщений, и прагматического, связанного с полезностью их для получателя.