рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Науковедение

- /

- Вторая итерация

Реферат Курсовая Конспект

Вторая итерация

Вторая итерация - раздел Науковедение, МЕТОДИЧЕСКИЕ УКАЗАНИЯ К КУРСОВОЙ РАБОТЕ ПО ДИСЦИПЛИНЕ СИСТЕМЫ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА Для Второй Итерации В Качестве Начального Значения Векто...

Для второй итерации в качестве начального значения вектора весовых коэффициентов используется значение, полученное на конечном шаге первой итерации.

5.12. Выполняются пункты 5.2 – 5.11. Если по результатам второй ите-рации не достигается выполнения условия непревышения предельно допус-тимых ошибок обучения, проводится третья итерация и так до тех пор, пока на будет выполнено условие непревышения ошибок обучения для всех воз-можных входных векторов. По достижении этого условия обучение выбран-ного нейрона заканчивается.

6. Выбирается следующий нейронный элемент и сигнал, на который этот элемент должен быть настроен.

7. Выполняются п.п. 4 – 12 для обучения выбранного нейронного элемента.

8. Выполняются п.п. 6.- 7 для обучения всех нейронных элементов сети.

9. Путем подачи на вход сети всех распознаваемых образов подтверждается единичная реакция каждого нейронного элемента только на входной сигнал, соответствующий образу, распознаваемым данным элемен-том. В случае ошибочного решения, принимаемого сетью, выполнить про-верку правильности приведения расчетов, выполняемых при проектирова-нии.

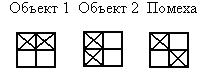

6.2.4. Пример. Выполнить проектирование сети, предназначенной для распознавания двух образов, при условии, что на входе сети кроме распоз-наваемых объектов может присутствовать и мешающий образ.

1. Проводится анализ задания на проектирование. Выполняется кодиро-вание (при необходимости) входной информации. Определяется размерность входного вектора и необходимое для решения задачи распознавания число нейронов.

Представим распознаваемые образы и мешающий образ в виде кодиро-ванных последовательностей, в которых единицей будем кодировать заштри-хованные квадратики, а нулем – незаштрихованные. В соответствии с вы-бранным типом кодирования образы могут быть представлены кодами:

распознаваемые объекты – 1100 и 1010, мешающий объект – 1001 (выбор порядка кодирования произволен, но одинаков для всех образов).

Так как размерность кодов во всех случаях одинакова и равна 4, то раз-мерность входного вектора принимается равной 4. В связи с тем, что число распознаваемых полезных образов равно 2, то число нейронов в сети выбира-ется равным 2.

2. Разрабатывается структурная схема нейронной сети. Осуществляется закрепление каждого из нейронов за распознаваемым образом.

Рис. 7

Будем считать, что первый нейрон должен обеспечить распознавание первого образа, а второй – второго.

3. Выбирается правило расчета весовых коэффициентов.

Расчет вектора весовых коэффициентов в процессе обучения производится в соответствии с выражением

где  - рассчитываемое значение вектора весовых коэффициентов на к-том шаге,

- рассчитываемое значение вектора весовых коэффициентов на к-том шаге,  - значение вектора весовых коэффициентов, полученное на предыдущем шаге,

- значение вектора весовых коэффициентов, полученное на предыдущем шаге,  - корректирующее слагаемое, получаемое в соответствии с выражением

- корректирующее слагаемое, получаемое в соответствии с выражением

где ……….(расписать входящие обозначения)

4. Выполним выбор параметров первого нейронного элемента.

Примем значение коэффициента обучения h=0,6.

Пороговое значение θ1=2, так как число единиц в коде, соответству-ющем первому образу равно 2.

Определим желаемые реакции первого нейрона на полезный образ и мешающие для него образы как

t´´1жел пол (1) = θ1 +∆

и t´´1жел меш (2,3) = θ1 -∆.

Выберем ∆= 0,5 (так как само значение θ1 небольшое).

Тогда t´´1жел пол (1)=2,5, а t´´1жел меш (2,3) = 1,5.

– Конец работы –

Эта тема принадлежит разделу:

МЕТОДИЧЕСКИЕ УКАЗАНИЯ К КУРСОВОЙ РАБОТЕ ПО ДИСЦИПЛИНЕ СИСТЕМЫ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА

ОДЕССКИЙ НАЦИОНАЛЬНЫЙ ПОЛИТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ...

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ: Вторая итерация

Что будем делать с полученным материалом:

Если этот материал оказался полезным ля Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Хотите получать на электронную почту самые свежие новости?

Новости и инфо для студентов