рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Медицина

- /

- Про Интеллект. Временная иерархическая память

Реферат Курсовая Конспект

Про Интеллект. Временная иерархическая память

Про Интеллект. Временная иерархическая память - раздел Медицина, Временная Иерархическая Память ...

Временная Иерархическая Память

Концепции, Теория и Терминология

Джеф Хокинс и Дайлип Джордж, Numenta Inc.

Предисловие

Есть множество вещей, легко дающихся людям, но недоступных пока для компьютеров. Такие задачи, как распознавание визуальных паттернов, понимание естественного языка, распознавание и манипулирование объектами на ощупь и ориентирование в сложном мире, элементарны для людей. Да, несмотря на десятилетия исследований, у нас нет жизнеспособного алгоритма для реализации на компьютере этих и многих других когнитивных функций.

У человека за эти способности в основном отвечает неокортекс. Временная Иерархическая Память (Hierarchical Temporal Memory, HTM) – это технология, имитирующая структурные и алгоритмические свойства неокортекса. Следовательно, HTM дает надежду на построение машин, которые приблизятся или даже превзойдут уровень человека при выполнении многих когнитивных задач.

HTM не похожи на традиционные программируемые компьютеры. Для традиционных компьютеров программисты пишут программы, решающие конкретные проблемы. Например, одна программа может быть использована для распознавания речи, а другая, совершенно отличная от нее программа, может быть использована для моделирования погоды. С другой стороны, об HTM лучше думать, как о системе памяти. HTM не программируются и не выполняют различных алгоритмов для различных проблем. Вместо этого, HTM «учатся» решать проблему. HTM обучают путем подачи на них сенсорных данных, и способности HTM определяются в основном тем, какие данные подавались.

HTM организованы как деревовидная иерархия узлов, где каждый узел реализует общие функции обучения и памяти. HTM хранит информацию в иерархии, моделируя мир. Все объекты в мире, будь то машины, люди, здания, речь или поток информации в компьютерной сети, имеют какую-либо структуру. Эта структура иерархическая и в пространственном, и во временном отношении. HTM также иерархическая и в пространстве и во времени, и, следовательно, может эффективно фиксировать и моделировать структуру мира.

HTM похожи на Байесовские Сети; однако, они отличаются от большинства Байесовских Сетей тем, как используется время, иерархия и внимание. HTM могут быть реализованы программно на традиционном компьютерном оборудовании, но о них лучше думать, как о системах памяти.

Эта статья описывает теорию, лежащую в основе HTM, описывает, что HTM делают и как они это делают. Она детально описывает две наиболее важные способности HTM - способность обнаруживать причины и выдвигать гипотезы о причинах. Она вводит концепции, лежащие в основе двух других способностей HTM - предсказания и поведения.

Эта статья описывает теорию, лежащую в основе изделия корпорации Numenta, но не описывает само изделие. Отдельный документ описывает продукт Numenta и то, как применить технологию HTM к проблемам реального мира.

HTM основывается на биологии. Следовательно, есть детальное соответствие между HTM и биологической анатомией неокортекса. Заинтересованные читатели могут найти частичное описание этого в главе 6 в книге «On Intelligence» (Times Books, 2004). Нет необходимости знать биологические соответствия HTM для использования HTM.

Концепции в основе HTM не очень сложные, но их очень много, так что путь к ее пониманию может быть трудным. Эта статья должна быть понятна для любого достаточно заинтересованного человека. Мы не предполагаем наличия специальной математической подготовки. (Полное математическое описание алгоритма доступно при наличии лицензии). Научиться разрабатывать системы, основанные на HTM по сложности почти аналогично написанию сложной программы. Любой может научиться этому, но если вы начинаете с нуля, потребуется долго учиться.

Эта статья подразделяется на семь основных разделов, перечисленных ниже.

1. Что делает HTM?

2. Как HTM обнаруживает причины и выдвигает гипотезы о причинах?

3. Почему иерархия так важна?

4. Как каждый узел обнаруживает и выдвигает гипотезы о причинах?

5. Почему время так существенно для обучения?

6. Вопросы

7. Выводы

1. Что делает HTM?

Уже свыше 25 лет известно, что неокортекс работает по единому алгоритму; зрение, слух, осязание, язык, поведение и многое другое, выполняемое неокортексом – проявления единого алгоритма, применяемого к различным модальностям сенсорной информации. Это же верно и для HTM. Так что, когда мы описываем, что делает HTM и как она работает, наше объяснение будет в терминах, не зависящих от сенсорной модальности. Как только вы поймете, как работает HTM, вы поймете, как можно применить HTM к большому классу задач, включающему много того, что не относится к человеку.

HTM выполняет следующие четыре основных функции в независимости от конкретной задачи, к которой она применяется. Первые две обязательны, последние две опциональны.

1) Обнаружение причин в мире

2) Выдвижение гипотез о причинах нестандартной информации

3) Предсказание

4) Управление поведением

Рассмотрим эти основные функции по очереди.

1.1 Обнаружение причин в мире

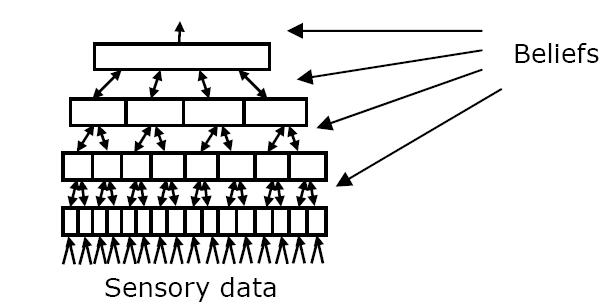

Рисунок 1

Мы существуем в одном большом физическом мире. Однако, определенные HTM могут быть нацелены только на подмножество этого мира. HTM может быть ограничена знанием о финансовом рынке, или взаимодействовать только с погодным феноменом, или только с геофизическими данными, демографическими данными или данными, собранными с сенсоров, установленных на автомобилях. Далее, когда мы будем ссылаться на «мир» HTM, мы будем иметь в виду его ограниченную часть, которая действует на HTM.

На правой стороне рисунка 1 изображена HTM. Она взаимодействует с ее миром через один или несколько сенсоров в средней части рисунка. Сенсоры делают выборки некоторых атрибутов мира, таких как свет или прикосновение, однако сенсоры, используемые HTM, не обязаны быть аналогичными органам чувств человека. Обычно сенсоры не обнаруживают объекты мира напрямую. У вас нет «чувства автомобиля» или «чувства слова». Вместо этого, цель HTM - обнаружить в потоке сырой информации от сенсоров то, что существуют такие объекты, как «машина» или «слово». Сенсоры обычно подают в HTM массив данных, где каждый элемент – это измерение некоторого маленького атрибута мира. У человека зрительный нерв, переносящий информацию от сетчатки в кортекс, состоит приблизительно из миллиона волокон, где каждое волокно переносит информацию об освещенности маленькой части видимого пространства. В слуховом нерве около тридцати тысяч волокон, где каждое волокно несет информацию о небольшом частотном диапазоне звукового спектра. Сенсоры, подключенные к HTM, как правило, будут организованы аналогично. То есть, информация с сенсоров будет топологически организованными наборами данных, где каждый элемент измеряет локальную и простую величину.

У всех систем HTM есть какой-либо типа сенсорной информации, даже если данные поступают из файла. С точки зрения HTM, у сенсорных данные есть две основных свойства. Первое - сенсорные данные должны измерять что-то, что прямо или косвенно связано с причинами в мире, который мог бы вас заинтересовать. Если вы хотите, чтобы HTM изучала погоду, она должна чувствовать что-то, относящееся к погоде, такое как температура и давление в различных местах. Если HTM предназначена для анализа трафика в компьютерных сетях, она могла бы измерять количество пакетов в секунду и загрузку процессоров на маршрутизаторах. Вторая – сенсорные данные должны поступать во времени непрерывным потоком, тогда как причина, лежащая в основе сенсорных данных, может оставаться относительно стабильной. Временной аспект сенсорных данных может исходить из движения или изменения объектов в реальном мире (такого, как движение автомобиля или ежеминутные флуктуации рынка ценных бумаг), или он может исходить из движения самой сенсорной системы по миру (такого, когда вы идете по комнате или проводите пальцами по объекту). В любом случае, сенсорные данные должны непрерывно изменяться во времени для того, чтоб HTM обучалась.

HTM получает пространственно-временные паттерны, приходящие от сенсоров. Поначалу у HTM нет знания о причинах в мире, но через процесс обучения, который будет описан далее, она «открывает», что является причиной. Конечной целью этого процесса является то, что в HTM образуется внутреннее представление причин в мире. В мозгу нервные клетки обучаются представлению причин в мире, например, нейроны, активизирующиеся, когда вы видите лицо. В HTM причины представляются векторами чисел. В любой момент времени, основываясь на текущей и прошлых выборках, HTM будет назначать вероятность, что в данный момент воспринимается та или иная причина. На выходе HTM выдается набор вероятностей для каждой из известных причин. Это распределение вероятностей в каждый момент называется «гипотезой». Если HTM знает о десяти причинах в мире, у нее будет десять переменных, представляющих эти причины. Значения эти переменных – гипотезы – то, что по мнению HTM происходит в мире в данный момент. Обычно HTM знает о множестве причин, и, как вы увидите, HTM в действительности изучает иерархию причин.

Обнаружение причин это сердце восприятия, творчества и интеллекта. Ученые пытаются открыть причины физических феноменов. Бизнесмены ищут причины, лежащие в основе маркетинговых или бизнес-циклов. Врачи ищут причины болезней. С момента вашего рождения ваш постепенно запоминает представления для любых вещей, с которыми вы в конечном итоге встречаетесь. Вы должны обнаружить, что автомобили, здания, слова и мысли являются постоянными структурами мира. Прежде чем вы сможете узнавать что-то, ваш мозг должен сначала обнаружить, что существуют вещи.

Все системы HTM должны пройти через фазу обучения, в которой HTM изучает, какие причины существуют в мире. Сначала все HTM изучают маленькие и простые причины их мира. Большие HTM, когда предоставлено достаточное количество сенсорных данных, могут обнаружить сложные высокоуровневые причины. При достаточном обучении и правильном дизайне должно быть возможно построить HTM, способные обнаружить причины, которые не могут обнаружить люди. После начального обучения HTM может продолжить обучение или нет, в зависимости от нужд приложения.

В обнаружении причин может быть очень большое значение. Для рыночных флуктуаций, болезней, погоды, доходов производства и отказов сложных систем, таких как энергетические сети, важно понимание высокоуровневых причин. Обнаружение причин также необходимый предшественник для второй способности HTM – выдвигать гипотезы.

1.2 Выдвижение гипотез о причинах нестандартной информации

Текущие гипотезы HTM могут быть непосредственно считаны с системы, чтоб быть использованными где-то за пределами HTM (что не возможно для… В большинстве систем HTM сенсорная информация всегда будет новой. В системе… Большинству приложений HTM будут требоваться изменяющиеся во времени сенсорные данные для того, чтоб выдвигать…1.3 Предсказания

Установка предпочтений

В случае HTM у нас есть возможность вручную установить априорные вероятности в дополнение к априорным вероятностям, установленным через…Воображение и планирование

Предсказание также является сердцем того, как HTM может направлять моторное поведение, четвертой и последней способности HTM.1.4 Управление поведением

На рисунке 2а изображена система с HTM и способностью генерировать простое поведение. Моторные компоненты этой системы имеют встроенное…Рисунок 2а

HTM моделирует мир путем построения представлений причин, включая предустановленное моторное поведение

Рисунок 2b

Представление моторного поведения автоассоциативно сопоставляется с моторными генераторами, позволяющими HTM управлять поведением

HTM могут управлять поведением множества различных типов систем; они не ограничены традиционной робототехникой. Вообразите офисное здание с…Выводы

Мы кратко обсудили четыре способности HTM:

1) Обнаружение причин в мире

2) Выдвижение гипотез о причинах нестандартной информации

3) Предсказание

4) Использование предсказаний для управления моторным поведением.

Это фундаментальные способности, которые могут быть применены к многим типам задач. Теперь мы обратим наше внимание на то, как HTM в действительности обнаруживают причины и выдвигают о них гипотезы.

2. Как HTM открывают причины и выдвигают о них гипотезы?

HTM структурно устроены как иерархия узлов, где каждый узел выполняет один и тот же алгоритм. На рисунке 3 изображена простая иерархия HTM. Сенсорные данные поступают снизу. Сверху выходит вектор, в котором каждый элемент представляет потенциальную причину сенсорных данных. Каждый узел иерархии выполняет ту же функцию, что и вся иерархия целиком. То есть, каждый узел рассматривает пространственно-временные паттерны, поступающие в него и обучается назначать причины поступающим в него паттернам. Проще говоря, каждый узел в независимости от его места в иерархии открывает причины своей входной информации.

Выход каждого узла одного уровня становится входом следующего уровня иерархии. Самые нижние узлы иерархии получают информацию от маленьких участков сенсорной области. Следовательно, причины, которые он открывает, соотносятся с маленькими участками входного сенсорной области. Вышестоящие области получают информацию от многочисленных нижестоящих узлов, и снова открывают причины этой информации. Эти причины промежуточной сложности, возникающие на участках большего размера. Узел или узлы на верхушке иерархии представляют высокоуровневые причины, которые могут возникать в любой части сенсорного поля. Например, в HTM, выдвигающей визуальные гипотезы, узлы внизу иерархии обычно обнаруживают простые причины, такие как края, линии и углы на маленькой части визуального поля. Узлы на верхушке иерархии будут представлять сложные причины, такие как собаки, лица, автомобили, которые могут появиться на всем визуальном пространстве или на любой части визуального пространства. Узлы промежуточных уровней иерархии представляют причины промежуточной сложности, которые возникают на участках промежуточного размера. Помните, что все эти причины должны быть обнаружены HTM. Они не программируются и не выбираются разработчиком.

Рисунок 3

В HTM гипотезы существуют на всех уровнях иерархии, не только на верхнем уровне. Гипотеза – это внутреннее состояние каждого узла. Вы можете рассматривать ее как вектор чисел, каждое из которых представляет вероятность того, что причина активна.

Каждый элемент в векторе гипотезы (то есть каждая причина) зависит сам от себя. Каждая причина может быть понята и интерпретирована сама по себе и имеет свое собственное значение. Другими словами, значение переменной, представляющей причину, не зависит от того, какие другие причины могут быть активными в том же самом векторе. Это не значит, что причины, представляемые узлом, статистически независимы, или что только одна из них активна за раз. Несколько причин могут быть активными одновременно. Представления, используемые в HTM, отличаются от тех, которые, скажем, используются в ASCII коде. Конкретный бит из восьми битов ASCII кода не имеет значения сам по себе.

Выход узла – также вектор. Выход аналогичен гипотезам узла, и наследуется от вектора гипотез. Сейчас пока мы будем рассматривать выход узла как его гипотезы. Хотя это не совсем корректно, так будет проще описывать операции в HTM.

Держа это в уме, мы можем сказать, что информация на входе узла – это гипотезы дочерних узлов. Выход узла это гипотезы, которые станут частью информации, поступающей на вход родителя. Даже будет корректным рассматривать информацию от сенсоров как гипотезы, приходящие от сенсорной системы.

В идеальном мире не было бы никакой однозначности на каждом узле. Однако, на практике такого не бывает. Одним из важных свойств HTM является то, что она быстро разрешает конфликт или неоднозначность входной информации по мере ее продвижения вверх по иерархии.

Каждый узел HTM имеет обычно фиксированное количество причин и фиксированное количество выходных переменных. Следовательно, HTM начинает с фиксированного количества возможных причин, и, в процессе тренировки она обучается присваивать им смысл. Узлы не «добавляют» причины по мере открытия, вместо этого, в процессе обучения, смысл выходных переменных постепенно изменяется. Это происходит на всех уровнях иерархии одновременно. Следствием такой методики обучения является то, что необученная HTM не может формировать осмысленных представлений на вершине иерархии до тех пор, пока узлы на нижнем уровне не пройдут достаточное обучение.

Базовые операции в каждом узле делятся на два шага. Первый шаг – связать входной паттерн узла с одной из множества точек квантования (представляющих обобщенные пространственные паттерны входной информации). Если у узла есть 100 точек квантования, узел назначает каждой из 100 точек квантования вероятность того, что текущая входная информация соответствует точке квантования. Снова, на этом первом шаге, узел определяет, насколько близко к каждой из точек квантования текущий входной паттерн, и назначает вероятность каждой точке квантования.

На втором шаге узел ищет обобщенные последовательности этих точек квантования. Узел представляет каждую последовательность переменной. По мере поступления паттернов во времени, узел назначает этим переменным вероятность, что текущая входная информация является частью каждой из последовательностей. Набор этих переменных для последовательностей является выходом узла и передается вверх по иерархии родительскому(им) узлу(ам).

Узел также может посылать информацию своим детям. Сообщение, идущее вниз по иерархии, представляет распределение по точкам квантования, тогда как сообщение, идущее вверх по иерархии, представляет распределение по последовательностям. Следовательно, по мере продвижения информации вверх по иерархии каждый узел пытается слить серию входных паттернов в относительно стабильный выходной паттерн. По мере продвижения информации вниз по иерархии каждый узел принимает относительно стабильные паттерны от своих родителей и пытается обратить в последовательности пространственных паттернов.

Путем сопоставления причин последовательностям паттернов происходит естественное слияние времени по мере продвижения паттерна вверх по иерархии. Быстро изменяющиеся низкоуровневые паттерны становятся медленно изменяющимися по мере их продвижения вверх. Обратное также верно. Относительно стабильные паттерны на верхушке иерархии может развернуться в сложную временную последовательность паттернов внизу иерархии. Изменяющиеся паттерны, поступающие на вход узла, аналогичны сериям музыкальных нот. Последовательности этих нот подобны мелодиям. Если входной поток, поступающий на узел, соответствует одной из запомненных им мелодий, узел передает «название» мелодии вверх по иерархии, а не отдельные ноты. Следующий вышестоящий узел делает то же самое, рассматривая последовательности последовательностей, и т.д. Каждый узел предсказывает, какая нота или ноты вероятнее всего должны последовать далее, и эти предсказания передаются вниз по иерархии дочерним узлам.

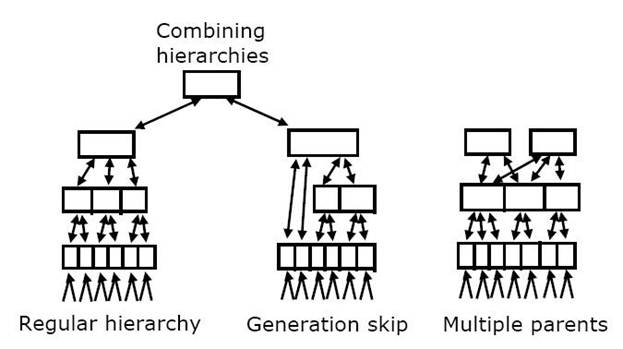

Количество уровней иерархии, количество узлов на каждом уровне иерархии и емкость каждого узла не критичны для основных положений теории HTM. Аналогично, точные соединения между узлами не критичны, пока между каждыми двумя узлами сохраняют ясные отношения отцы/дети в иерархии. Рисунок 4 показывает несколько вариаций соединений, которые правомерны в HTM. Дизайн и емкость конкретных HTM должна соответствовать поставленной задаче и доступным вычислительным ресурсам. Большая часть усилий может уйти на получение оптимальной производительности. Однако, любые конфигурации HTM будут работать в какой-либо степени. В этом отношении система надежна.

Рисунок 4

Исходя из того, что каждый узел HTM должен открывать причины и выдвигать о них гипотезы (точно то же самое, что делает HTM целиком, только в меньшем масштабе), мы придем к двум вопросам. Первый, почему так важна иерархия? То есть, почему проще открывать причины и выдвигать гипотезы, используя иерархию узлов? Второй, как каждый узел открывает причины и выдвигает гипотезы? В конце концов, каждый узел должен решать ту же самую задачу, что и вся система в целом. Далее мы обратимся к первому из этих двух вопросов.

3. Почему иерархия так важна?

Есть четыре причины, почему так важно использовать иерархию узлов. Мы затронем каждую из них, начиная с наиболее важной.

3.1 Совместное использование представлений ведет к обобщению и эффективности хранения

Чтобы помочь вам понять, почему HTM может решать задачи, недоступные другим алгоритмам, мы взглянем более глубоко на затруднения, имеющиеся у этих… Наиболее основным подходом, используемым для распознавания объектов на… Например, вообразите, что вы пытаетесь распознать изображение собаки. На вашем прототипе собака повернута влево, а на…3.2 Иерархия HTM соответствует пространственной и временной иерархии реального мира

Объекты в мире и паттерны, создаваемые ими в сенсорных массивах, в основном имеют иерархическую структуру, которая может быть использована иерархией… Заметьте, что если бы вы произвольно перемешали пикселы с камеры, то… HTM не просто используют иерархическую пространственную структуру мира. Они так же используют иерархическую временную…3.3 Распространение гипотез гарантирует, что все узлы быстро приходят к наилучшим взаимно согласованным гипотезам

Проиллюстрируем идею простым примером. Предположим, что у нас есть два узла, где узел A представляет гипотезу о температуре воздуха, и имеет пять… Распространение Гипотез (РГ) это математическая техника, используемая в… Для разработчика систем, основанных на HTM, полезно иметь базовое понимание Байесовских сетей и Распространения…3.4 Иерархическое представление дает механизм внимания.

Сравните это со «скрытым» вниманием, которое возникает, когда ваши глаза, пальцы или тело обращает внимание на различные объекты. Множество… Рисунок 5 иллюстрирует базовый механизм, с помощью которого HTM реализуют…Рисунок 5

Есть несколько возможных способов активации таких переключений. В настоящий момент мы проверили, что основные принципы работают. Биологи полагают, что есть несколько способов, как это может быть, включая метод снизу вверх, где сильные неожиданные паттерны открывают путь для внимания, и метод сверху вниз, приводимый в действие ожиданиями. Более того, кажется, что в человеческом мозге часть путей, идущих вверх по иерархии, переключаемы, а часть – нет. Для HTM были разработаны и протестированы методы переключения скрытого внимания.

В этой секции мы рассмотрели большинство причин, почему для HTM существенен иерархический дизайн.

1) Совместное использование представлений сокращает требования к памяти и время на обучение.

2) Иерархическая структура мира (в пространстве и времени) отражается иерархической структурой HTM.

3) РГ-подобные методики гарантируют быстрое достижение взаимно совместимых наборов гипотез сетью.

4) Иерархия предоставляет простой механизм для скрытого внимания.

Теперь мы готовы обратить наше внимание на то, как работает отдельные узлы HTM. Вспомните, что каждый узел должен обнаруживать причины и выдвигать гипотезы. Как только мы рассмотрим, что и как делают узлы, нам станет понятно, как HTM в целом обнаруживает причины и выдвигает гипотезы о причинах нестандартной информации.

4. Как каждый узел обнаруживает и выдвигает гипотезы о причинах?

Узел HTM не «знает», что он делает. Он не знает, представляет ли получаемая информация свет, сигналы сонара, экономические данные, слова или данные производственного процесса. Узел также не знает, где он располагается в иерархии. Так как же он может самообучаться тому, какие причины ответственны за его входную информацию? В теории ответ прост, но на практике он сложнее.

Вспомните, что «причина» - это всего лишь постоянная или повторяющаяся структура в мире. Таким образом пытается назначить причины повторяющимся паттернам в его входном потоке. Есть два основных типа паттернов, пространственные и временные. Предположим, у узла есть сотня входов, и два из этих входов, i1 и i2 стали активными одновременно. Если это происходит достаточно часто (гораздо чаще, чем просто случайно), то мы можем предположить, что у i1 и i2 общая причина. Это просто здравый смысл. Если вещи часто возникают вместе, мы можем предположить, что у них общая причина где-то в мире. Другие обобщенные пространственные паттерны могли бы включать несколько причин, возникающих вместе. Скажем, узел идентифицирует пятьдесят обобщенных пространственных паттернов, найденных во входной информации. (Не нужно да и невозможно пересчитать «все» пространственные паттерны, полученные узлом). Когда приходит новый и нестандартный паттерн, узел определяет, насколько близко новый паттерн к ранее изученным 50 паттернам. Узел назначает вероятности, что новый паттерн соответствует каждому из 50 известных паттернов. Эти пространственные паттерны являются точками квантования, которые обсуждались ранее.

Давайте пометим изученные пространственные паттерны от sp1 до sp50. Предположим, узел наблюдает, что с течением времени sp4 чаще всего следует за sp7, и это происходит гораздо чаще, чем может позволить случай. Затем узел может предположить, что временной паттерн sp7-sp4 имеет общую причину. Это также здравый смысл. Если паттерны постоянно следуют один за другим во времени, то они вероятнее всего разделяют общую причину где-то в мире. Предположим, узел хранит 100 обобщенных временных последовательностей. Вероятность того, что каждая из этих последовательностей активна – это выходная информация этого узла. Эти 100 последовательностей представляют 100 причин, изученных этим узлом.

Вот что делают узлы в HTM. В каждый момент времени узел смотрит на входную информацию и назначает вероятность того, что эта входная информация соответствует каждому элементу из множества чаще всего возникающих пространственных паттернов. Затем узел берет это распределение вероятностей и комбинирует его с предыдущим состоянием, чтобы назначить вероятность того, что текущая информация на входе является частью множества чаще всего возникающих временных последовательностей. Распределение по множеству последовательностей является выходной информацией узла и передается вверх по иерархии. В конечном счете, если узел продолжает обучаться, то он мог бы модифицировать множество сохраненных пространственных и временных паттернов для того, чтоб наиболее точно отражать новую информацию.

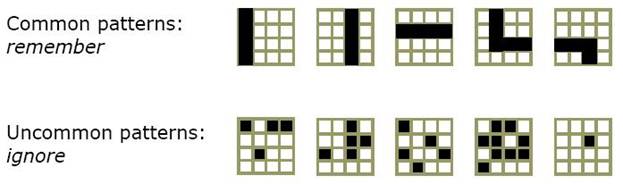

Давайте взглянем для иллюстрации на простой пример из зрительной системы. Рисунок 6 показывает входные паттерны, которые узел мог бы ранее видеть на первом уровне гипотетической визуальной HTM. Этот узел имеет 16 входов, представляющих клочок двоичной картинки 4х4 пиксела. Рисунок показывает несколько возможных паттернов, которые могли бы появиться на этом клочке пикселей. Некоторые их этих паттернов наиболее вероятны, чем другие. Вы можете видеть, что паттерны, которые могли бы быть частью линии или угла будут более вероятными, чем паттерны, выглядящие случайно. Однако, узел не знает, что он смотрин на клочок 4х4 пиксела и не имеет встроенных знаний о том, какие паттерны встречаются чаще и что они могли бы «обозначать». Все, что он видит – это 16 входов, которые могут принимать значения между 0 и 1. Он смотрит на свои входы в течение некоторого промежутка времени и пытается определить, каике паттерны наиболее часто встречаются. Он хранит представления для обобщенных паттернов. Разработчик HTM назначает количество пространственных паттернов или точек квантования, которые данный узел может представлять.

Рисунок 6a

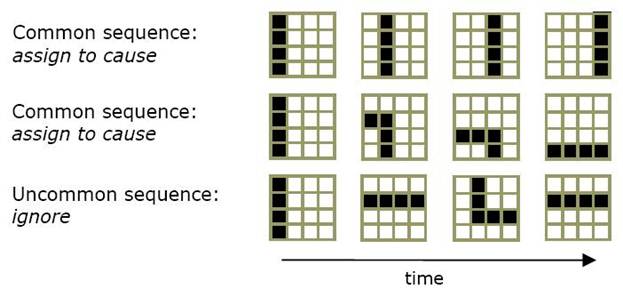

Рисунок 6b показывает три последовательности пространственных паттернов, которые могли бы видеть низкоуровневые визуальные узлы. Первые две строки паттернов являются последовательностями, которые будут вероятнее всего чаще встречаемыми. Вы можете видеть, что они представляют линию, движущуюся слева направо и угол, двигающийся левого верхнего угла в правый нижний. Третья строка это последовательность паттернов, которая маловероятно попадалась узлу. И снова, у узла нет способа узнать, ни то, какие последовательности наиболее вероятны, ни то, что они могли бы обозначать. Все, что он может сделать – это попытаться запомнить наиболее часто встречающиеся последовательности.

Рисунок 6b

В вышеприведенном примере не проиллюстрирована другая общая (но не всегда необходимая) функция узла. Если HTM делает предсказания, она использует свою память последовательностей для предсказания того, какие пространственные паттерны вероятнее всего появятся далее. Это предсказание в форме распределения вероятностей по изученным пространственным паттернам передается вниз по иерархии к дочерним узлам. Предсказание выступает в качестве «предпочтения», влияющего на нижестоящий узел.

Таким образом, мы можем сказать, что каждый узел в HTM сначала учится представлять наиболее часто встречающиеся пространственные паттерны во входном потоке. Затем он обучается представлять наиболее часто возникающие последовательности таких пространственных паттернов. Выход узла, идущий вверх по иерархии, является набором переменных, представляющих последовательности, или, более точно, вероятности того, что эти последовательности активны в данный момент времени. Узел также может передавать предсказываемые пространственные паттерны вниз по иерархии.

До сих пор мы рассматривали простое объяснение того, что делает узел. Сейчас мы обсудим некоторые из опций и проблем.

Обработка распределений и данных из реального мира

Похожая проблема существует и в отношении временных паттернов. Узел должен определить обобщенные последовательности пространственных паттернов, но… Тот факт, что узел всегда видит распределения, обозначает, что в общем случае… Другая проблема возникает сама по себе при изучении последовательностей. Для того, чтобы сформировать…Роль учителя

Только что описанная задача различения «фруктов» и «овощей» ясна, но та же самая задача может возникнуть и в ситуации, подобной ситуации с арбузом.… Такой класс задач решается «в лоб». Обучение корректной категоризации, то есть… Родители, говорящие произносящие слова, такие как «фрукт», вызывают на вершине слуховой иерархии стабильный паттерн…Распознавание статических изображений

Ответ прост. Когда статическое изображение подается на узлы внизу иерархии, узлы формируют распределение по пространственным точкам квантования и на… Это не всегда факт. Вы можете вообразить сцену леса, в которой скрываются…Представление времени

Мы охватили большинство концепций HTM. Следующий раздел дает ответы на наиболее часто задаваемые вопросы по технологии HTM.6. Вопросы

Как мотивация и эмоции укладываются в теорию HTM? Общий вопрос, который мы слышим, это «Кажется, мотивация и эмоции не играют… В биологическом мозге есть несколько систем, задействованных в эмоциональной оценке различных ситуаций. Эти…7. Выводы

HTM охватывают алгоритмические и структурные свойства неокортекса, и, как таковые, представляют первую возможность решить множество ранее неразрешимых задач распознавания паттернов и машинного интеллекта. Проще рассматривать HTM как то, что применимо для задач, которые кажутся простыми людям, но трудны для компьютеров. Однако, алгоритмические свойства HTM очень гибкие, и, следовательно, как только они будут поняты, они могут быть применены к множеству проблем за пределами человеческих способностей.

Возможности

Есть целая иерархия причин, сосуществующих в мире в один момент времени, и HTM строит соответствующую иерархию представлений. Мгновенное значение… Представления, сформированные на вершине иерархии – это высокоуровневые… Обнаружение причин является необходимым первым шагом к дальнейшему распознаванию, но для многих приложений он является…Технология

Сенсорные данные подставляются в самый низ иерархии. Для обучения HTM необходимо предоставить непрерывный, изменяющийся во времени поток данных,… Выдвижение гипотез также выполняется над изменяющейся во времени информацией,… В процессе выдвижения гипотез информация течет вверх по иерархии, начиная с узлов самого нижнего уровня, наиболее…Результаты

Одна из целей корпорации Numenta – максимизировать преимущества технологии HTM. Подход, предпринятый нами для этого – создать платформу, которая… Поскольку HTM моделирует широкомасштабные структуру и функцию неокортекса,… Мы только начали разрабатывать эту новую необозримую парадигму интеллектуальных вычислений, основанную на технологии…– Конец работы –

Используемые теги: про, интеллект, Временная, иерархическая, Память0.081

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ: Про Интеллект. Временная иерархическая память

Что будем делать с полученным материалом:

Если этот материал оказался полезным для Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Хотите получать на электронную почту самые свежие новости?

Новости и инфо для студентов